11 F 其他金融时间序列与缩尾处理后的交易量

📜 [原文1]

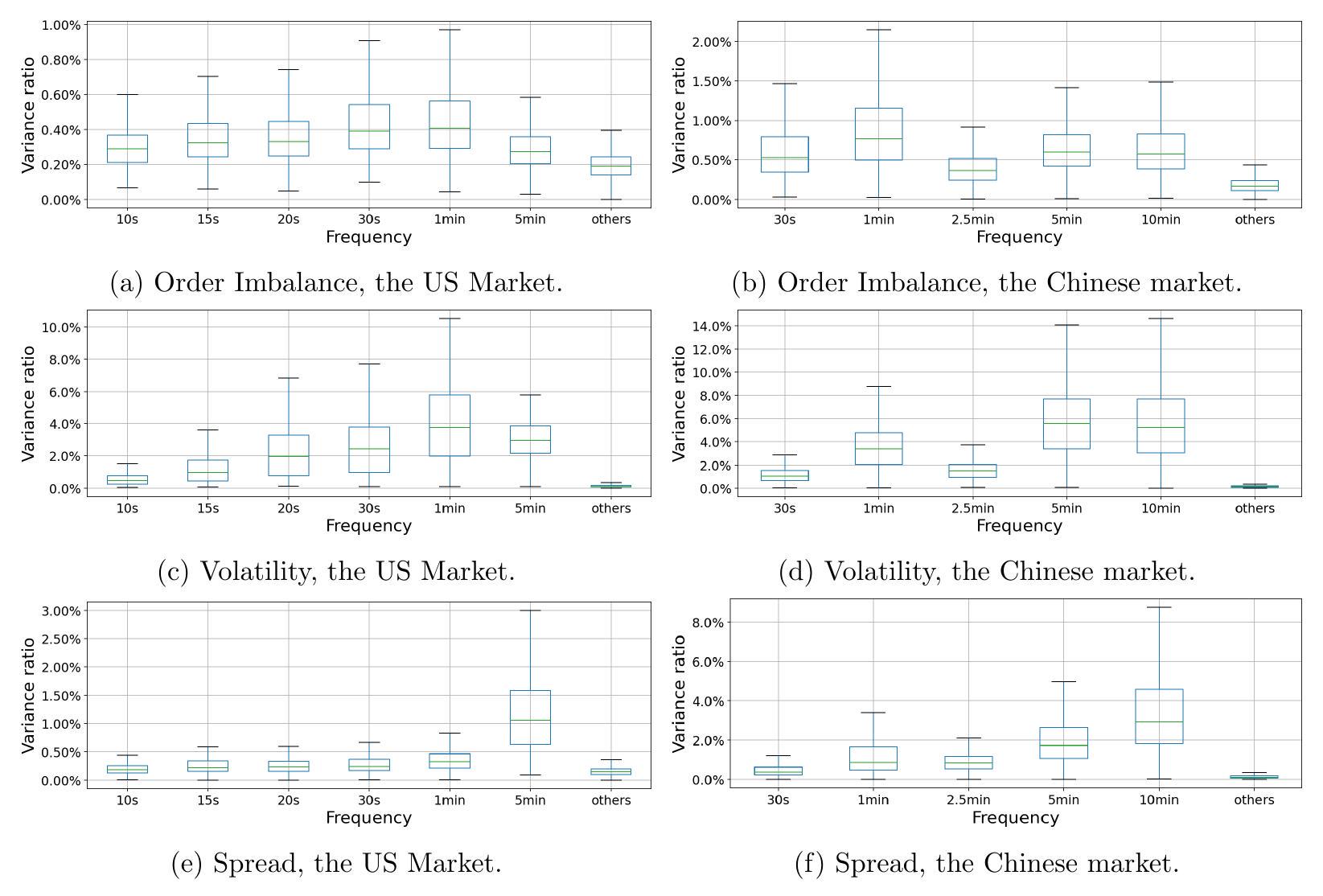

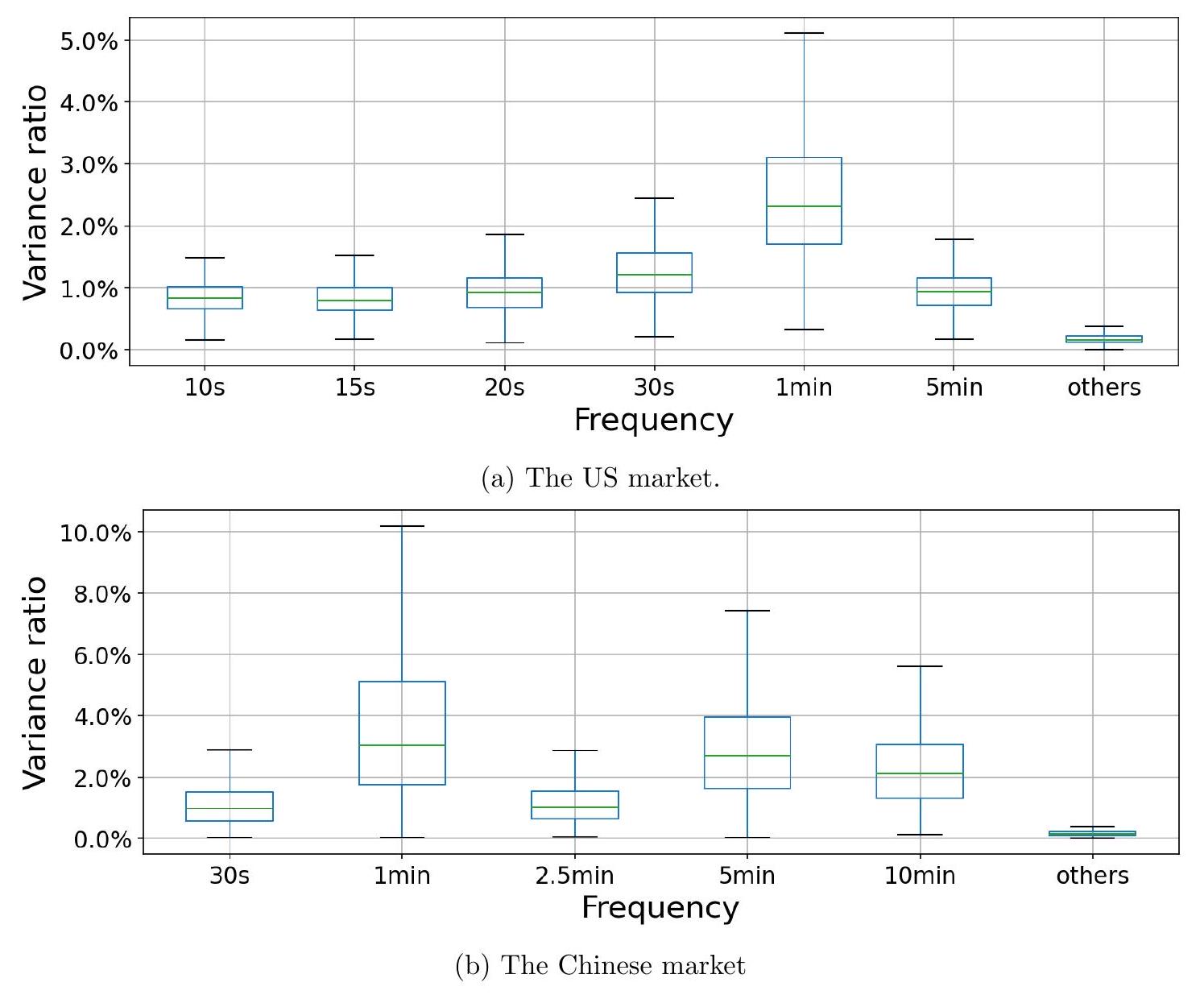

继 Heston, Korajczyk, and Sadka (2010) 之后,我们在我们论文中使用的数据集上计算了订单不平衡、波动率和价差的日内时间序列。图 A. 6 是美国市场和中国市场中不同度量的 fVR 的箱线图。我们发现,在两个市场中,波动率和价差都存在显著的周期性,这与我们在 5.2.2 节中关于价格影响的结果以及波动率和价差的变动与交易量变动相关的事实(Heston, Korajczyk, and Sadka, 2010)相一致。然而,我们没有发现订单不平衡周期性的显著证据。我们关于这三种不同度量的结果都与 Heston, Korajczyk, and Sadka (2010) 的结果一致。

这段话是论文附录部分的一个引言,旨在通过分析除交易量之外的其他几个重要金融市场微观结构变量,来拓展和验证论文核心发现的稳健性。作者们明确指出,他们的研究方法和发现可以与领域内一篇重要的参考文献——Heston, Korajczyk, and Sadka (2010)——的结果进行对比和印证。

- 研究背景与文献继承:

- 开头“继 Heston, Korajczyk, and Sadka (2010) 之后”表明,本研究并非凭空而来,而是建立在已有学术成果的基础之上。这篇2010年的论文是金融领域研究日内模式(intraday patterns)的经典文献之一,它系统地研究了多种市场变量的周期性行为。通过引用这篇文献,作者为自己的研究提供了理论依据和比较基准。

- 研究对象扩展:

- 核心研究内容是计算了三种新的日内时间序列:订单不平衡、波动率和价差。这三种都是衡量市场活动和状态的关键指标。

- 订单不平衡 (Order Imbalance):这是一个衡量买方发起的交易量与卖方发起的交易量之间差异的指标。

- 定义:通常计算为 (买入订单量 - 卖出订单量) / (总订单量)。正值表示买方力量更强,负值表示卖方力量更强。

- 意义:它被认为是市场价格变动的领先指标。大量的买入不平衡预示着价格可能上涨,反之亦然。研究其周期性,是为了探究市场参与者的交易意图是否存在规律性的日内模式。

- 波动率 (Volatility):衡量资产价格在一定时间内的波动程度。

- 定义:通常用收益率的标准差来度量。日内波动率则是在交易日内部,以更高频率(如每分钟、每5分钟)计算的价格波动。

- 意义:波动率是风险的直接体现,高波动率意味着高风险和高不确定性。研究其周期性,可以揭示市场风险水平的日内变化规律,例如著名的开盘和收盘时段波动率更高的“U型”模式。

- 价差 (Spread):通常指买卖价差(Bid-Ask Spread)。

- 定义:指的是市场上愿意购买一支证券的最高价格(买入价,Bid)与愿意卖出该证券的最低价格(卖出价,Ask)之间的差额。

- 意义:价差是衡量市场流动性成本的核心指标。价差越小,流动性越好,交易成本越低。研究其周期性,可以了解流动性提供和消耗的日内节律。

- 核心发现与图表引用:

- 作者通过“图 A.6”来展示他们的发现。这个图是一个箱线图(Boxplot),用于展示一组数据的分布情况,包括中位数、四分位数、最大值和最小值。

- 图 A.6比较了上述三个度量(订单不平衡、波动率、价差)的频率方差比(fVR)。fVR是本文用来量化周期性强度的核心指标。

- 发现1:波动率和价差存在显著周期性。这意味着波动率和价差的fVR值显著高于随机噪声的基准水平。这与直觉和已有研究相符,因为市场开盘和收盘时段,信息流动快,交易活跃,通常导致波动率和价差扩大,而在午间休市前后则相对平稳。

- 发现2:订单不平衡没有显著周期性。这意味着订单不平衡的fVR值与随机基准没有显著差异。这表明,尽管买卖力量对比在驱动价格,但这种力量对比的日内模式并不像交易量、波动率那样具有普遍和强烈的周期性。

- 跨市场一致性:这些发现在美国和中国两个市场都是成立的,增强了结论的普适性。

- 与已有研究的关联和验证:

- 作者强调,他们的发现——波动率和价差有周期性,而订单不平衡没有——与Heston, Korajczyk, and Sadka (2010)的研究结果是“一致的”。这有两个作用:

- 验证了自身研究的可靠性:当使用不同的数据集和可能略有差异的方法得到与经典文献相同的结论时,说明研究结果是稳健的。

- 强化了该现象的普遍性:再次确认了这些金融市场变量的内在属性。

- 还提到了与论文“5.2.2节中关于价格影响的结果”相一致。价格影响(Price Impact)是指一笔交易对资产价格产生的推动作用。通常交易量越大,价格影响越大。而波动率和价差的变动也与交易量变动高度相关(这也是Heston等人文献的观点),因此,这些变量共同表现出周期性是符合逻辑的。

- 示例1:fVR的直观理解

假设我们有一个波动率的日内时间序列,共有480个数据点(每分钟一个数据,共8小时)。我们计算其总方差为100。然后,我们使用论文中的模型,发现由“日内周期性成分”(如开盘、收盘、午间等特定频率)解释的方差为25。那么,频率方差比(fVR)就是 25 / 100 = 25%。如果一个完全随机的时间序列,其fVR接近于0(在本文模型中是0.2%)。一个高达25%的fVR值就表明波动率具有非常强的周期性。相比之下,如果订单不平衡的总方差也是100,但其周期性成分解释的方差只有0.5,那么fVR就是 0.5 / 100 = 0.5%,这个值非常接近基准,因此可以判断其周期性不显著。

- 示例2:订单不平衡的计算

假设在上午9:31这一分钟内,某只股票的交易情况如下:

- 总共有50笔交易。

- 其中,由投资者主动发起的买入交易(taker buys)有30笔,总成交量为3000股。

- 由投资者主动发起的卖出交易(taker sells)有20笔,总成交量为2000股。

- 订单不平衡(按笔数)= (30 - 20) / (30 + 20) = 10 / 50 = 0.2。

- 订单不平衡(按成交量)= (3000 - 2000) / (3000 + 2000) = 1000 / 5000 = 0.2。

这个正值表示在这一分钟内,买方力量稍强。研究人员会计算每一分钟的这个值,形成一个时间序列,然后分析这个序列是否存在周期性。作者的结论是,这个序列的波动看起来更像是随机的,没有像交易量那样固定的高低峰模式。

- 误解fVR:fVR不是衡量变量本身的大小,而是衡量其“周期性”的强度。一个变量的数值可以很大,但如果它没有规律的日内模式,其fVR也会很低。

- “不显著”不等于“不存在”:论文说没有发现订单不平衡周期性的“显著”证据,这不代表完全没有一丁点周期性。在统计学上,“不显著”意味着观察到的模式很可能仅仅是由随机偶然性造成的,没有足够的证据支持它是一个真实、稳定的规律。

- 指标计算方法的差异:订单不平衡、波动率和价差都有多种计算方式。例如,波动率可以用已实现波动率(realized volatility)、高低价差等多种方法估计。作者们遵循了Heston等人的方法,这保证了可比性,但如果换一种计算方法,结果可能会有细微差别,尽管大的结论(波动率和价差有周期性)通常是稳健的。

- 数据来源和清洗:这些微观结构变量的计算高度依赖于高质量的逐笔交易(tick-by-tick)数据。数据的清洗、交易的归类(是买方发起还是卖方发起,即trade classification)等预处理步骤对结果至关重要,任何差异都可能影响最终结论。

本段将论文的核心分析框架(fVR)应用到了交易量之外的三个关键金融变量上:订单不平衡、波动率和价差。研究发现,在美国和中国市场,波动率和价差都表现出与交易量类似的强日内周期性,而订单不平衡则没有显著的周期性模式。这些发现与领域内的经典文献结果一致,从而增强了论文结论的可靠性和普适性。

本段的存在有三个主要目的:

- 稳健性检验 (Robustness Check):展示论文提出的周期性分析框架不仅适用于交易量,也适用于其他相关的金融时间序列,证明了方法的广泛适用性。

- 深化理解:通过对比不同变量的周期性强弱,帮助读者更深入地理解日内交易活动的本质。例如,交易量、波动率和价差的同步周期性共同指向了市场活动(交易活跃度、风险、成本)的节律性,而订单不平衡的非周期性则暗示了驱动价格的信息流可能在日内分布得更为随机。

- 学术对话:将本研究的结果与Heston, Korajczyk, and Sadka (2010)这篇权威文献进行直接比较,一方面显示了对前人研究的尊重和继承,另一方面也通过结果的一致性来为自己的研究提供强有力的外部验证。

想象一个城市的交通状况。

- 交易量就像是“车流量”。每天早高峰(开盘)和晚高峰(收盘)车流量巨大,中午(午休)则相对稀少,这是一个非常明显的周期性模式。

- 波动率就像是“堵车或事故风险”。车流量大的高峰期,发生拥堵、刮蹭等事件的风险也更高,所以风险(波动率)也呈现高峰期高、平峰期低的周期性。

- 价差就像是“打车的溢价或找停车位的难度”。高峰期车多、需求旺盛,打车平台会加价,停车位也难找,这些“交易成本”(价差)也随之上升,呈现周期性。

- 订单不平衡就像是“想进城和想出城的车辆比例”。虽然整体车流量有高峰,但任何特定时刻,想进城和想出城的车流比例可能变化莫测,没有一个固定的模式说“早上9点一定是进城车比出城车多10%”,这个比例可能受到当天天气、特定事件等随机因素影响,因此不表现出强烈的周期性。

想象你在观察一个蜂巢。

- 交易量是蜜蜂进出蜂巢的总频率。清晨和傍晚,蜜蜂活动最频繁,进进出出非常忙碌(高交易量)。中午阳光最烈时,它们可能活动减少(低交易量)。这是一个非常规律的日内节律。

- 波动率和价差是蜂巢入口处的“拥挤”和“混乱”程度。在蜜蜂最活跃的时段,入口处会显得非常拥挤,蜜蜂之间差点撞上(高波动率),进出一趟要花费更多精力(高价差)。这个拥挤程度也随着蜜蜂的活动频率呈现周期性。

- 订单不平衡是出去采蜜的蜜蜂和满载花粉归来的蜜蜂的数量差。虽然总体上早出晚归,但在任何一分钟,这个净流向可能受到外面哪片花田突然开放、天气突变等不可预测因素的影响,因此这个“净流入/流出”的模式看起来杂乱无章,没有固定的周期。

📜 [原文2]

图 A.6:不同度量的频率方差比 (fVR) 的箱线图。如果没有周期性存在,基准 fVR 为 $\frac{1}{500}=0.2 \%$,因为我们在模型中包含了 $n=500$ 个周期性成分。

这部分是对图A.6的描述和解释。虽然我们无法直接看到图片,但可以通过文字描述来完全理解其内容和含义。

- 图表类型和内容:

- 类型:箱线图 (Boxplot)。这是一种标准化的方式,用于显示数据的分布情况。每个“箱子”代表一个组的数据。

- Y轴:频率方差比 (fVR)。这个值越高,表示该度量的周期性越强。

- X轴:不同的“度量”和市场。根据上一段的上下文,这些度量包括订单不平衡 (Order Imbalance)、波动率 (Volatility) 和价差 (Spread)。图表会为美国市场和中国市场分别展示这三个度量的fVR分布。所以X轴上至少有 2 (市场) * 3 (度量) = 6 个箱子。

- 每个箱子代表什么:每个箱线图都总结了在特定市场(如美国)和特定度量(如波动率)下,所有股票、所有交易日的fVR值的分布情况。它会显示中位数(箱子中间的线)、四分位数(箱子的上下边界)、以及可能的异常值(点)。

- 核心信息解读:

- 基准fVR:图的说明中给出了一个关键的参考值:0.2%。这个值是“无周期性”的基准线。

- 基准的来源:这个 0.2% 是怎么来的呢?它等于 $\frac{1}{n}$,其中 $n=500$ 是模型中包含的周期性成分的数量。可以这样理解:如果一个时间序列完全是随机噪声,没有任何真实的周期性,那么它的总方差会“平均”地分布在这500个假设的周期性成分上。因此,任何一个单一频率(或者所有周期性频率加总)所能解释的方差大约就只占总方差的 $\frac{1}{500}$,即 0.2%。

- 如何使用基准:观察箱线图时,如果一个箱子的主体(特别是中位数和下四分位数)远高于 0.2% 这条水平线,我们就说这个度量存在“显著的周期性”。如果箱子紧贴着 0.2%,甚至中位数就在其附近,那就意味着周期性不显著。

- 预期看到的景象(根据上一段文字):

- 波动率和价差的箱线图:对于美国和中国市场的波动率和价差,它们的箱线图会显著高于 0.2% 的基准线。例如,它们的中位数可能在5%、10%甚至更高,整个箱体都远远飘在基准线之上。

- 订单不平衡的箱线图:对于订单不平衡,它的箱线图会非常贴近 0.2% 的基准线。中位数可能就在 0.2% 附近,箱体的大部分区域也和基准线重合,这直观地显示了其周期性的缺乏。

- 公式: $fVR_{benchmark} = \frac{1}{500} = 0.2\%$

- fVR: 频率方差比 (Frequency Variance Ratio) 的缩写。它衡量的是由模型中的周期性部分所解释的方差占总方差的比例。

- $fVR_{benchmark}$: 基准频率方差比。这是一个理论值,代表当一个时间序列完全没有周期性(即纯随机噪声)时,我们期望看到的fVR值。

- 500: 这是模型参数 $n$,代表模型试图从数据中识别的潜在周期性成分(或称傅里叶频率)的数量。作者选择了一个足够大的数字来覆盖所有可能感兴趣的日内频率。

- 推导/逻辑: 想象一下,总方差是一个大蛋糕。我们有500个“频率”盘子来分这个蛋糕。如果数据是纯随机的,没有任何特定的周期性,那么没有任何一个盘子有理由分到比其他盘子更多的蛋糕。因此,蛋糕会被平均分配。每个盘子分到的蛋糕份额就是总蛋糕的 $\frac{1}{500}$。fVR衡量的是所有这些周期性盘子合起来分到的蛋糕比例(在这个语境下,作者似乎是将fVR定义为被选定的一组“重要”周期频率解释的方差比例,但这个基准是基于单个频率的期望贡献来设定的)。当没有周期性时,单个频率的贡献期望就是 $\frac{1}{500}$。

- 示例1: 显著周期性的情况

假设图A.6中,美国市场波动率的箱线图显示:

- 下边缘 (最小值): 1%

- 下四分位数 (Q1): 8%

- 中位数 (Median): 15%

- 上四分位数 (Q3): 25%

- 上边缘 (最大值): 40%

我们看到,即使是fVR最低的股票(1%),其值也远高于 0.2% 的基准。整个箱体都“悬浮”在基准线之上。这提供了强有力的视觉证据,表明波动率普遍存在显著的日内周期性。

- 示例2: 不显著周期性的情况

假设图A.6中,中国市场订单不平衡的箱线图显示:

- 下边缘 (最小值): 0.01%

- 下四分位数 (Q1): 0.1%

- 中位数 (Median): 0.18%

- 上四分位数 (Q3): 0.3%

- 上边缘 (最大值): 1.2%

在这个假设的例子中,中位数 0.18% 非常接近甚至略低于 0.2% 的基准。箱子的下半部分完全低于基准线,上四分位数也仅仅比基准高出一点点。这表明,对于大多数股票而言,订单不平衡的周期性强度与随机噪声无法区分。

- n的选择: 基准fVR的值依赖于模型中周期性成分的数量 $n$。如果作者选择了 $n=1000$,那么基准就会变成 0.1%。因此,在解读fVR时,必须知道所使用的 $n$ 是多少。这个 $n$ 的选择本身也有一定的任意性,但通常会选择一个足够大的数以保证频率分辨率。

- 对数尺度: 有时为了更好地展示分布,特别是当数据跨越几个数量级时,Y轴(fVR)可能会使用对数尺度。如果使用对数尺度,那么 0.2% 这条基准线的位置需要仔细辨认,视觉上的距离不再是线性的。

- 箱线图的“须”和“异常值”: 箱线图的“须”(whiskers)延伸到哪里,以及哪些点被视为异常值,有不同的定义(例如,1.5倍的四分位距)。这会影响图形的视觉表现,但通常不会改变关于分布主体位置的核心结论。

图A.6的说明文字提供了理解该图的关键信息。它是一个比较不同金融度量(订单不平衡、波动率、价差)周期性强度的箱线图,Y轴为频率方差比(fVR)。最关键的信息是提供了一个 0.2% 的“无周期性”基准线,该基准由模型中使用的周期性成分数量($n=500$)决定。通过比较各个度量的fVR分布与这个基准线的相对位置,可以直观地判断它们的周期性是否显著。

这部分文字的存在是为了服务于图A.6,使其能够自我解释。其目的如下:

- 定义图表: 明确指出图A.6是关于什么的——一个展示不同度量fVR的箱线图。

- 提供解读钥匙: 给出 0.2% 这个至关重要的基准值。没有这个基准,读者就无法判断图中的fVR值是大还是小,是显著还是不显著。

- 解释基准来源: 解释了 0.2% 是如何通过模型参数 $n=500$ 计算得来的 ($\frac{1}{500}$),增加了研究的透明度和科学性。这让读者明白这个基准不是一个随意设定的数字,而是有其理论依据的。

想象一个才艺比赛,有500个评委($n=500$)。

- fVR是某个选手(某个金融度量,如波动率)获得的总分占满分的百分比。

- 基准fVR 0.2% 是“同情分”。如果一个选手上台毫无才艺,只是站着不动(纯随机噪声),评委们出于礼貌,可能还是会随便给点分。由于评委太多,大家给的分很分散,平均下来,这位选手获得的总分可能只占满分的 1/500 = 0.2%。

- 看图A.6 就好比看比赛结果榜:

- 波动率和价差这两位选手,得分很高,比如15%、25%,远超 0.2% 的同情分,说明他们是真正的实力派(有显著周期性)。

- 订单不平衡这位选手,得分就在 0.2% 左右徘徊,说明他/她的表现和那个站着不动的选手没啥区别,被认为是“没有才艺”(周期性不显著)。

想象你在用一个非常灵敏的收音机调频。

- 收音机有500个频道刻度 ($n=500$)。

- 总方差是收音机收到的所有声音的总音量。

- fVR是某个特定“音乐”频道(周期性信号)的音量占总音量的比例。

- 当你把收音机调到一个没有电台的频率时,你只能听到“沙沙”的白噪声。这个白噪声的总音量分布在所有500个频道上。因此,任何一个刻度上,你听到的噪声强度大约就是总强度的 1/500。这就是基准fVR 0.2%。

- 分析图A.6 就是:

- 当你分析波动率和价差时,收音机在某些特定频率上(比如代表“30分钟”的频道)发出了清晰、响亮的音乐,其音量远超周围的“沙沙”声。这表明有强烈的周期信号。

- 当你分析订单不平衡时,收音机在所有频率上都只有“沙沙”声,没有哪个频道能脱颖而出。这表明没有捕捉到任何有意义的周期信号。

📜 [原文3]

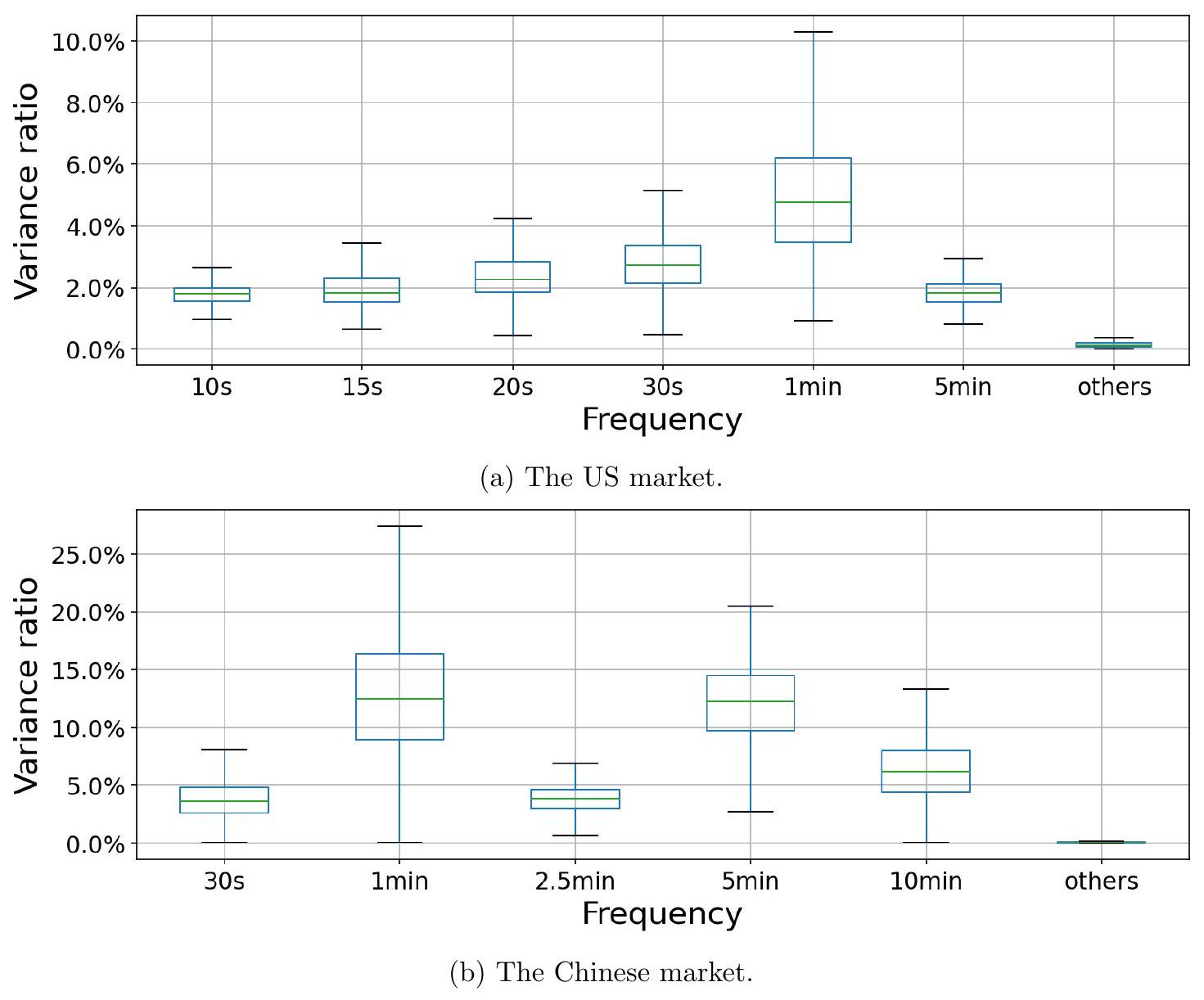

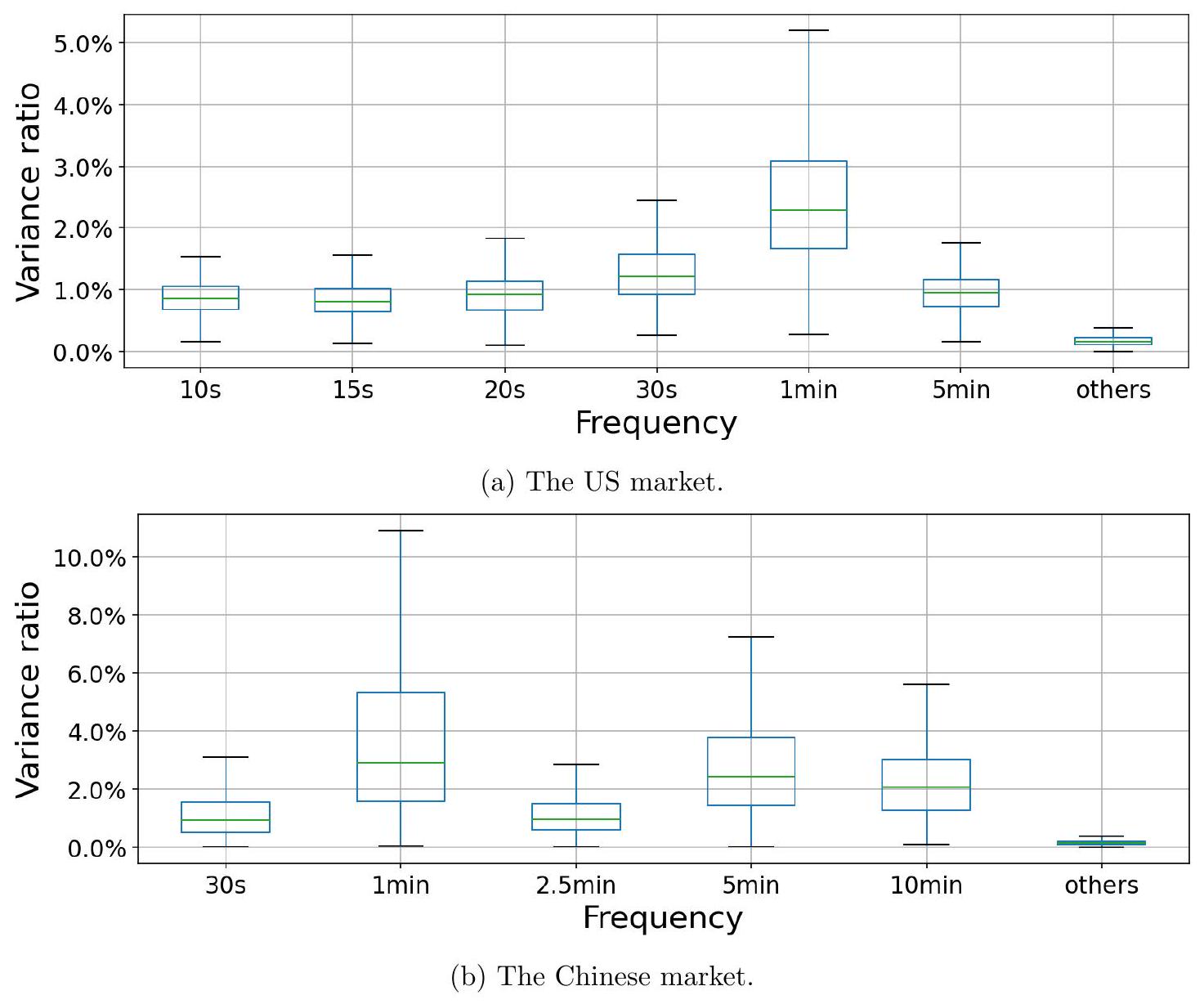

作为稳健性检验,对于每只股票和每个交易日,我们将日内交易量数据在第 95 百分位数进行缩尾处理,以减少极端数据对 fVR 的影响。图 A.7 显示了缩尾处理后 fVRs 的箱线图。周期性保持稳健。在美国市场的 1 分钟和 30 秒频率以及中国市场的 10 分钟、5 分钟和 1 分钟频率下,上四分位数条略高于缩尾处理前。这一结果表明,由于极端数据带来的噪声减少,一些股票获得了更高的 fVRs。

这部分内容进行了一项稳健性检验 (Robustness Check),目的是验证论文之前关于交易量周期性的主要发现,是否会因为数据中的极端值(异常高的交易量)而产生偏差。

- 检验动机:

- 金融市场数据,特别是交易量,经常会出现一些极端值。例如,某只股票在某分钟内可能因为一则重大新闻、一笔巨大的机构交易或者算法交易的集中触发,导致交易量瞬间飙升到平时的几十倍甚至上百倍。

- 这些极端值,在统计学上被称为“异常值”或“离群点”(outliers)。它们可能会对统计分析结果产生过度的影响。具体到本文的fVR计算,一个极大的交易量值会极大地增加时间序列的总方差。如果这个极端值恰好出现在一个非周期性的时间点,它可能会“稀释”周期性的相对强度,从而压低计算出的fVR值。反之,如果它偶然出现在一个周期性高点,也可能夸大fVR。

- 因此,研究人员需要确认他们的结论“交易量存在显著周期性”不是由这些极端值驱动的假象。

- 检验方法:缩尾处理 (Winsorization)

- “作为稳健性检验”: 明确了本段的性质。

- “对于每只股票和每个交易日”: 这个处理是精细化的,在最细的颗粒度上进行的。不是对所有股票所有数据一起处理,而是独立地对“A股票在2019年1月2日”的日内交易量序列进行处理,然后对“A股票在2019年1月3日”的序列处理,再对“B股票在2019年1月2日”的序列处理……以此类推。

- “将日内交易量数据在第 95 百分位数进行缩尾处理”: 这是具体的操作。

- 第 95 百分位数 (95th percentile):对于某只股票某一天内的所有分钟交易量数据,将它们从小到大排序,排在第95%位置的那个值就是第95百分位数。例如,一天有240分钟的交易数据,排序后第 240 * 0.95 = 228 位的数值。

- 缩尾处理 (Winsorization):它的意思是,将所有大于第95百分位数的值,都强制替换为第95百分位数的值。同时,也可以对低位进行同样操作(比如将所有小于第5百分位数的值替换为第5百分位数的值),但这里只提到了高位处理。

- 举例: 假设某股票某日分钟交易量数据中,第95百分位数是10000股。现在有一个数据点是50000股,因为它超过了10000股,所以在缩尾处理后,这个50000股就被改写成了10000股。另一个数据点是9000股,因为它没超过10000股,所以它保持不变。

- 与“截尾处理 (Trimming)”的区别:截尾是直接删除超过阈值的数据,而缩尾是用阈值本身去替换它们。缩尾保留了数据点的数量,只是减小了其极端程度。

- 结果与分析:

- “图 A.7 显示了缩尾处理后 fVRs 的箱线图”: 这意味着作者用处理过的数据重新计算了所有股票所有交易日的fVR,并绘制了新的箱线图,以便与未经处理的数据得出的fVR图(原文中的图4)进行比较。

- “周期性保持稳健”: 这是核心结论。意味着即使在削弱了极端交易量的影响后,fVR的分布情况(中位数、四分位数等)与之前相比没有发生根本性的改变。交易量的周期性依然非常显著。这证明了论文的主要发现不是由少数极端值造成的。

- 一个有趣的细节发现: “在美国市场的 1 分钟和 30 秒频率以及中国市场的 10 分钟、5 分钟和 1 分钟频率下,上四分位数条略高于缩尾处理前。”

- 上四分位数条 (Upper Quartile Bar): 箱线图的箱体上边缘,代表了fVR值排在前25%的水平。

- “略高于缩尾处理前”: 这意味着,在进行了缩尾处理后,fVR值最高的那些股票,它们的fVR值反而变得更高了。

- 对细节的解释: “这一结果表明,由于极端数据带来的噪声减少,一些股票获得了更高的 fVRs。”

- 逻辑: 极端的交易量尖峰,如果它不是周期性行为的一部分,就会被模型视为“噪声”。这种噪声会不成比例地增大全序列的“总方差”(fVR计算公式的分母)。当使用缩尾处理把这些极端噪声“压平”后,总方差减小了。而周期性部分贡献的方差(分子)可能保持不变或受影响较小。因此,根据fVR = (周期性方差) / (总方差),分母变小了,整个比率(fVR)就变大了。

- 这说明: 对于某些股票来说,原始数据中的极端值实际上是在“掩盖”或“削弱”其真实的周期性强度。去除了这些极端值的干扰后,其内在的周期性模式反而更加清晰地显现出来。

- 示例1: 缩尾处理操作

假设某股票某日,每10分钟的交易量数据如下(共6个数据点):

[100, 120, 90, 500, 110, 130]

- 排序: [90, 100, 110, 120, 130, 500]

- 计算第95百分位数:这里数据点少,我们假设用一个类似的阈值,比如第85百分位数,即第 6 * 0.85 = 5.1 位,大约是130。我们设阈值为130。

- 进行缩尾处理:找到所有大于130的值,这里只有500。

- 用130替换500。

- 处理后的新数据序列为: [100, 120, 90, 130, 110, 130]。

可以看到,那个异常高的500被“拉回”到了与其他数据点相当的水平,而其他数据点保持不变。

- 示例2: fVR为何会升高

假设一个简化的时间序列 V = [10, 100, 10, 100, 10, 1000]。这个序列有明显的“一低一高”的模式,但最后一个点1000是一个极端异常值。

- 原始数据:

- 周期性部分(假设是交替模式)可以解释的方差,我们粗略估计为与 [10, 100, 10, 100, 10, 100] 相关的方差,假设是 A。

- 总方差 Var(V) 会因为 1000 这个值而变得巨大,假设是 B。

- 原始 fVR ≈ A / B。

- 缩尾处理后:

- 假设第95百分位数是100。序列变为 V' = [10, 100, 10, 100, 10, 100]。

- 现在,周期性部分解释的方差几乎就是全部方差,我们称之为 A'。A' 约等于 A。

- 总方差 Var(V') 大大减小了,因为没有了1000的影响。我们称之为 B'。显然 B' << B。

- 新的 fVR' ≈ A' / B'。

- 比较: 因为 A' ≈ A 且 B' << B,所以 fVR' > fVR。这就解释了为什么去除极端噪声后,fVR反而可能上升。

- 百分位数的选择: 选择95%作为阈值是比较常见的做法,但也有研究使用99%或90%。这个选择会影响有多少数据被处理,进而影响结果。选择过低的百分位数(如80%)可能会削弱真实的、但幅度较大的周期性波动;选择过高的百分位数(如99.9%)可能又无法有效去除所有有害的异常值。这里的95%是一个权衡。

- 并非所有股票fVR都升高: 原文说的是“一些股票”获得了更高的fVR,并且是“上四分位数条”升高。这意味着这种效应主要体现在那些原本周期性就很强,但又受到极端值干扰的股票上。对于那些周期性本就很弱,或者没有极端值的股票,缩尾处理可能影响甚微,甚至可能因为改变了数据分布而略微降低fVR。

- 缩尾处理的争议: 虽然缩尾是处理异常值的常用方法,但它也改变了原始数据。有观点认为任何对原始数据的修改都应谨慎。因此,这种方法通常只在稳健性检验中使用,以证明主要结论不依赖于这些被修改的数据点。正文的分析仍然基于未经处理的原始数据。

本段通过对日内交易量数据进行95百分位数缩尾处理,进行了一项关键的稳健性检验。结果显示,在去除了极端高交易量值的影响后,原先发现的交易量周期性依然存在且稳健。更有趣的是,对于部分股票,去除这些被视为“噪声”的极端值后,其周期性强度指标fVR反而有所提升,这进一步确证了其内在周期性模式的真实性和强度。

- 增强结论的可信度 (Increase Credibility): 这是稳健性检验的核心目的。它向读者和审稿人证明,论文的关键发现(交易量的强周期性)不是由数据中的几个异常值“侥幸”造成的,而是一个普遍、内在的特性。

- 展示研究的严谨性 (Show Rigor): 一个高质量的实证研究必须考虑到数据可能存在的各种问题。主动识别并处理异常值问题,表明作者对数据有深刻的理解,并采取了严谨的步骤来确保结论的可靠性。

- 提供更深入的洞见 (Provide Deeper Insight):fVR在缩尾后不降反升的现象,本身就是一个有趣的发现。它揭示了极端交易(可能是信息驱动的,也可能是流动性事件)与常规周期性交易之间的复杂关系,暗示了原始数据中的“噪声”有时会掩盖信号,而不是增强信号。

想象一下你在听一场交响乐,但现场有一个小孩偶尔会尖叫一声。

- 交响乐的旋律:这是交易量的内在周期性。比如,乐章的高潮和低谷部分。

- 小孩的尖叫:这是一个极端异常值(outlier)。

- 你的耳朵(作为分析工具):

- 未经处理时:小孩的尖叫声非常刺耳,会让你对整场音乐的“总音量”(总方差)感知大大增加。尖叫声可能会暂时盖过音乐的旋律,让你觉得音乐的“旋律感”(周期性强度fVR)被干扰了,相对不那么突出。

- 进行缩尾处理:相当于你戴上了一副智能降噪耳机,它能识别出尖叫声并把它压低到和交响乐正常音量差不多的水平。

- 处理后的感受:去掉了尖叫声的干扰后,交响乐的旋律和节奏变得更加清晰、纯粹。你现在更能感受到乐曲的结构和美感,因此你对音乐“旋律感”(fVR)的评价反而更高了。

想象你在看一幅画,画的是规律的海浪(周期性)。但是,有几滴非常大、非常黑的墨水不小心溅到了画布上(极端值)。

- 原始的画: 这些大墨点非常扎眼,它们破坏了海浪的整体美感。虽然你仍然能看出是海浪,但这些墨点(噪声)增加了画面的“总混乱度”(总方差),使得海浪的规律性(fVR)显得不那么完美。

- 进行缩尾处理: 相当于一个修复师小心翼翼地将这些大墨点擦掉,并用与周围海浪颜色相近的颜色填补。修复师并没有把墨点所在的地方挖掉(不是截尾),而是把它修复成“正常”的样子(缩尾)。

- 修复后的画: 修复之后,画布变得干净了,海浪的规律起伏和优美线条(周期性)更加突出。你现在看这幅画,会觉得它的“艺术规律性”(fVR)比之前更高、更纯粹。

📜 [原文4]

图 A.7:2019-2021年所有股票的频率方差比 (fVR)——由选定频率解释的方差与去趋势时间序列总方差之比——的箱线图。对于每只股票和每个交易日,日内交易量序列在第 95 百分位数处进行截断。所有其他频率被归入“其他”类别。如果没有周期性存在,基准 fVR 为 $\frac{1}{500}=0.2 \%$,因为我们在模型中包含了 $n=500$ 个周期性成分。

这部分是对图A.7的详细说明。图A.7是上一段描述的稳健性检验结果的视觉呈现。

- 图表核心内容:

- 图表标题: 明确指出这是“频率方差比 (fVR)”的“箱线图”,数据涵盖“2019-2021年所有股票”。

- 核心操作: 图中展示的fVR是基于经过特殊处理的数据计算得出的。这个处理是“对于每只股票和每个交易日,日内交易量序列在第 95 百分位数处进行截断”。

- 注意: 这里的用词是“截断”(truncated),但在上一段的描述和“缩尾”的通用定义中,该操作更像是“缩尾”(winsorized)。在学术论文中,这两个词有时会被不严格地混用,但从上下文来看,其操作是用95百分位数的值去替换更高的值。我们按照这个理解继续。

- fVR的定义复述: “由选定频率解释的方差与去趋势时间序列总方差之比”。这再次强调了fVR的计算方法,分子是“选定频率解释的方差”,分母是“总方差”。“去趋势”表明在计算方差前,已经移除了日内可能存在的线性趋势(比如交易量随时间单调增加或减少)。

- 频率分组: “所有其他频率被归入‘其他’类别”。这说明图A.7的X轴上,除了几个被重点关注的周期(如30分钟、5分钟、1分钟等),还会有一个名为“其他(Other)”的类别,它代表了所有未被单独列出的频率所解释的方差之和。这有助于展示选定频率的相对重要性。

- 基准线: 再次重申了与图A.6相同的基准:“如果没有周期性存在,基准 fVR 为 $\frac{1}{500}=0.2 \%$”。这为读者提供了判断周期性是否显著的标尺。

- 图表结构预测:

- Y轴: fVR值,从0开始。会有一条在0.2%位置的水平虚线作为基准。

- X轴: 应该是不同的市场(美国、中国),在每个市场下,再按不同的频率(如30分钟、5分钟、1分钟、30秒等)以及“其他”类别,分别绘制箱线图。这与论文正文中的主要fVR图(图4)的结构应该是一致的,以便于直接比较。

- 与图4的比较: 图A.7的整体形态应该和图4非常相似,这才能得出“周期性保持稳健”的结论。主要区别可能在于箱体的位置会发生微小的变化,特别是如前文所述,某些频率的上四分位数会略微升高。

- 公式: $fVR_{benchmark} = \frac{1}{500} = 0.2\%$

- 这与图A.6中的公式完全相同,其解释也完全适用。它代表了在当前模型设定下,一个纯随机过程的预期fVR水平。

- fVR: 频率方差比。

- 500: 模型中考虑的周期性成分(频率)总数,即 $n$。

- 0.2%: 在无周期性假设下,方差平均分配到500个频率上,每个频率或一小组频率期望解释的方差比例。

- 一个细节:“截断” vs “缩尾”

- 严格来说,截断 (Truncation / Trimming) 是指直接删除数据。例如,删除所有大于95百分位数的数据点。这会导致时间序列的长度发生变化,处理起来更复杂。

- 缩尾 (Winsorization) 是指用边界值替换超出边界的数据。这保留了数据点的数量和时间位置。

- 论文中此处用了“截断”一词,但结合上一段的描述(“减少极端数据对fVR的影响”)和金融数据处理的常规做法,作者极大概率执行的是“缩尾”操作。这种用词上的不精确在部分文献中存在。重要的是理解其操作的实质:限制极端值的影响。

- 示例1: 图A.7与图4的对比(假设)

假设在美国市场1分钟频率下:

- 图4 (原始数据) 的箱线图显示上四分位数 (Q3) 为 12%。

- 图A.7 (缩尾后数据) 的箱线图显示上四分位数 (Q3) 为 12.5%。

这个 0.5% 的微小提升,就对应了原文中“上四分位数条略高于缩尾处理前”的描述。这表明,在排名前25%的股票中,去除极端值后,其1分钟周期的信号变得更强了。

- 示例2: “其他”类别的含义

假设模型分析了500个频率,作者重点关注了5个频率:60分钟、30分钟、10分钟、5分钟、1分钟。

- 某股票计算出的总fVR(所有周期性成分解释的方差比例)为30%。

- 60分钟周期解释了5%。

- 30分钟周期解释了10%。

- 10分钟周期解释了3%。

- 5分钟周期解释了4%。

- 1分钟周期解释了6%。

- 那么,归入“其他”类别的fVR就是 30% - (5% + 10% + 3% + 4% + 6%) = 30% - 28% = 2%。

在图A.7中,就会有一个对应“其他”的箱线图,其分布反映了所有股票的这个 2%(以及类似计算出的值)的大小。通常“其他”类别的fVR会很低,说明大部分周期性由少数几个关键频率主导。

- 与原文图4的混淆: 必须清楚图A.7是一个新的、用于稳健性检验的图,它的输入数据经过了处理。解读它时,心中应时刻与基于原始数据的图4进行对比,关注其“变”与“不变”。“不变”的是整体模式和结论,“变”的是细微的数值差异。

- 过度解读“截断”一词: 如前所述,不要从字面上将“截断”理解为删除数据。应根据上下文理解为限制极端值的操作(即缩尾)。如果真的做了删除,作者通常会说明如何处理留下的时间序列“空洞”。

- 忽略“去趋势”: fVR是根据“去趋势”时间序列计算的。这意味着在分析周期性之前,已经把一天内交易量整体缓慢上升或下降的趋势去掉了。如果不去趋势,这个趋势本身会贡献巨大的方差,可能会扭曲对纯粹“周期性”的度量。

图A.7的文字说明详细定义了这个图的内容和目的。这是一个基于“缩尾”处理后的交易量数据生成的fVR箱线图,旨在检验论文核心发现的稳健性。说明中复述了fVR的定义、解释了频率的分组方式,并再次提供了0.2%的参考基准。这张图是论证论文结论不受极端值影响的关键证据。

- 图表自解释性: 为图A.7提供一个完整的“说明书”,让读者无需翻阅正文就能看懂这张图是什么、怎么画的、以及如何解读。

- 强调检验方法: 明确指出图中数据经过了“第95百分位数截断(缩尾)”处理,这是理解此图与正文中其他图表差异的关键。

- 重申核心概念: 通过再次定义fVR和提供基准值,强化读者对论文核心分析工具的理解,确保读者使用正确的标尺来评估图中的结果。

想象你在给一群人拍照,要评估他们身高排列的“规律性”(周期性)。

- 原始照片(图4): 人群里有一个踩着高跷的人(极端值)。他的身高非常突出,使得整个队伍的“身高总方差”变得很大。你可能仍然能看出队伍是按高矮规律排列的,但那个踩高跷的人很碍眼,让你对这个规律的评价有所保留。

- 照片处理(缩尾): 你用修图软件把那个踩高跷的人“P”矮了一点,让他和他旁边的人身高差不多。

- 处理后的照片(图A.7): 现在照片看起来和谐多了。去掉了那个极端干扰后,队伍按高矮排列的优美规律(周期性)更加明显。你可能会得出结论:这支队伍的“身高规律性”(fVR)其实比第一眼看上去的还要强。

- 图A.7的说明: 就是这张处理后照片下面的图注,告诉你“注意:这张照片经过处理,我们把那个踩高跷的人P矮了,基准身高是1.7米(0.2%基准线)”。

想象一条平整的公路(去趋势后的时间序列),上面每隔一段距离就有一个减速带(周期性信号)。你要评估这些减速带设置的“规律程度”(fVR)。

- 原始路况(对应图4): 路上大部分是规律的减速带,但突然在某处有一个巨大的坑(极端值)。这个大坑造成了剧烈的颠簸,增加了你行车过程中的“总颠簸程度”(总方差)。虽然你仍然能感觉到减速带的规律存在,但那个大坑的颠簸太强烈了,使得减速带的规律性颠簸显得不那么突出了。

- 修复路面(缩尾处理): 工人来把那个大坑填平了,使其与正常路面齐平(用95百分位的值替换)。

- 修复后的路况(对应图A.7): 你再次开车通过。现在没有大坑的干扰了,你感受到的颠簸几乎完全来自于那些规律的减速带。你现在会觉得,这条路减速带的“规律性”(fVR)非常非常强,甚至比你第一次有坑时感觉到的还要强。

- 图A.7的图注: 就是路边的一个告示牌,上面写着:“前方路段为减速带规律性测试路段。注意:本路段已将所有坑洼填平。无规律路段的颠簸指数为0.2%。”

📜 [原文5]

更普遍地,人们可以使用我们的框架来系统地研究 ETF 市场中的周期性,这留待未来的工作。

这句话是本节内容的一个简短收尾,同时起到了承上启下、展望未来的作用。

- “更普遍地” (More generally): 这个词表明作者试图将刚刚完成的特定分析(对交易量、波动率、价差等进行周期性研究)提升到一个更具普遍性的方法论层面。

- “人们可以使用我们的框架”: “我们的框架”指的是本文提出和使用的整套分析方法,其核心是:

- 构建日内高频时间序列:从原始交易数据中生成分钟级或秒级的变量序列。

- 非参数谱分析模型:使用傅里叶变换等技术来分解时间序列的方差到不同的频率上。

- fVR (频率方差比):用这个指标来量化特定频率或一组频率的重要性,即周期性的强度。

- 稳健性检验: 包括处理极端值、比较不同市场等一系列确保结论可靠的步骤。

- “系统地研究 ETF 市场中的周期性”:

- ETF (Exchange-Traded Fund): 交易所交易基金。这是一种特殊的金融产品,它像股票一样在交易所上市交易,但其本身通常追踪一个指数(如标普500指数)、一篮子商品(如黄金ETF)或一篮子股票。

- 为什么特别提到ETF?: ETF的交易行为和普通股票有很大不同。它的价格受到其追踪的标的资产组合价格的影响,同时也受到自身在二级市场上的买卖供需影响。ETF市场中有大量的套利者(Authorized Participants, APs),他们会在ETF的价格与其资产净值(NAV)偏离时进行申购或赎回操作,以获取无风险利润。这些独特的机制可能导致ETF的交易量、价差和波动率展现出与个股不同的周期性模式。

- 例如,指数ETF的交易量可能在成分股权重调整日、指数发布重要经济数据时出现特定周期;套利活动本身也可能具有日内周期性。因此,ETF市场是一个非常有趣且值得深入研究的应用领域。

- “这留待未来的工作” (which is left for future work):

- 这是学术论文中非常标准和常见的表述。

- 作用1:界定本文范围。作者明确表示,研究ETF市场超出了本篇论文的讨论范围。这有助于管理读者预期,避免审稿人提出“为什么你们没有分析ETF?”这类问题。

- 作用2:指明未来研究方向。它为作者自己或其他后续研究者提供了一个明确的研究课题。这显示了作者对其研究领域未来发展的思考,也体现了本研究框架的潜在价值和可扩展性。

- 示例1: ETF套利可能产生的周期性

假设一个追踪沪深300指数的ETF。在A股市场,下午14:57是集合竞价决定收盘价的关键时刻。套利者可能会在这个时间点前后进行大量的ETF买卖和对应的一篮子股票的买卖,以锁定收盘价的套利机会。如果这种行为普遍存在,那么使用本文的框架去分析该ETF的交易量,就可能会在接近收-盘的3分钟或5分钟频率上,发现一个非常强的周期性尖峰,其fVR值会显著高于一天中其他时间。

- 示例2: 指数权重调整带来的周期性

著名的MSCI指数通常在每年的2月、5月、8月、11月的月底进行季度性调整。在调整生效日的当天,尤其是收盘前,所有追踪该指数的被动型基金(包括大量ETF)都必须执行交易,以匹配新的指数成分和权重。这会导致相关股票和ETF在这些特定日子的尾盘出现巨大的交易量。虽然这不是一个“日内”周期,但如果把研究的时间尺度扩展,本文的框架也可以用来识别这种“季度性”或“事件性”的周期行为。作者提到研究ETF,暗示了他们的框架可以被灵活运用于不同场景。

- 不要误解为作者已经做了ETF研究: 这句话明确说明了ETF的研究是“未来”的工作,本文中没有包含任何关于ETF的实证结果。

- 框架的适用性: 虽然作者声称框架是“普遍的”,但在应用到新市场(如ETF)时,可能需要一些调整。例如,ETF的套利机制和价格发现过程比个股更复杂,可能需要引入额外的变量(如ETF的折溢价率 IOPT)来辅助分析。

- “系统地研究”的含义: 这个词强调的是全面、深入的分析,而不仅仅是简单计算一下fVR。一个系统的研究可能包括:比较不同类型的ETF(股票型、债券型、商品型)、分析套利活动与周期性的关系、研究ETF周期性对市场整体流动性的影响等。

本句是一个结论性和前瞻性的陈述。它总结道,本文所建立的用于分析周期性的分析框架具有普适性,并特别指出,将此框架应用于研究ETF市场的日内交易模式是一个有价值且待探索的未来研究方向。

- 提升研究价值: 通过指出研究框架的可扩展性,作者提升了自己工作的普遍意义和方法论贡献。它不仅仅是关于个股交易量的一个发现,而是一套可以应用于更广泛金融现象的分析工具。

- 展示学术视野: 提出有前景的未来研究方向,表明作者对该领域的动态和前沿问题有深入的思考,这在学术写作中是一个加分项。

- 平滑过渡: 作为本节的最后一句,它自然地结束了关于“其他金融时间序列”的讨论,并为转向下一个完全不同的话题(附录G:其他交易量度量)做好了铺垫。

[直觉心-智模型]

想象你发明了一把非常精良的“瑞士军刀”(本文的分析框架)。

- 在前面的段落里,你已经用这把刀成功地切了苹果(分析交易量)、削了梨(分析波动率),甚至还开了罐头(处理极端值)。你证明了这把刀非常好用。

- 现在,在这句话里,你说:“看,我这把刀非常厉害。未来,我们甚至可以用它来修理精密的手表(研究ETF市场)。”

- “这留待未来的工作”就等于说:“不过今天我们时间有限,就不现场演示修手表了,但你们都知道这把刀有这个潜力。”

这番话既总结了工具的牛逼之处,又指明了其更高级的用途,提升了这把刀的价值。

想象你是一位天文学家,刚刚设计并建造了一台功能强大的新型望远镜(本文的分析框架)。

- 你已经用这台望远镜清晰地观测了月球的环形山(交易量周期性)、木星的条纹(波动率周期性),并校准了望远镜以消除大气抖动的影响(稳健性检验)。

- 在这句话中,你向听众总结道:“我们这台望远镜的性能非常卓越,它的分辨能力和光谱分析能力是前所未有的。”

- 然后你指向星空的一个方向说:“更令人兴奋的是,利用它的强大能力,我们未来将能够去系统地探索仙女座星系(研究ETF市场)中是否存在类似地球的行星(周期性)。这将是我们下一步的宏伟计划。”

这个展望让听众对你的望远镜(研究框架)的未来潜力充满期待。

22 G 其他交易量度量

📜 [原文6]

我们遵循与第 4 节相同的方法论,通过分别用成交股数和成交金额替代交易笔数来估计强度系数。

这是附录G部分的开篇,旨在说明本节的研究目的和方法。本节将进行另一项重要的稳健性检验,核心是考察当交易量的定义改变时,论文的主要结论是否依然成立。

- “我们遵循与第 4 节相同的方法论”:

- 这是一个“方法论声明”,告诉读者本节不会引入新的复杂模型,而是重复使用论文核心章节(第4节)已经详细介绍过的方法。这使得读者可以快速理解本节内容,而无需学习新知识。

- “第 4 节的方法论”应该就是指本文的核心分析流程:构建日内时间序列 -> 谱分析 -> 计算强度系数 (intensity coefficient) 和 fVR -> 分析周期性。

- 核心操作:“替代交易笔数”:

- 这揭示了本节与正文分析最关键的不同点。在论文的正文部分(main body),作者用来衡量“交易活动”的指标是交易笔数 (Number of Trades)。即在每分钟(或其他时间间隔)内发生了多少笔交易。

- 现在,他们要用另外两个同样常用、但含义不同的指标来替换它:

- 成交股数 (Share Volume / Number of Shares Traded): 在每分钟内,总共成交了多少“股”股票。

- 成交金额 (Dollar Volume / Turnover): 在每分钟内,总成交的价格乘以股数是多少“元”或“美元”。

- 为什么要进行这种替代?

- 交易笔数、成交股数和成交金额是衡量交易量的三个不同维度,它们反映了交易活动的不同侧面。

- 交易笔数: 更能反映“交易的活跃度”或“决策的频率”。一笔100股的交易和一笔100万股的交易,在交易笔数上都只记为“1”,但它们的市场影响和背后的信息含量可能完全不同。高频交易和算法交易倾向于将大订单拆分成许多小订单执行,这会显著增加交易笔数。因此,交易笔数的周期性可能主要反映了算法交易的执行策略。

- 成交股数: 反映了实际换手的股票数量。它比交易笔数更能体现交易的“规模”。

- 成交金额: 在成交股数的基础上乘以了价格,是衡量市场资金流动和重要性的最直接指标。对于高价股,较少的成交股数可能对应巨大的成交金额。

- 通过分别使用这三个指标进行分析,作者可以探究:论文之前发现的强烈周期性,究竟是所有“交易活动”的共性,还是仅仅是“交易决策频率”(即交易笔数)所特有的现象?如果周期性在成交股数和成交金额上显著减弱,那就说明这个周期性主要是由交易执行的“碎片化”(很多小笔交易)驱动的,而不是资金流动本身的节律。

- “来估计强度系数”:

- 强度系数 (Intensity Coefficient) 是从谱分析模型中得出的一个参数,用来衡量在某个特定频率上(比如30分钟周期),周期性信号的强度有多大。

- 本节的目标就是看,当输入的时间序列从“每分钟交易笔数”换成“每分钟成交股数”或“每分钟成交金额”后,计算出的强度系数会发生什么变化。

- 示例1: 三个指标的差异

假设在上午10:00-10:01这一分钟内,发生了两笔交易:

- 交易1: 卖出 200 股,成交价为 10元/股。

- 交易2: 卖出 50,000 股,成交价为 10.01元/股。

在这一分钟内:

- 交易笔数 = 2 笔

- 成交股数 = 200 + 50,000 = 50,200 股

- 成交金额 = (200 10) + (50,000 10.01) = 2000 + 500,500 = 502,500 元

可以看到,一笔大单(交易2)使得成交股数和成交金额变得巨大,但交易笔数仍然很小。如果正文的周期性是由大量类似“交易1”这样的小笔交易驱动的,那么当换成用成交股数或成交金额来衡量时,周期性就可能被类似“交易2”这样的大单的随机出现所掩盖。

- 示例2: 预期结果的猜想

- 场景A(周期性稳健): 如果成交股数和成交金额的分析结果与交易笔数类似,都显示出强大的30分钟、1分钟等周期,那么结论就是:日内周期性是市场交易活动的一个根本特征,无论用哪个指标衡量都一样。

- 场景B(周期性减弱): 如果成交股数和成交金额的周期性强度(强度系数和fVR)远低于交易笔数,那么结论就更微妙:我们观察到的强烈周期性,很大程度上是“交易执行策略”的产物(即算法把大单拆成许多有时间规律的小单来执行),而不是大规模资金本身在日内有那么强的周期性流入流出。后续的段落将会揭示,真实情况更接近场景B。

- 与上一节稳健性检验的区别: 上一节(附录F)的稳健性检验是改变“数据处理方式”(缩尾),但衡量指标仍然是交易量(原文未明确,但上下文暗示是交易笔数)。本节的稳健性检验则是改变“衡量指标本身”(从交易笔数换成成交股数/金额),这是两种不同思路的检验。

- 第4节内容的回顾: 要完全理解本节,读者需要对第4节介绍的方法论有清晰的记忆。如果忘记了“强度系数”是什么,可能需要返回去复习。

- 数据颗粒度: 无论是交易笔数、成交股数还是成交金额,它们都是在相同的时间窗口内(如每分钟)进行加总的,以保证时间序列的对齐和可比性。

本段是附录G的引言,清晰地陈述了本节的研究任务:将论文正文(第4节)所使用的分析框架,应用到另外两种衡量交易量的指标——成交股数和成交金额上。此举的目的是检验论文关于交易笔数周期性的核心结论,在改变交易量的度量维度后是否依然成立。

- 进行关键的稳健性检验: 这是本段最核心的目的。一个强有力的实证研究结论,应该不依赖于对关键变量的某一种特定度量方式。通过展示在不同度量下结果的异同,可以更深刻地揭示现象的本质。

- 设定研究范围和方法: 明确告知读者本节要做什么(用成交股数和成交金额替代交易笔数)以及怎么做(复用第4节的方法),为后续的结果展示和分析做好铺垫。

- 引出更深层次的讨论: 这个问题(不同交易量度量的周期性差异)本身就具有重要的经济学含义,关系到我们如何理解日内周期性的驱动来源(是算法执行策略还是资金流动本身)。本节的分析将为这个讨论提供实证证据。

想象你在分析一个超市的繁忙程度。

- 正文(第4节)的分析: 你用“进店的顾客人数”(交易笔数)作为衡量指标。你发现,每天中午12点和下午6点是顾客人数的高峰,呈现明显周期性。

- 本节(附录G)的分析: 你的同事提出了一个问题:“这种周期性是因为很多人都来买点小东西(比如一瓶水),还是因为真的有大采购?”

- 于是,你换了两个新指标:

- 卖出的商品总件数(成交股数)

- 总销售额(成交金额)

- 你现在要重新分析这两个新指标的时间序列,看看它们是否也在中午12点和下午6点出现高峰。

- 这个过程就是在检验你最初的“繁忙周期”结论,对于不同的“繁忙”定义是否都成立。

想象你在分析一条河流的水流情况。

- 正文的分析: 你在河边每分钟数一次有多少“浪花”拍打岸边(交易笔数)。你发现,每小时的第0分钟和第30分钟,浪花数量总是特别多,你得出了“水流有30分钟周期”的结论。

- 本节的分析: 一个水利工程师质疑你:“你看到的浪花多,可能只是因为风吹过水面造成的小波纹,并不代表真正的水流量大。你应该测量实际流过的水量。”

- 于是,你换了两种更专业的测量方法:

- 测量每分钟流过某个横截面的水量(立方米)(成交股数)

- 测量这些水所蕴含的动能(焦耳)(成交金额,因为能量与质量和速度平方成正比,类似价格*数量)

- 你现在要用这两种新方法收集的数据,重新分析是否存在30分钟的周期。这个检验将告诉你,你最初观察到的“浪花周期”,究竟是表面的风动,还是深层的水流本身的脉动。

📜 [原文7]

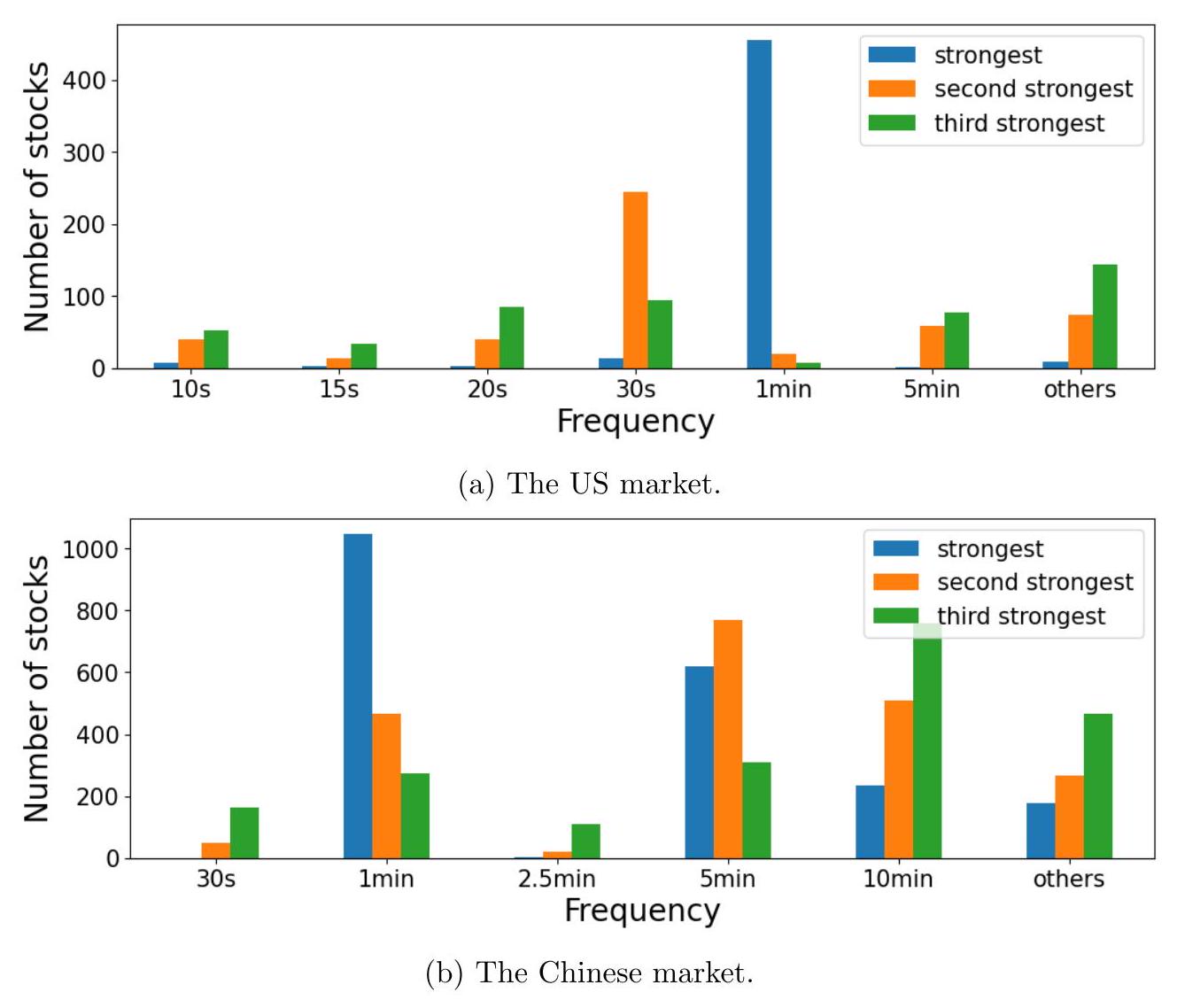

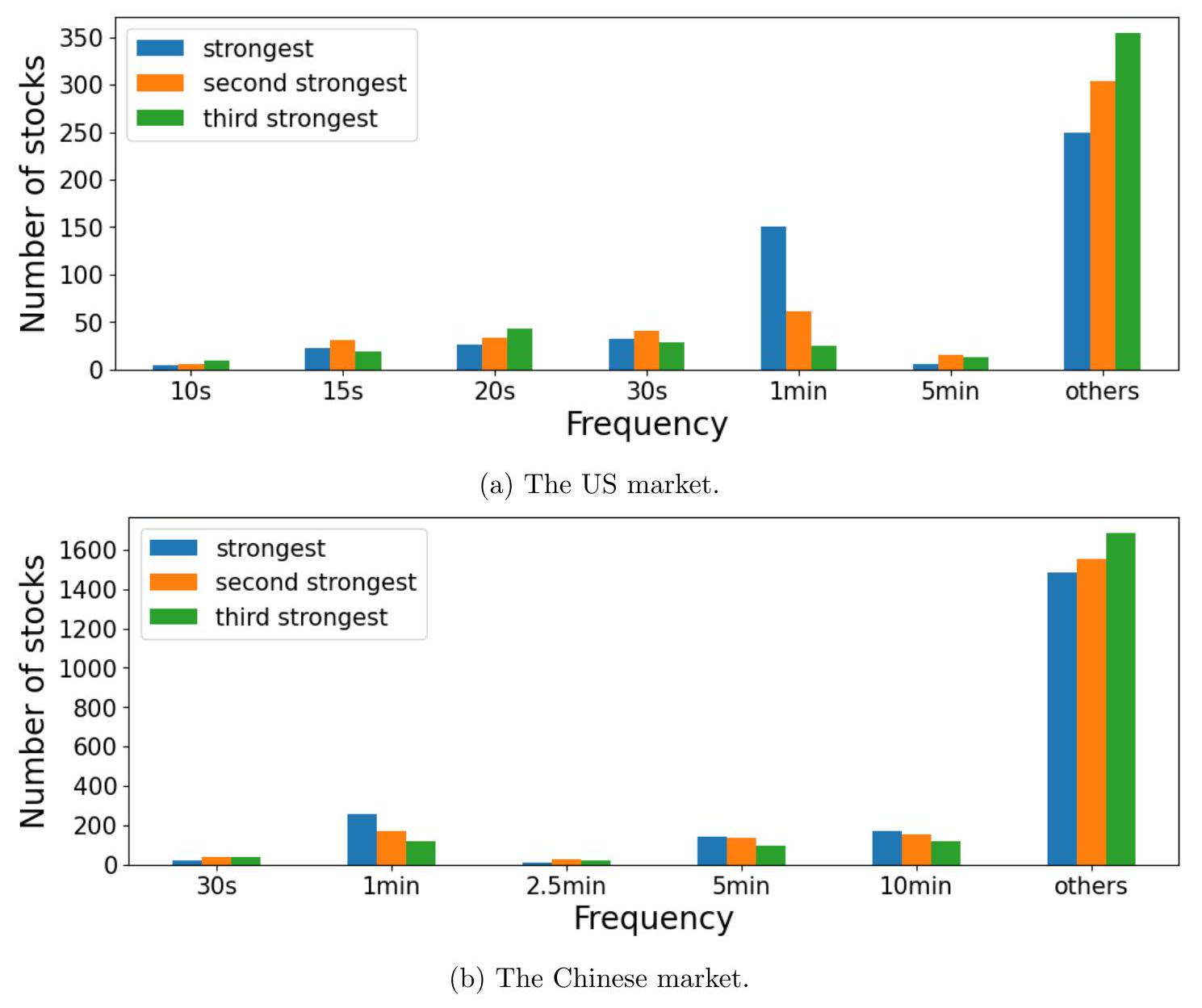

图 A.8 A.9 显示了所有股票中具有最强强度系数的前三个频率。与图 3 相比,我们可以观察到在选定频率上显示出周期性的股票数量显著减少。

这部分开始呈现使用新交易量度量(成交股数和成交金额)进行分析后的第一个核心结果,并通过与正文图3的对比来凸显差异。

- 图表引用与内容:

- “图 A.8 A.9”: 引用了两张图。根据上下文,图A.8是基于成交股数 (Share Volume) 的结果,而图A.9是基于成交金额 (Dollar Volume) 的结果。

- 图表内容: 这两张图所展示的统计量是“所有股票中具有最强强度系数的前三个频率”。

- 回顾:对于每一只股票,模型都会计算出它在几百个不同频率上的强度系数。

- “前三个频率”: 研究者会把这些强度系数从大到小排序,然后挑出最大的前三个所对应的频率。例如,对于A股票,最强的可能是30分钟周期,其次是5分钟,再次是60分钟。

- 统计与绘图: 然后,研究者对“所有股票”进行统计,看“30分钟周期”这个频率总共在多少只股票中进入了“前三强”的榜单。图A.8和A.9就是把每个频率(如30分钟、10分钟、5分钟、1分钟等)作为“前三强”出现的总次数(或总股票数)用柱状图等形式画出来。

- 与图3的对比: 作者明确指出,要将这两张新图与论文正文中的“图3”进行比较。图3是使用原始的交易笔数 (Number of Trades) 指标绘制的同样内容的图表。这种对比是本节分析的关键。

- 核心发现:

- “我们可以观察到在选定频率上显示出周期性的股票数量显著减少”: 这是通过对比得出的最重要结论。

- “选定频率”: 指的是那些在正文分析中被识别出的重要周期,如30分钟、60分钟、5分钟、1分钟等。

- “股票数量显著减少”: 这意味着,当使用成交股数或成交金额作为交易量度量时,虽然某些频率(比如30分钟)可能仍然是重要的,但在“前三强”榜单上出现的频率,远不如使用交易笔数时那么频繁和集中。

- 举例说明:

- 假设在图3(基于交易笔数)中,有80%的股票,其最强的三个周期中都包含“30分钟周期”。这会使得图3中代表“30分钟”的柱子非常高。

- 现在,在图A.8(基于成交股数)中,可能只有30%的股票,其最强的三个周期中包含“30分钟周期”。这将导致图A.8中代表“30分钟”的柱子显著变矮。

- 这就构成了“股票数量显著减少”的现象。

- 结论的引申义:

- 这个发现暗示,之前用交易笔数观察到的那种非常普遍、近乎“普适”的日内周期性(即大多数股票都有相似的周期模式),在换用成交股数或成交金额后,其“普适性”大大降低了。

- 这说明,很多股票的周期性主要体现在“交易的频率”上,而不是“交易的规模”上。换句话说,可能是算法交易在特定的时间点(如每隔30分钟)集中提交了大量小额订单,从而在交易笔数上制造了高峰;但从实际换手的股数或金额来看,这些高峰并不突出,或者被其他时间点发生的随机大额交易(比如机构投资者的非周期性交易)所掩盖。

- 示例1: 单只股票的强度系数排序变化

假设我们分析“股票X”在2021年某一天的数据:

- 基于“交易笔数”:

- 计算出的强度系数排序前三的频率是:1. (30分钟, 强度=0.8), 2. (5分钟, 强度=0.6), 3. (1分钟, 强度=0.5)。

- 基于“成交股数”:

- 可能在下午2点有一笔巨大的非周期性大宗交易,这笔交易只产生1笔成交,但股数极大。这个随机事件可能完全主导了成交股数序列的方差。

- 因此,重新计算出的强度系数可能显示,没有任何一个周期性频率的强度能高过这种随机噪声。排序前三的频率可能是三个互不相关的、由噪声引起的伪周期,例如 (17分钟, 强度=0.2), (83分钟, 强度=0.18), (42分钟, 强度=0.15)。

- 统计结果: 在这种情况下,“股票X”为“30分钟”、“5分钟”、“1分钟”这些关键频率贡献的“前三强”次数,在使用交易笔数时是“是”,在使用成交股数时则变成了“否”。当大量股票都发生类似情况时,就导致了“显示出周期性的股票数量显著减少”。

- 示例2: 图表柱高的变化(假设)

- 图3 (交易笔数):

- 频率“30分钟”的柱高:1500只股票(即在1500只股票中,30分钟周期是强度前三之一)。

- 频率“1分钟”的柱高:1200只股票。

- 图A.8 (成交股数):

- 频率“30分钟”的柱高:可能下降到 400只股票。

- 频率“1分钟”的柱高:可能下降到 300只股票。

- 图A.9 (成交金额):

- 频率“30分钟”的柱高:可能进一步下降到 350只股票。

- 频率“1分钟”的柱高:可能进一步下降到 250只股票。

这种柱高的“显著减少”,直观地证明了当考量交易的实际“规模”时,周期性的普遍性大大降低了。

- “显著减少”不等于“完全消失”: 即使数量减少,图A.8和A.9可能仍然显示出某些频率(如30分钟)比其他频率更重要,只是这种重要性的普遍程度不如以前。周期性可能并未消失,只是从一个“绝大多数股票都有”的现象,变成了一个“部分股票拥有”的现象。

- 区分“强度系数”和“fVR”: 本段讨论的是基于“强度系数”排名的结果。强度系数衡量单个频率的强度。下一段将讨论fVR,fVR衡量一组选定频率解释的总方差比例。两者相关但不同。一个频率的强度系数可能很高,但如果它持续时间很短,对总方差的贡献(fVR)不一定大。

- 跨市场比较: 需要注意这些图表是针对“所有股票”的,可能混合了美国和中国市场,或者分别为两个市场制作了图表。在解读时需要看清具体的图例和坐标轴说明。

本段呈现了使用成交股数(图A.8)和成交金额(图A.9)作为交易量度量后的第一个关键发现。与使用交易笔数(图3)的结果相比,在这些新度量下,那些经典的日内周期(如30分钟、1分钟等)能排进各股票周期性强度前三名的“股票数量”出现了“显著减少”。这初步表明,交易笔数所揭示的强烈周期性,在很大程度上是一种“交易频率”或“决策频率”上的现象,而当切换到衡量交易“规模”的指标时,这种周期性的普遍性就大打折扣了。

- 呈现核心对比结果: 直接、清晰地展示改变交易量度量方式带来的显著差异,这是本节稳健性检验的核心产出。

- 引导读者思考周期性的来源: 通过揭示交易笔数与成交股数/金额的周期性差异,促使读者思考这种差异背后的经济学含义。这为后文提出的“周期性主要由算法交易策略驱动”这一解释埋下伏笔。

- 为后续fVR分析提供铺垫: 这个关于“前三强频率”的发现,预示了接下来在fVR(方差贡献)的分析中,我们也很可能会看到类似的周期性减弱现象。

继续用超市的例子:

- 图3(顾客人数/交易笔数): 显示中午12点和下午6点是顾客人数高峰。几乎每个工作日都如此,非常规律。

- 图A.8(商品总件数/成交股数): 你发现,虽然中午12点来的人多,但很多人只买一瓶饮料或一个面包,所以商品总件数的高峰并不明显。反而在周六下午,虽然人不多,但有几个家庭来大采购,一次买几百件商品,导致周六下午的商品件数远高于平日中午。因此,从“商品件数”来看,原来的“日度高峰”规律减弱了。

- 图A.9(总销售额/成交金额): 情况类似。周六下午的家庭大采购可能花了好几千块,而平日中午的大量顾客可能每人只花几块钱。因此,从“销售额”来看,“日度高峰”的规律性也大大减弱。

- 结论: 超市的“繁忙周期”主要体现在“人流”上,而不是“销售规模”上。

继续用河流的例子:

- 图3(浪花数量/交易笔数): 显示每小时的第0分和第30分钟,浪花数量总是最多。这让你认为水流有30分钟的脉动。几乎所有河段都观察到此现象。

- 图A.8(实际水量/成交股数): 你用流量计测量后发现,那些浪花多的时刻,实际流过的总水量并不比其他时候大多少。反而,在某个下雨后的下午,虽然没风没浪花,但上游水库开闸放水,导致那一小时的总流量剧增。这使得你从“总流量”数据里很难再找到那个清晰的30分钟周期了。

- 图A.9(水流动能/成交金额): 结果类似。

- 结论: 你观察到的“浪花周期”是一个非常普遍的表面现象(可能由定时航运的船只经过造成),但它并不代表河流主流流量本身存在那么强的周期性。主流流量更多受到一些随机的、大规模事件(如水库放水、暴雨)的影响。

📜 [原文8]

图 A.8:当使用成交股数时,2019-2021 年间所有股票中,就估计的强度系数而言,每个频率作为前三强频率出现的次数。

图 A.9:当使用成交金额时,2019-2021 年间所有股票中,就估计的强度系数而言,每个频率作为前三强频率出现的次数。

这部分是图A.8和图A.9的图注,对这两张图的内容进行了精确的描述。

- 图A.8说明:

- 度量指标: “当使用成交股数时”。这明确了本图的数据基础是成交股数 (Share Volume) 的日内时间序列。

- 时间范围和样本: “2019-2021 年间所有股票”。与正文研究的时间和样本范围保持一致。

- 分析方法: “就估计的强度系数而言”。表明排序和比较的依据是模型估算出的强度系数。

- 统计内容: “每个频率作为前三强频率出现的次数”。Y轴代表一个计数。例如,如果Y轴在“30分钟”这个频率上对应的数值是400,意味着在所有被分析的股票中,有400只股票,它们的“30分钟”周期的强度系数能排进自身所有频率强度中的前三名。

- 图表形式: 几乎可以肯定是柱状图,X轴是不同的频率(30分钟,10分钟,5分钟,1分钟,30秒等),Y轴是出现的次数(股票数量)。

- 图A.9说明:

- 度量指标: “当使用成交金额时”。本图的数据基础是成交金额 (Dollar Volume)。

- 其他方面: 时间范围、样本、分析方法、统计内容和预期的图表形式都与图A.8完全相同,唯一的区别就是输入数据从成交股数换成了成交金额。

- 与图3的隐性对比:

- 虽然图注没有直接提及图3,但它们在结构和描述上与图3的图注(正文中)是平行的。读者被期望主动将这两张图与基于交易笔数的图3进行心智上的或视觉上的对比。

- 对比的焦点在于:在图A.8和A.9中,那些在图3里非常突出的频率(高柱子),其柱高是否“显著减少”了。同时,是否有新的、在图3中不重要的频率,在图A.8或A.9中意外地变得重要起来(尽管根据上一段的描述,这种情况似乎不明显)。

- 示例1: 如何从原始数据到图A.8的一个数据点

- 选定一只股票和一天: 比如,苹果公司(AAPL)在2020年3月5日的数据。

- 构建时间序列: 以1分钟为间隔,计算每分钟的成交股数。得到一个包含390个数据点(从9:30到16:00)的时间序列。

- 谱分析: 对这个序列进行谱分析,计算出几百个不同频率(比如从几秒到几小时)对应的强度系数。

- 排序: 假设发现强度系数最高的前三个频率是:(10分钟, 强度=0.75), (30分钟, 强度=0.6), (23分钟, 强度=0.5)。

- 为总体计数做贡献: 因为“10分钟”和“30分钟”这两个重要频率出现在了AAPL这一天的前三强名单里,所以在最终的统计图上,“10分钟”的柱子高度会+1,“30分钟”的柱子高度也会+1。(实际操作中可能是对每只股票在整个三年期间的平均排名进行统计,或者统计在多少天内进入前三)。

- 重复: 对所有股票、所有交易日重复以上步骤,最终累加得到每个频率的总出现次数,从而绘制出整个图A.8。

- 示例2: 图A.8和图A.9的可能差异

- 假设有一只高价股,比如伯克希尔哈撒韦A类(BRK.A),其股价几十万美元。

- 成交股数分析 (图A.8): 它的日内成交股数可能非常小,交易不活跃,因此可能分析不出任何显著的周期性。它对图A.8中任何一个频率的柱高都毫无贡献。

- 成交金额分析 (图A.9): 尽管成交股数小,但哪怕只成交几股,其成交金额也是巨大的。如果这些稀疏的交易恰好有某种时间规律(比如总是在上午的某个时段发生),那么在成交金额的序列上,可能会分析出周期性。这可能导致BRK.A这只股票为图A.9中某个频率的柱高贡献了+1,但在图A.8中没有。

- 反之,对于一只股价极低的“仙股”,其成交股数可能巨大,但在成交金额上则微不足道。

- 因此,图A.8和图A.9之间也可能存在细微差异,反映了价格水平对不同交易量度量的影响。

- 不要混淆图A.8和图A.9: 必须时刻清楚哪张图对应成交股数,哪张对应成交金额。它们的结论可能非常相似,但也可能存在细微差别。

- “次数”的精确定义: 图注中的“次数”可能指“股票的数量”,也可能指“股票-天”的数量。前者是每只股票在整个研究期间只投一票,后者是每只股票每一天都可以投一票。这会影响Y轴的绝对数值,但通常不影响不同频率之间的相对高低。从“所有股票中”的措辞来看,更可能指“股票的数量”。

- 图表的视觉尺度: 如果图A.8/A.9与图3的Y轴尺度不同,直接用肉眼比较柱子的高度可能会产生误导。应该关注相对比例和数量级的变化。

这两个图注精确地定义了图A.8和图A.9的内容。它们分别基于成交股数和成交金额,展示了各个日内频率在多大程度上成为股票周期性强度“前三强”的统计结果。这些图是与基于交易笔数的图3进行对比的关键证据,用于论证当交易量的度量从“频率”转向“规模”时,周期性的普遍性会显著下降。

- 提供精确的图表说明: 作为科学图表不可或缺的一部分,确保读者准确无误地理解图表中的每一个元素代表什么。

- 明确区分不同分析: 通过在图注中清晰地标明“当使用成交股数时”和“当使用成交金额时”,避免读者混淆,并强调本节分析与正文分析的核心区别。

- 作为文本论述的直接支撑: 上一段文字中“股票数量显著减少”的论断,需要这两张图作为直接的、可视化的证据来支撑。图注的作用就是将文本论断与视觉证据连接起来。

想象一个音乐排行榜。

- 图3 (交易笔数): 这是“电台点播次数”排行榜。某些歌曲(如“30分钟周期”)因为朗朗上口、时长合适,被大量电台反复播放,所以排名极高,几乎在所有城市的榜单上都是前三。

- 图A.8 (成交股数): 这是“专辑实体销量”排行榜。你会发现,虽然有些歌点播率高,但粉丝不一定愿意花钱买专辑。反而一些偶像派歌手,虽然歌不常被点播,但粉丝购买力强,专辑销量很高。因此,这个榜单和点播榜有很大差异,“30分钟周期”这首歌的排名可能就没那么高了。

- 图A.9 (成交金额): 这是“总销售额”排行榜。它和专辑销量榜类似,但会受到价格影响。豪华版、限量版专辑(高价股)会在这里更有优势。

- 图注: 就是每个排行榜下面的标题,明确告诉你“本榜单依据电台点播次数/专辑实体销量/总销售额排名”。

想象你在分析不同类型文章在社交媒体上的传播力。

- 图3 (交易笔数): 这是“文章被分享的次数”统计。你发现,“30分钟就能学会XXX”这类快餐式文章(对应“30分钟周期”)被分享的次数最多,在各个平台都是爆款。

- 图A.8 (成交股数): 这是“文章的总阅读字数”(假设每个阅读者都读完)。你发现,虽然快餐文章分享多,但大家可能点开看两眼就关了,总阅读字数并不高。反而一些深度长文,虽然分享次数不多,但每个点开的人都会仔细读完,累积的总阅读字数可能更高。因此,在这个统计下,“30分钟”文章的优势就不明显了。

- 图A.9 (成交金额): 这是“为这篇文章付费的总金额”(假设是付费阅读)。这更能体现文章的价值。深度长文的付费转化率可能远高于快餐文。

- 图注: 就是每个图表的标题,例如“图A.8: 各类型文章总阅读字数统计”。

📜 [原文9]

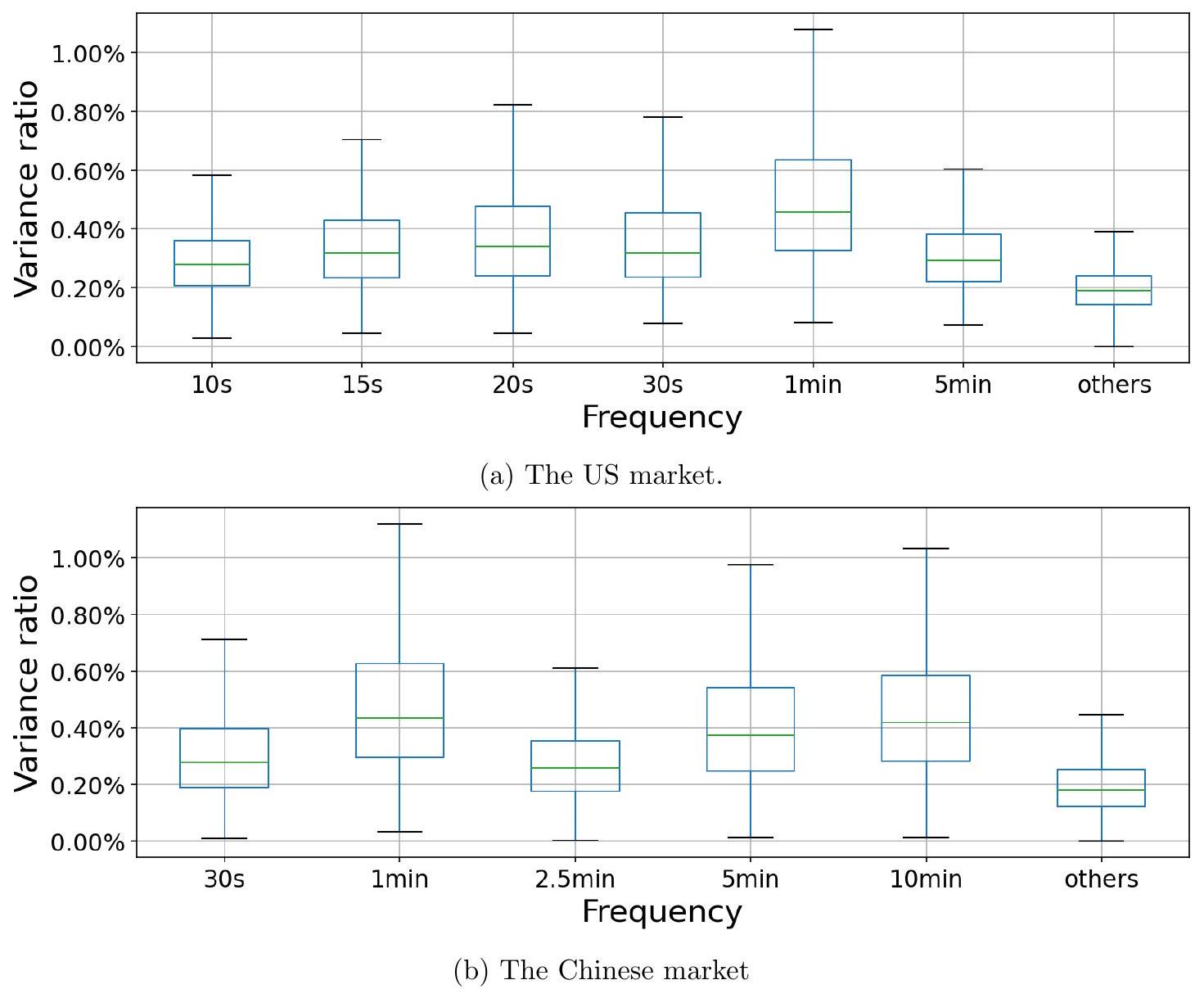

此外,图 A.10 A.11 分别显示了成交股数和成交金额的 fVRs。在美国市场,所有选定频率的 fVRs 仅为 1-2% 左右,显著低于图 4 中的数值。同样,在中国市场,1 分钟和 5 分钟频率的平均 fVRs 从 10% 下降到约 3%,而 30 秒、2.5 分钟和 10 分钟频率的 fVRs 仅为 1-2% 左右。

这些结果意味着成交股数和成交金额的周期性弱于交易笔数。

这部分呈现了使用新交易量度量后的第二个核心结果,这次是从频率方差比 (fVR) 的角度进行分析,并直接给出了数值上的对比,最后得出了一个明确的结论。

- 从“强度系数”到“fVR”的分析深化:

- 上一部分分析了“强度系数排名”,关注的是“哪个频率最强”。现在,这部分分析fVR,关注的是“一组重要的周期性频率总共解释了多少方差”。

- fVR是一个更综合的指标,衡量周期性在整体时间序列变异中的“重要性占比”。如果fVR很低,意味着即使存在某个最强的周期,这个周期性也只是时间序列中一个微不足道的组成部分,大部分波动是由非周期性的“噪声”主导的。

- 图表引用与内容:

- “图 A.10 A.11”: 引用了另外两张图。图A.10是关于成交股数 (Share Volume) 的fVRs,图A.11是关于成交金额 (Dollar Volume) 的fVRs。

- 图表内容: 这两张图应该是箱线图,与正文中的图4(基于交易笔数的fVRs)在结构上完全一致,以便于比较。X轴是不同的市场和频率,Y轴是fVR的值。

- 核心发现:fVR显著下降:

- 美国市场:

- 结果: “所有选定频率的 fVRs 仅为 1-2% 左右”。“选定频率”是指30分钟、5分钟、1分钟等关键周期。这个fVR值已经非常低了,虽然可能仍然高于0.2%的基准,但其经济显著性已经大大减弱。

- 对比: “显著低于图 4 中的数值”。这意味着在图4(基于交易笔数)中,美国市场的fVRs要高得多,可能在5-10%或更高的范围。

- 中国市场:

- 结果 (1分钟和5分钟频率): “平均 fVRs 从 10% 下降到约 3%”。这是一个非常具体的、大幅度的下降。原本在中国市场非常强的1分钟和5分钟周期(解释了10%的方差),在换用新度量后,其解释力下降了约70%(从10%到3%)。

- 结果 (其他频率): “30 秒、2.5 分钟和 10 分钟频率的 fVRs 仅为 1-2% 左右”。这些频率的周期性更弱。

- 最终结论:

- “这些结果意味着成交股数和成交金额的周期性弱于交易笔数”: 这是一个清晰、直接的总结。它综合了上一部分关于“前三强频率”的发现和这一部分关于“fVR”的发现。

- 内在逻辑: 不仅有更少的股票将这些频率视为“最强周期”,而且对于所有股票来说,这些周期性成分能够解释的总体方差比例也大大降低了。这两个方面的证据共同指向同一个结论:从交易笔数切换到成交股数或成交金额,日内交易的周期性信号显著衰减。

- 示例1: fVR下降的直观感受

想象你分析一只股票的日内交易。

- 使用“交易笔数”: 你发现,交易笔数序列的总方差是100个单位。其中,由30分钟、5分钟、1分钟这几个周期共同解释的方差是15个单位。所以 fVR = 15/100 = 15%。这是一个相当高的值。

- 使用“成交股数”: 现在,你换成成交股数序列。假设在某个非周期性的时间点,发生了一笔巨大的匿名交易,导致成交股数序列的总方差飙升到1000个单位。而周期性部分(可能由算法单稳定贡献)所产生的方差仍然是15个单位左右。那么,新的 fVR = 15 / 1000 = 1.5%。

- 对比: fVR从15%“显著下降”到了1.5%。这表明,虽然周期性的绝对贡献(分子)可能没变,但它在整个成交股数的波动中已经变得无足轻重了。

- 示例2: 中国市场数据的解读

- 假设在图4中,中国市场“1分钟”频率的箱线图中位数是10%。这意味着对于中等水平的股票,1分钟周期可以解释其交易笔数总方差的10%。

- 现在在图A.10/A.11中,“1分钟”频率的箱线图中位数下降到了3%。

- 这个变化说明,当我们关注实际成交的股数或金额时,1分钟的交易节律虽然还存在,但其重要性(解释方差的能力)已经大大削弱。这可能是因为大量的1分钟周期性交易都是非常小的“试探性”订单或做市商报价,而真正的大额成交则在一天中以更随机的时间发生。

- “弱于”不等于“没有”: fVR为1-3%虽然比10%低很多,但通常仍然显著高于0.2%的随机基准。所以结论是周期性“弱于”交易笔数,而不是完全“消失”。在成交股数和成交金额上,微弱但统计显著的周期性可能依然存在。

- 平均fVRs: 文中提到“平均fVRs”。这可能是指箱线图的中位数,也可能是所有股票fVR的算术平均值。两者含义略有不同,但都反映了集中的趋势。

- 为何成交股数和成交金额结果相似: 论文没有特意区分成交股数和成交金额的结果,而是将它们并列。这暗示着这两者的结果非常相似。这在大多数情况下是合理的,因为股价在一天内的变动通常不大,所以成交股数和成交金额的时间序列形态高度相关。只有在股价日内波动极大的情况下,两者才可能呈现显著差异。

本段通过对比fVR值,进一步强化了附录G的核心论点。分析显示,无论是美国还是中国市场,当交易量的度量从交易笔数转向成交股数或成交金额时,由关键日内周期所能解释的方差比例(fVR)都出现了显著的、数量级上的下降。这与之前关于强度系数的发现相辅相成,共同证明了成交股数和成交金额的周期性远弱于交易笔数。

- 提供量化证据: 与上一部分“股票数量减少”的定性描述相比,本段提供了“fVR从10%降至3%”这样具体、量化的证据。这使得结论更有说服力。

- 从不同角度验证结论: 通过分析fVR,从“方差贡献”这一核心角度验证了周期性的减弱。这与“强度排名”角度的发现形成了交叉验证,使结论更加坚实。

- 明确得出最终推论: 在呈现了所有证据之后,本段的最后一句话“这些结果意味着...”起到了总结陈词的作用,将所有发现汇集成一个清晰、不含糊的结论,即交易笔数的周期性最强。

继续用超市的例子:

- fVR可以理解为“周期性带来的繁忙度占总繁忙度的比例”。

- 交易笔数(顾客人数): 中午和傍晚的人流高峰非常规律,占到了超市一天总“人流波动”的很大一部分(比如fVR=15%)。

- 成交股数/金额(商品件数/销售额): 虽然有周期性人流,但由于存在周末家庭大采购、节假日囤货等随机性的大额消费,这些随机事件导致了巨大的“销售波动”。相比之下,日常的周期性人流带来的销售额波动,只占总销售波动的很小一部分(比如fVR=2%)。

- 结论: 超市的“繁忙周期性”,如果用人流来衡量,就很强;如果用销售额来衡量,就很弱。

继续用河流的例子:

- fVR是“周期性水流(如浪花)引起的能量占总水流能量的比例”。

- 交易笔数(浪花数量): 由定时船只经过产生的浪花,其能量占了河岸边总波浪能量的很大一部分(高fVR)。

- 成交股数/金额(实际水量/动能): 河流的总水流动能,主要由上游是否放水、是否下暴雨等随机大事件决定。定时船只经过带来的那点能量波动,与水库开闸放水相比简直微不足道。因此,周期性能量占总能量的比例非常小(低fVR)。

- 结论: 河流的周期性,如果只看表面的浪花,会觉得很强;但如果看内在的总水流能量,就会发现周期性其实很弱,主导因素是那些非周期性的大事件。

📜 [原文10]

图 A.10:当使用成交股数时的频率方差比 (fVR) 箱线图。如果没有周期性存在,基准 fVR 为 $\frac{1}{500}=0.2 \%$,因为我们在模型中包含了 $n=500$ 个周期性成分。

图 A.11:当使用成交金额时的频率方差比 (fVR) 箱线图。如果没有周期性存在,基准 fVR 为 $\frac{1}{500}=0.2 \%$,因为我们在模型中包含了 $n=500$ 个周期性成分。

这部分是图A.10和图A.11的图注,对这两张呈现fVR结果的图表进行了说明。

- 图A.10说明:

- 核心内容: 这是一个“频率方差比 (fVR)”的“箱线图”。

- 度量指标: “当使用成交股数时”。这明确指出图中的fVR是基于成交股数序列计算的。

- 基准线: 再次重申了“基准 fVR 为 $\frac{1}{500}=0.2 \%$”。这个不变的基准尺使得本图可以与图4、图A.7等其他fVR图进行直接、公平的比较。只要看到箱体的位置,就能立即判断周期性的强度。

- 预期景象: 根据上一段的文字描述,图A.10中的所有箱体,其位置都会比图4(基于交易笔数)中的对应箱体显著降低。例如,图4中某个频率的箱体中位数可能在10%的高度,而在图A.10中,它会下降到只有2-3%的高度。整个图看起来会比图4“扁平”得多。

- 图A.11说明:

- 核心内容: 同样是fVR的箱线图。

- 度量指标: “当使用成交金额时”。这是与图A.10的唯一区别。

- 基准线: 同样是 0.2%。

- 预期景象: 图A.11的整体面貌预计会和图A.10非常相似,所有箱体的位置也都会远低于图4。这直观地展示了基于成交金额的周期性同样很弱。

- 公式: $fVR_{benchmark} = \frac{1}{500} = 0.2\%$

- 这个公式在本附录中反复出现,是理解所有fVR图的关键。其含义和推导与在图A.6和图A.7的解释中完全一致。

- fVR: 频率方差比,衡量周期性强度。

- 500: $n$,模型中的频率数量。

- 0.2%: 纯随机噪声下的预期fVR值。

- 示例: 想象图A.10的绘制过程

- 取A股票某一日的成交股数序列。

- 去趋势,然后计算总方差,比如是 1,000,000 (股^2)。

- 进行谱分析,发现由“1分钟”频率解释的方差是 10,000 (股^2),由“5分钟”频率解释的方差是 15,000 (股^2)。

- 那么,A股票在这一天,针对1分钟频率的fVR是 10,000 / 1,000,000 = 1%。针对5分钟频率的fVR是 15,000 / 1,000,000 = 1.5%。

- 对所有股票、所有交易日重复此过程,得到大量关于“1分钟fVR”的数值(比如几万个1%左右的值)和大量关于“5分钟fVR”的数值。

- 图A.10中的一个箱子,就是对这些fVR数值(例如所有“1分钟fVR”)的分布进行的图形化总结。箱子的位置(1-2%)远低于图4中可能的位置(10%),但仍然高于0.2%的基准。

- 与图A.8/A.9的区别: 图A.8/A.9是关于强度系数排名的“计数”图,Y轴是股票数量。而图A.10/A.11是关于fVR的“分布”图,Y轴是fVR这个百分比值。两者从不同维度揭示同一现象。

- 绝对值vs相对值: 在解读时,既要看fVR的绝对值(比如1-2%,说明周期性本身就不占主导),也要看它与图4的相对变化(从10%降到2%,说明度量方式的改变影响巨大)。

这两个图注清晰地说明了图A.10和图A.11是分别基于成交股数和成交金额计算的fVR箱线图。它们通过重申0.2%的基准线,为读者提供了与论文其他fVR图进行比较的统一标准。这两张图是上一段文字论述的视觉化证据,旨在直观展示当交易量度量从交易笔数切换到交易“规模”时,周期性的强度(fVR)会发生大幅下降。

- 图表自解释性: 确保图A.10和A.11能够独立存在,读者仅凭图和图注就能理解其核心内容。

- 明确分析基础: 强调输入数据是成交股数或成交金额,这是与正文图4进行比较的关键前提。

- 提供恒定的参照系: 反复强调0.2%的基准,确保读者在比较不同图表时,始终有一个稳定的“锚”,不会因为视觉上的错觉而误判。

想象你在评估不同类型电视节目的“规律性”。

- 图4 (交易笔数): 你分析“观众换台次数”,发现每到整点和半点,换台次数都有高峰(广告时间),规律性极强(高fVR)。

- 图A.10/A.11 (成交股数/金额): 你换成分析“有效观看时长”或“愿意为节目支付的费用”。你发现,虽然大家在广告时间频繁换台,但真正贡献收视时长或付费意愿的,是那些在非广告时段随机播出的热门大片或体育赛事。这些热门节目的播出时间不固定,其贡献的巨大“收视权重”稀释了广告时间换台高峰的相对重要性。因此,从“有效观看时长”来看,节目的“周期性”就弱了很多(低fVR)。

- 图注: 就是告诉你,图A.10是基于“有效观看时长”的分析结果,基准线是随机乱看电视的“规律性”得分。

想象你在分析一个城市的用电量。

- 图4 (交易笔数): 你分析“居民打开电器开关的次数”。你发现,早上7点和晚上7点,大家起床和回家,开灯、开电视的动作非常集中,开关次数呈现强烈周期性(高fVR)。

- 图A.10/A.11 (成交股数/金额): 你换成分析“总耗电量(度)”。你发现,虽然居民用电有周期,但城市总耗电量的大头是几家大型工厂。这些工厂可能是24小时连续生产,也可能因为订单而在任意时间点开动高耗能设备。这些工厂的随机、高额用电,使得居民用电的周期性模式在总耗电量曲线中变得不那么明显(低fVR)。

- 图注: 就是告诉你,图A.10分析的是“总耗电量”,而不仅仅是“开关次数”。

📜 [原文11]

这些结果意味着成交股数和成交金额的周期性弱于交易笔数。

这句话是前面所有关于成交股数和成交金额分析的最终结论。它是一个高度浓缩的判断,综合了图A.8, A.9, A.10, A.11所揭示的所有证据。

- “这些结果”: 指代的是前面两段所描述的所有发现,包括:

- 基于强度系数排名的发现: 使用成交股数/金额时,能在周期性强度上排进前三的股票数量显著减少(图A.8, A.9 vs 图3)。

- 基于fVR的发现: 使用成交股数/金额时,由周期性成分解释的方差比例(fVR)显著降低(图A.10, A.11 vs 图4)。

- “意味着”: 这是一个逻辑推导的连接词,表明后面的论断是由前面的证据支持的。

- “成交股数和成交金额的周期性”: 明确了结论的主体。

- “弱于”: 这是一个比较级的判断,非常关键。它没有说成交股数/金额“没有”周期性,而是说它们的周期性“更弱”。这承认了周期性可能依然(微弱地)存在,但其强度无法与交易笔数相提并论。这是一个严谨、准确的表述。

- “交易笔数的周期性”: 明确了比较的参照物,即论文正文所研究的核心现象。

这句话的深层含义:

这个结论对理解日内周期性的来源至关重要。它强有力地暗示,我们在金融市场观察到的那种近乎普适的、强烈的日内周期性,主要是一种“行为频率”上的现象,而不是“资本流动规模”上的现象。

- 高频的交易笔数周期性:很可能源于程序化交易和算法交易的普遍应用。例如:

- TWAP/VWAP算法: 时间加权平均价格/成交量加权平均价格算法,为了在一天内均匀地执行一个大订单,会程序化地在每个时间片(如每分钟)提交一笔小订单。这自然会在交易笔数上创造出均匀的、高频的周期性。

- 做市商算法: 做市商为了持续提供流动性,会不断地提交和撤销报价订单,这些活动本身就具有高度的频率和一定的节律。

- 日内“时钟”效应: 交易员和算法可能都参照某些“整数”时间点(如每小时、每半小时)来评估市场、调整策略或执行交易,形成了人为的“共振”。

- 较弱的成交股数/金额周期性: 表明真正的大额资金流动(大宗交易、机构调仓等)在一天内的发生时间,具有更强的随机性和事件驱动性。一笔由基本面新闻触发的巨额交易,可能发生在任何时间点,它的出现会“淹没”那些由算法产生的、小规模但有规律的交易在成交股数和成交金额上的信号。

- 示例1: 总结对比

- 交易笔数: 周期性强。fVR中位数可能在10-15%。超过80%的股票都显示出共通的周期模式(如30分钟)。

- 成交股数/金额: 周期性弱。fVR中位数下降到1-3%。只有不到30%的股票显示出那些共通的周期模式。

- 结论: 成交股数和成交金额的周期性弱于交易笔数。

- 示例2: 一个综合场景

想象一只股票的一天:

- 算法A (VWAP): 每分钟都买入100股。这会在“交易笔数”上贡献一个完美的1分钟周期,也会在“成交股数”上贡献一个平稳的基线。

- 算法B (套利): 每当30分钟的整数倍时间点(10:00, 10:30, ...),就执行一系列买卖操作,总共产生50笔交易,但净成交股数为0。这会在“交易笔数”上贡献一个强烈的30分钟周期,但在“成交股数”上毫无贡献。

- 机构C (调仓): 在下午1:47分,突然一次性卖出了500万股。这在“交易笔数”上只贡献了“1”,微不足道;但在“成交股数”和“成交金额”上,它是一个巨大的、决定性的尖峰。

- 结果:

- 分析交易笔数序列时,算法A和B的行为叠加,会产生非常强烈的1分钟和30分钟周期。机构C的单笔交易被视为可忽略的噪声。

- 分析成交股数序列时,机构C的巨大卖单成为了主导,它的随机出现使得算法A和B贡献的微弱、规律的成交股数模式被完全掩盖。因此,分析结果显示周期性很弱。

- 结论的适用范围: 这个结论是基于作者使用的数据集(2019-2021年的美国和中国市场)得出的。在其他市场、其他时间段,或者对于特定类型的股票(如流动性极差的股票),情况可能会有不同。

- 不要绝对化: “弱于”不代表“无用”。在某些特定分析中,成交金额的周期性(即使很弱)可能比交易笔数的周期性更有经济学意义,因为它直接关系到资金的流动。

- 这是相关性,不是因果性: 分析显示了交易笔数的周期性更强,并暗示了这与算法交易有关。但这仍然是一个相关性结论。要建立确切的因果关系,需要更精细的数据(如交易员ID或算法标签)来直接证明是算法行为导致了交易笔数的周期性。

这句话是附录G的点睛之笔。它基于前面详实的图表和数据分析,给出了一个简洁而深刻的结论:成交股数和成交金额这两个衡量交易“规模”的指标,其日内周期性强度,显著弱于衡量交易“频率”的交易笔数指标。

- 提炼核心发现: 将前面几段分散的、技术性的分析结果(关于强度系数排名和fVR数值)提炼成一句易于理解和记忆的最终结论。

- 回答本节最初提出的问题: 本节开始时的问题是“当交易量的定义改变时,周期性是否稳健?”。这句话直接回答了这个问题:不稳健,它会显著减弱。

- 为论文的整体叙事服务: 这个结论强有力地支持了论文可能提出的一个更深层次的论点,即我们观察到的金融市场日内周期性,在很大程度上是由现代交易技术(特别是算法交易的执行策略)所塑造的,而不仅仅是基本面信息或投资者情绪的自然节律。

想象你在分析社交媒体上的“热度”。

- 交易笔数: 相当于“帖子的数量”。你发现,大家在早上9点上班摸鱼和晚上9点睡前冲浪时,发的帖子最多,呈现强烈周期性。

- 成交股数/金额: 相当于“产生10万+阅读量的爆款文章数量”。你发现,爆款文章的出现是不可预测的,可能在任何时间点因为某个社会热点而诞生。虽然周期性的发帖时间存在,但从“产生爆款”这个角度看,规律性就差很多了。

- 结论: 社交媒体的“热度”,如果用“发帖频率”来衡量,周期性很强;但如果用“影响力规模”来衡量,周期性就很弱。

想象你在分析一个城市的“交通活动”。

- 交易笔数: 相当于“路上汽车的数量”。你发现早晚高峰期,路上的车最多,周期性极强。

- 成交股数: 相当于“运输货物的总吨位”。你发现,虽然高峰期小汽车多,但真正决定货物运输量的是那些在深夜或凌晨行驶的长途重型卡车。这些卡车的行驶时间更多是根据物流计划而非通勤高峰决定的。因此,从“货运吨位”来看,早晚高峰的周期性就不那么明显了。

- 成交金额: 相当于“运输货物的总价值”。结果类似,一辆运送芯片的卡车其价值远超一辆运送沙土的卡车。

- 结论: 城市的“交通活动”,从“车辆密度”看,周期性很强;但从“物资流转规模”看,周期性就弱得多。

📜 [原文12]

最后,与图 5 和图 6 类似,图 A. 12 和图 A. 13 中关于每笔交易平均成交金额的结果也显示,该度量的周期性证据非常薄弱。

这部分是附录G的最后一项分析,引入了一个新的、衍生的交易量度量——“每笔交易平均成交金额”,并对其周期性进行了考察。

- 引入新度量:每笔交易平均成交金额 (Average Trade Size in Dollar)

- 定义: 这个指标是通过 总成交金额 / 总交易笔数 计算得出的。例如,在某1分钟内,总成交金额为100万元,发生了50笔交易,那么该分钟的“每笔交易平均成交金额”就是 100万 / 50 = 2万元/笔。

- 经济学含义: 这个指标反映了“平均每笔交易的规模”。它的大小可以用来间接推断市场参与者的类型。

- 高平均交易规模: 可能意味着机构投资者正在进行大额交易。

- 低平均交易规模: 可能意味着市场由零售投资者或执行拆单策略的算法交易所主导。

- 分析这个指标的周期性,是为了回答:市场中大单交易和小单交易的分布,在一天之内是否存在规律性的变化? 例如,是不是在开盘时段,平均交易规模会系统性地变大或变小?

- 分析方法与图表引用:

- “与图 5 和图 6 类似”: 这再次使用了“类比”的方式来设定读者的预期。图5和图6是论文正文中对“每笔交易平均成交金额”这个指标进行分析的图表(可能图5是强度系数排名,图6是fVR)。作者在这里表明,他们将重复完全相同的分析。

- 注意:此处原文可能有一个小的笔误或逻辑上的不一致。正文中图5和图6分析的是交易笔数,而这里作者想表达的意思应该是“我们现在要对‘平均成交金额’这个新指标,做一套类似于我们之前对‘交易笔数’所做的分析(图3和图4)”。但通过引用图5和图6,他可能是在指一个更具体的分析类型,我们需要假设图5、6在正文中确实是分析了交易规模。更可能的情况是,作者想说“我们现在展示的图A.12和A.13,在类型上分别对应正文中的图3和图4”。

- “图 A. 12 和图 A. 13”: 这是呈现新分析结果的两张图。

- 图A.12: 应该类似于图A.8/A.9,是关于“强度系数排名”的计数图。

- 图A.13: 应该类似于图A.10/A.11,是关于“fVR”的箱线图。

- 核心发现:

- “该度量的周期性证据非常薄弱”: 这是对这项分析的最终结论。

- “非常薄弱” (very weak evidence): 这个措辞比之前对成交股数/金额的“弱于” (weaker than) 更进了一步。它不仅仅是相对较弱,而是从绝对意义上讲,几乎找不到什么像样的周期性。

- 这意味着:

- 在图A.12中,可能没有任何一个频率的柱高能显著脱颖而出,整个图看起来可能非常“平坦”,接近随机状态。

- 在图A.13中,所有频率的fVR箱线图,其位置可能都非常接近0.2%的基准线,与我们之前讨论的“订单不平衡”的fVR图类似。

- 经济学解释: 这个发现意味着,平均每笔交易的规模在一天内并没有固定的、可预测的模式。并不存在“某个时段固定是大单出没,另一个时段固定是小单出没”的普适规律。大单和小单的出现,其相对比例在一天内似乎是随机变化的,或者说其变化规律非常微弱,以至于被市场噪声完全掩盖。

- 示例1: “平均成交金额”序列的构建

某股票在连续三分钟内的数据:

- 分钟1 (9:31): 成交额=100万, 交易笔数=50笔 -> 平均金额 = 20,000 元/笔

- 分钟2 (9:32): 成交额=80万, 交易笔数=100笔 -> 平均金额 = 8,000 元/笔

- 分钟3 (9:33): 成交额=500万, 交易笔数=10笔 -> 平均金额 = 500,000 元/笔

- 研究者就是对 [20000, 8000, 500000, ...] 这样一个时间序列进行谱分析。这个序列的波动可能非常剧烈且无规律。

- 示例2: “非常薄弱”的fVR是什么样

- 假设在图A.13中,美国市场所有频率(30分钟、10分钟、5分钟等)的fVR箱线图,其中位数都在0.2%到0.5%之间,且箱体的大部分都与0.2%的基准线重叠。

- 与之前成交股数/金额的1-3%的fVR相比,0.2%-0.5%这个水平基本上可以被视为“无经济显著性”的周期性,非常接近纯粹的随机噪声。

- 指标的波动性: “平均成交金额”这个指标本身可能具有极高的波动率。一笔大单的出现会使其瞬间飙升,而大量小单则会使其骤降。这种内在的高噪声特性,使得从中提取微弱的周期性信号变得极其困难。

- 与“成交金额”的区别: 不要将“平均成交金额”与“成交金额”混淆。前者是 金额/笔数,是一个比率;后者是总金额,是一个总量。它们的经济学含义和时间序列属性都完全不同。

- 对图5和图6的依赖: 如果读者无法访问正文的图5和图6,可能会对“与图5和图6类似”这句话感到困惑。但幸运的是,作者很快就给出了核心结论“周期性证据非常薄弱”,这使得即使不看图5和图6,也能理解本段的要点。

本段作为附录G的收尾,通过分析“每笔交易平均成交金额”这一新指标,对周期性问题进行了最后的探索。结果(体现在图A.12和A.13中)显示,这个衡量平均交易规模的指标,几乎没有任何显著的日内周期性。这进一步佐证了本节的核心观点:日内周期性主要体现在交易的“频率”(交易笔数)上,而不是交易的“规模”(无论是总规模还是平均规模)上。

- 完善稳健性检验: 通过分析一个衍生的、与规模相关的指标,使得本节对“规模 vs 频率”的检验更加全面和彻底。

- 排除另一种可能的周期性来源: 假设如果发现平均交易规模有强周期性(比如开盘时平均规模大,盘中小),那将揭示一种不同的日内动态。现在的“无周期性”发现,本身就是一个有价值的“零结果”(null result),它排除了这种可能性,让我们对市场的理解更清晰。

- 最终强化核心论点: “平均交易规模”也无周期性的发现,为“周期性主要源于交易笔数”这一论点提供了最后一块、也是非常坚实的一块证据,为附录G画上了一个圆满的句号。

继续用超市的例子:

- 新指标: “平均每个顾客的购物篮大小(金额)”。

- 分析: 你去分析,是不是中午12点来的顾客,他们的购物篮普遍都比较小(比如只买一份快餐),而下午5点来的顾客购物篮普遍都比较大(买晚餐的菜)?

- 发现: 你发现毫无规律。中午也可能有人顺便买了一大堆东西,下午也可能有人只进来买瓶水。平均下来,每个顾客的购物篮大小在一天内是随机波动的。

- 结论: “平均购物篮大小”没有周期性。这再次确认,超市的周期性只体现在“人流”上,而与顾客的“平均消费能力”或“单次购买规模”的规律性无关。

继续用河流的例子:

- 新指标: “平均每朵浪花的大小(或能量)”。

- 分析: 你去分析,是不是定时船只A(比如在10:00经过)激起的浪花,普遍比定时船只B(在10:30经过)激起的浪花要大?

- 发现: 你发现并非如此。浪花的大小不仅跟船有关,还跟当时的风速、河床深度等多种随机因素有关。平均来看,每朵浪花的大小并没有随时间呈现出规律性变化。

- 结论: “平均浪花大小”没有周期性。这最终证明,河流的周期性现象,仅仅是“浪花出现的频率”上的,而与浪花的“规模”或“强度”无关。

📜 [原文13]

图 A.12:当使用每笔交易平均成交金额时,2019-2021 年间所有股票中,就估计的强度系数而言,每个频率作为前三强频率出现的次数。

图 A.13:当使用每笔交易平均成交金额时的频率方差比 (fVR) 箱线图。如果没有周期性存在,基准 fVR 为 $\frac{1}{500}=0.2 \%$,因为我们在模型中包含了 $n=500$ 个周期性成分。

这部分是图A.12和图A.13的图注,对这两张分析“每笔交易平均成交金额”的图表进行了说明。

- 图A.12说明:

- 度量指标: “当使用每笔交易平均成交金额时”。这明确了本图的数据基础是 总成交金额 / 总交易笔数 所构成的日内时间序列。

- 分析方法和统计内容: 与图A.8和A.9完全相同,是基于“强度系数”排名的“前三强频率出现的次数”的统计。

- 预期景象: 根据上一段文字“周期性证据非常薄弱”的结论,这张图可能会非常“平”。也就是说,X轴上所有频率对应的柱子高度可能都差不多,而且都很低。没有哪个频率能像在图3中那样鹤立鸡群。这直观地表示,没有任何一个特定的日内周期在决定“平均交易规模”的变化中扮演了重要角色。

- 图A.13说明:

- 度量指标: 同样是“当使用每笔交易平均成交金额时”。

- 分析内容: 这是关于“频率方差比 (fVR)”的“箱线图”。

- 基准线: 依然是雷打不动的“基准 fVR 为 $\frac{1}{500}=0.2 \%$”。

- 预期景象: 这张图是“周期性证据非常薄弱”的最直观体现。预计图中所有的箱线图都会紧紧地“趴在” 0.2% 这条基准线上。箱体的中位数、甚至上四分位数可能都只比0.2%高出一点点,或者干脆就在其附近。这与图A.6中“订单不平衡”的fVR图类似,都是“零结果”的典型图形化表示。

- 公式: $fVR_{benchmark} = \frac{1}{500} = 0.2\%$

- 该公式的解释保持不变。它的反复出现,体现了作者分析框架的一致性和不同图表之间可比性的基础。无论被分析的时间序列是什么(交易笔数、成交股数、平均成交金额),判断其周期性是否显著的标尺都是统一的。

- 示例1: 图A.12的柱高可能是什么样

- 在图3(交易笔数)中,“30分钟”频率的柱高可能是1500。

- 在图A.8(成交股数)中,这个柱高下降到400。

- 在图A.12(平均成交金额)中,这个柱高可能只有50。同时,其他频率比如“17分钟”、“48分钟”等随机频率的柱高也可能在20-40之间。没有任何一个频率具有压倒性优势。

- 示例2: 图A.13的箱线图可能是什么样

- 对于美国市场“30分钟”这个频率:

- 图4(交易笔数)的fVR中位数可能是8%。

- 图A.10(成交股数)的fVR中位数可能是1.5%。

- 图A.13(平均成交金额)的fVR中位数可能只有0.3%。

- 这个0.3%的值与0.2%的基准线已经非常接近,从经济意义上几乎可以忽略不计,因此被判定为“证据非常薄弱”。

- 与之前图表的区分: 在附录G中,作者连续展示了A.8, A.9, A.10, A.11, A.12, A.13共6张图,非常容易混淆。解读时必须时刻关注图注中的“度量指标”:

- A.8, A.10 -> 成交股数

- A.9, A.11 -> 成交金额

- A.12, A.13 -> 每笔交易平均成交金额

- “薄弱”的主观性: “非常薄弱”是一个带有主观判断的词。在统计学上,即使是0.3%的fVR也可能在统计检验中“显著”大于0.2%。但作者从经济显著性(economic significance)的角度判断,这种微弱的周期性没有实际意义,因此称之为“非常薄弱”。

这两个图注精确地描述了图A.12和A.13的内容,它们是附录G中最后一组分析的结果呈现。图A.12通过强度系数排名,图A.13通过fVR分布,共同展示了“每笔交易平均成交金额”这一指标几乎没有可辨识的日内周期性。这些图是“周期性证据非常薄弱”这一结论的直接视觉证据。

- 为最终结论提供证据: 作为科学论证的一部分,任何结论都需要有图表或数据支持。这两个图就是上一段文字结论的直接支撑。

- 完成分析的闭环: 附录G的目标是检验不同交易量度量的周期性。在分析了总量指标(成交股数、成交金额)之后,再分析比率指标(平均成交金额),使得整个检验更加完整,覆盖了与“规模”相关的几个主要方面。

- 标准化呈现: 采用与之前分析完全一致的图表类型(强度系数计数图和fVR箱线图)和说明方式,保证了整个附录部分风格和逻辑的一致性,便于读者阅读和比较。

继续用社交媒体的例子:

- 新指标: “平均每篇帖子的点赞数”。

- 分析: 你想知道,是不是早上9点发的帖子,平均点赞数会系统性地高于晚上9点发的?

- 图A.12/A.13 (结果): 你发现毫无规律。任何时候都可能出现爆款高赞帖子,也任何时候都可能出现无人问津的帖子。平均下来,帖子的“平均受欢迎程度”在一天内是随机波动的。

- 图注: 就是告诉你,这张图分析的是“平均点赞数”,而不是“帖子总数”或“总点赞数”。

继续用城市交通的例子:

- 新指标: “平均每辆车里的乘客人数”。

- 分析: 你想知道,是不是早高峰的车,平均乘客数(比如1.5人/车)会系统性地高于平峰时段(比如1.2人/车)?

- 图A.12/A.13 (结果): 你统计后发现,并没有这样的规律。任何时段都混杂着单人驾驶的汽车、载着一家人的SUV和满载的公交车。平均下来,“每辆车的乘客数”在一天内并没有清晰的周期性模式。

- 图注: 就是告诉你,这张图分析的是“平均载客数”,一个比率指标。

33 H Ravenpack 新闻数据处理细节

📜 [原文14]

在 Ravenpack 数据集中,我们只能访问到 2012-2022 年美国市场和 2015-2022 年中国市场的 Ravenpack 新闻数据。Ravenpack 数据集中的每个样本都包含几列,包括一个毫秒级的时间戳和它所提及的公司。

这一段是附录H的引言,开始介绍一个全新的数据源——Ravenpack新闻数据,并描述其基本属性。附录H的整体目标是详细解释论文正文中可能使用到的“新闻数据”是如何被处理和构建的。这部分内容对于保证研究的可复现性至关重要。

- 数据源介绍:

- “Ravenpack 数据集”: Ravenpack是一家领先的金融分析公司,提供对全球新闻、财报、社交媒体等非结构化文本数据进行实时分析的服务。其产品被广泛用于量化投资策略中,以捕捉由新闻事件驱动的市场机会。

- 这是一个“另类数据”(Alternative Data)源,与交易所提供的标准交易数据(价格、交易量)不同。

- 数据的时间与市场覆盖范围:

- “我们只能访问到...”: 这个表述很诚实,说明了作者所使用数据的时间局限性。

- 美国市场: 2012-2022 年。

- 中国市场: 2015-2022 年。

- 与交易数据的匹配问题: 论文的主要交易数据是2019-2021年。这个新闻数据的时间范围完全覆盖了交易数据的研究区间,这是进行匹配分析的前提。作者提到更早的年份,可能是因为他们在其他部分的分析(比如构建某些控制变量)中用到了更长的时间序列。

- 数据样本的结构:

- “每个样本都包含几列”: 描述了Ravenpack数据的基本格式,它是一种结构化的表格数据。

- 关键列1: “一个毫秒级的时间戳”:

- 毫秒级 (millisecond-level): 精度非常高的时间记录,精确到千分之一秒。这对于研究高频交易和新闻的即时市场反应至关重要。

- 这意味着,我们可以精确地知道一篇新闻是在09:30:01.123发布的。

- 关键列2: “它所提及的公司”:

- 这是Ravenpack的核心功能之一,它能从新闻文本中识别出被提及的实体(公司、人物、地点等)。

- 这意味着,数据中的每一行不仅是一个时间点,还关联到一个或多个具体的公司。例如,一篇关于苹果发布新iPhone的新闻,就会被标记上与“苹果公司”相关。

- 示例1: 一条典型的Ravenpack数据样本(简化)

| timestamp | company_name | event_type | relevance |

|---|---|---|---|

| 2021-10-26T13:30:05.456Z | Apple Inc. | earnings-announcement | 100 |

| 2021-10-26T14:02:10.128Z | Microsoft Corp | product-release | 95 |

在这个例子中,第一行数据告诉我们,在UTC时间2021年10月26日13:30:05.456,有一条关于“苹果公司”的“财报发布”类型的新闻,其相关度评分为100(最高)。

- 示例2: 数据可以用来做什么

有了这样的数据,研究者就可以构建一个“新闻到达”的时间序列。例如,对于苹果公司(AAPL)这只股票,研究者可以统计在每个交易日内的每一分钟,有多少篇关于苹果公司的新闻被发布。

- 9:30-9:31: 0篇新闻

- 9:31-9:32: 2篇新闻

- 9:32-9:33: 1篇新闻

- ...

然后,就可以用本文的谱分析框架来研究这个“新闻频率”序列是否存在日内周期性。比如,公司发布新闻的时间是不是也有规律可循?(虽然这部分不是本附录的重点,但这是数据能做的事情)。

- 数据访问权限: 作者明确提到“我们只能访问到”,暗示了获取这类另类数据的成本和难度。不同的学术机构或金融公司订阅的Ravenpack产品包可能不同,导致数据覆盖范围和字段有所差异。

- 实体识别的准确性: Ravenpack的实体识别算法虽然先进,但并非100%准确。可能会有漏识别(新闻提到了公司但没识别出来)或错误识别(将一个不相关的词误认为公司名)。研究者通常需要接受一定程度的噪声。

- “提及”不等于“主体”: 一篇新闻可能提及了多家公司,Ravenpack会给出每家公司的相关度评分(Relevance Score)。研究者通常需要设定一个相关度阈值(比如只保留相关度大于80的记录),以确保新闻是真正关于这家公司的。

本段作为附录H的开场白,介绍了本节将要详细说明处理方法的“Ravenpack新闻数据”。它清晰地交代了该数据的来源、作者可访问的时间和市场范围,以及其核心的数据结构——包含毫秒级时间戳和所提及的公司信息。

- 引入新数据源: 为读者介绍一个在正文分析中扮演角色的重要“另类数据”。

- 提供背景信息: 交代数据的基本属性(时间范围、市场、数据格式),这是理解后续所有数据处理步骤的基础。

- 彰显研究的深度: 使用像Ravenpack这样的商业化、高质量另类数据集,通常意味着研究的成本和复杂度更高,也更能捕捉到市场的细微动态,这从侧面提升了研究的质量和可信度。

想象你要研究“谣言”对一个学校学生情绪的影响。

- Ravenpack数据: 相当于你雇佣了一个情报团队,他们7x24小时监听学校的所有公共渠道(BBS、微信群、校园广播),并记录下:

- 时间: 精确到秒,某条谣言出现的时间。

- 对象: 这条谣言是关于哪个学生或老师的。

- 本段内容: 就是在报告的开头写明:“我们的情报来源于‘校园情报网’(Ravenpack)。我们获得了从2015年到2022年的所有情报记录。每条记录都包含了时间和当事人姓名。”

想象你是一位需要分析实时军事情报的指挥官。

- Ravenpack数据: 就像你的情报中心收到的来自全球各地侦察卫星和无人机的实时数据流。

- 每条数据样本:

- 毫秒级时间戳: 就像照片或视频上精确到毫秒的拍摄时间。

- 提及的公司: 就像情报分析系统自动在图像中识别并标记出的“敌方坦克”、“导弹发射井”等目标。

- 本段内容: 相当于你在做战情简报时,第一页PPT上写着:“情报来源:‘天眼’全球侦察系统。数据覆盖时间:2012-2022年。数据格式:每条情报均包含精确时间戳和目标识别标签。”

📜 [原文15]

为了找到与每只股票相关的已发布新闻文章数量,我们分别使用美国 Wharton Research Data Services 和中国 Wind 数据库提供的股票-公司对应表,通过公司名称将新闻文章与股票进行匹配 $\sqrt{35}$ 然而,这三个数据集中公司名称的确切格式不尽相同,因此我们使用以下流程对其进行处理。

这段话描述了整个数据处理任务的核心目标和面临的主要挑战,并预告了接下来的解决方案。

- 核心目标:

- “为了找到与每只股票相关的已发布新闻文章数量”: 这是本节所有操作的最终目的。作者希望为数据集中的“每一只股票”(由股票代码,如AAPL,标识),构建一个时间序列,记录下在每个时间点(如每分钟)有多少篇相关新闻发布。

- 这个目标是将两个不同的数据集连接起来:新闻数据集 (Ravenpack),其中实体由“公司名称”标识;和交易数据集,其中实体由“股票代码”标识。

- 连接的桥梁:

- 连接这两个数据集的桥梁是“公司名称”。但事情没那么简单。我们需要一个权威的“股票代码 <-> 公司名称”的对应表。

- 作者为此引入了两个新的权威数据源:

- 美国: Wharton Research Data Services (WRDS): 这是一个顶级的、面向学术研究的金融和经济数据平台,由宾夕法尼亚大学沃顿商学院运营。它整合了CRSP, Compustat等众多权威数据库。作者可以从WRDS的CRSP数据库中获得最准确的“股票代码-公司历史名称”对应关系。

- 中国: Wind 数据库 (万得): 这是中国大陆领先的金融数据和分析工具服务商,在国内金融学术界和业界具有近乎垄断的地位。作者可以从Wind获得最权威的中国A股“股票代码-公司官方全称/简称”的对应关系。

- 核心挑战:

- “通过公司名称将新闻文章与股票进行匹配”: 这是理想化的操作流程。

- “然而,这三个数据集中公司名称的确切格式不尽相同”: 这就是现实中的巨大障碍。同一个公司,在三个不同数据库中的名字可能完全不一样。

- 举例:

- 目标公司: 国际商业机器公司 (International Business Machines Corporation)

- 交易数据库 (CRSP via WRDS): 可能记录为 INTERNATIONAL BUSINESS MACHINES CORP

- Ravenpack新闻数据库: 可能记录为 IBM,Intl. Business Machines,或者 International Business Machines

- 另一个数据库: 可能记录为 IBM Corp.

- 这种不一致性,导致无法通过简单的字符串精确匹配(Exact Match)来连接数据。如果直接进行精确匹配,可能会漏掉大量本应匹配上的新闻。

- 预告解决方案:

- “因此我们使用以下流程对其进行处理”: 作者在这里明确表示,他们设计了一套专门的流程来解决这个“名称不匹配”的问题。接下来的几点将会详细描述这个流程。这套流程的核心思想,将是一种“模糊匹配”(Fuzzy Matching)的策略。

- 脚注 $\sqrt{35}$:

- 这个脚注标记 $\sqrt{35}$ 很可能是一个印刷或格式转换错误,它在学术论文中通常应该是上标数字,如 $^{35}$。

- 这个脚注的内容很可能是对所使用的具体数据库或匹配方法提供更详细的说明或参考文献。例如,它可能会写:“我们使用CRSP的股票名称文件(stocknames)和Wind的公司概况文件(company profile)”。

- 示例1: 美国市场的名称不匹配

- 股票: Alphabet Inc. (谷歌的母公司)

- 股票代码: GOOGL (Class A)

- WRDS/CRSP数据库中的名称: ALPHABET INC

- Ravenpack中的可能名称:

- Alphabet

- Google (因为新闻更常提Google)

- Alphabet Inc

- Google LLC

- 挑战: 如何让程序知道,一篇提到了Google的新闻,应该被关联到股票代码为GOOGL、官方名称为ALPHABET INC的这只股票上?直接用ALPHABET INC去匹配Google肯定会失败。

- 示例2: 中国市场的名称不匹配

- 股票: 宁德时代新能源科技股份有限公司

- 股票代码: 300750.SZSE

- Wind数据库中的官方全称: 宁德时代新能源科技股份有限公司

- Wind数据库中的简称: 宁德时代

- Ravenpack中的可能名称:

- Contemporary Amperex Technology Co. Limited (官方英文名)

- CATL (常用英文缩写)

- 宁德时代

- 宁德时代 (可能是简体或繁体)

- 挑战: 如何将一篇英文新闻中提到的CATL,准确地匹配给中文官方名称为宁德时代新能源科技股份有限公司的300750.SZSE?这涉及到中英文、全称与简称、缩写与全称之间的匹配,比纯英文匹配更复杂。

- 公司名称变更: 公司在其历史上可能会多次更改名称(例如,Facebook改名为Meta)。一个好的“股票-公司名称”对应表(如CRSP)必须是包含历史名称和时间范围的,以便能将一篇提到公司旧名称的新闻,正确地匹配到公司当前的股票代码上。

- 子公司与母公司: Ravenpack可能会识别出一篇关于YouTube的新闻。YouTube是谷歌(Alphabet)的子公司。研究者需要决定,这篇新闻是否应该归属于母公司Alphabet (GOOGL)?这取决于研究的目的,通常需要一套清晰的规则来处理这种层级关系。

- 通用词汇的公司名: 有些公司名称是通用词汇,如“Apple”。一篇关于“吃苹果有益健康”的健康新闻,可能会被Ravenpack错误地标记为与“苹果公司”相关。这就需要依赖Ravenpack自身的消歧义能力和研究者后续的清洗步骤。

本段清晰地陈述了数据处理的核心任务(将新闻与股票匹配)和核心困难(三大数据源之间公司名称格式不统一)。为了解决这个困难,作者借助了WRDS和Wind这两个权威数据库作为桥梁,并预告了接下来将描述一套专门设计的名称处理与匹配流程。

- 阐明问题: 让读者充分认识到这项数据匹配工作的复杂性和挑战性,而不是一个简单的“VLOOKUP”操作。这能凸显作者工作的价值和严谨性。

- 介绍工具: 引入了为解决问题而使用的额外权威数据源(WRDS和Wind),展示了作者为了保证数据质量所做的努力。

- 承上启下: 作为引言,它自然地过渡到下一部分对具体处理步骤的详细描述,构建了清晰的逻辑链条。

想象你要给全校每个学生(用学号标识)派发他的个人快递。

- 学生名单: 你有一份包含“学号-姓名”的官方名单(来自教务处,相当于WRDS/Wind)。

- 快递包裹: 大量快递包裹(相当于Ravenpack新闻),但包裹上的收件人姓名五花八门:

- 有写大名的 (张三)

- 有写小名的 (小三)

- 有写英文名的 (John Zhang)

- 有写绰号的 (篮球飞人)

- 核心挑战: 你不能直接按官方名单上的“张三”去找包裹,因为会漏掉所有写着“小三”、“John Zhang”的包裹。这就是“公司名称格式不尽相同”。

- 本段内容: 相当于你在分发前声明:“我的任务是按学号发快递。我从教务处拿到了官方姓名表。但包裹上的名字太乱了,所以,我设计了下面一套流程来确保每个包裹都能准确找到它的主人。”

想象你是一位历史学家,在整理大量古籍(Ravenpack新闻)。

- 你的目标: 找出所有提到“秦始皇”(股票代码)的记载。

- 权威资料: 你有一本史记(WRDS/Wind),里面写着秦始皇的官方称谓是“始皇帝,姓嬴,名政”。

- 古籍中的记载: 在不同的古籍中,对他的称呼各不相同:

- 《史记》里叫 始皇帝

- 某本野史里叫 嬴政

- 某本民间故事里叫 阿政

- 某本错漏的竹简上写着 秦王正(字形相似或通假)

- 核心挑战: 如果你只在古籍里搜索“始皇帝”,你会错过所有其他称呼的记载。这就是“公司名称格式不尽相同”。

- 本段内容: 相当于你在论文前言里写:“本章旨在考证所有关于秦始皇的史料。我们以《史记》为基准,但考虑到古籍中称谓的多样性,我们采用了一套特别的文本匹配方法来处理这些差异。”

📜 [原文16]

- 筛选在美国(中国)市场交易日交易时段内发布的新闻文章,即 9:30-16:00(9:30-11:30 和 13:00-14:57)。

- 从公司名称中移除所有空格、特殊字符和数字。

- 将所有字母大写。

- 使用 RatcliffObershelp 算法(也称为格式塔模式匹配)计算每对公司名称之间的相似性度量。

- 如果新闻文章与股票的公司名称之间的相似性度量大于 0.8,则将它们进行匹配。

这部分详细列出了作者为解决“公司名称不匹配”问题而设计的五个具体步骤。这是一个典型的数据清洗和模糊匹配流程。

第一步:时间筛选

- 原文: “筛选在美国(中国)市场交易日交易时段内发布的新闻文章,即 9:30-16:00(9:30-11:30 和 13:00-14:57)。”

- 解释: 这是第一道过滤器,目的是只保留那些可能对当天交易产生最直接影响的新闻。

- 交易日: 剔除非周末、非节假日的日期。

- 交易时段: 只保留在市场开放时间段内发布的新闻。

- 美国市场: 9:30 - 16:00 (东部时间)。这是一个连续的交易时段。

- 中国A股市场: 9:30 - 11:30 (上午盘) 和 13:00 - 14:57 (下午盘)。注意下午收盘时间是14:57,因为最后三分钟是收盘集合竞价时间。这个细节非常专业,表明作者对中国市场的了解很深入。

- 目的: 盘前、盘后或非交易日的新闻,其影响会反映在开盘价中,而不是日内的交易动态里。由于本文的核心是研究“日内”周期性,因此只关注“日内”新闻是合乎逻辑的。

第二、三步:名称标准化 (Normalization)

- 原文: “2. 从公司名称中移除所有空格、特殊字符和数字。 3. 将所有字母大写。”

- 解释: 这两步的目的是将所有待比较的公司名称(无论是来自Ravenpack,还是来自WRDS/Wind)都转换成一种“标准格式”,以消除那些不影响核心语义的格式差异。

- 举例:

- 原始名称1: International Business Machines Corp.

- 原始名称2: IBM (i.b.m.)

- 经过步骤2 (移除空格、特殊字符、数字):

- 名称1 -> InternationalBusinessMachinesCorp

- 名称2 -> IBMIbm

- 经过步骤3 (转为大写):

- 名称1 -> INTERNATIONALBUSINESSMACHINESCORP

- 名称2 -> IBMIBM

- 目的: 经过这两步处理后,Apple Inc. 和 Apple, Inc 就会变成完全相同的 APPLEINC,可以直接精确匹配。这解决了很大一部分简单的格式问题。

第四步:计算相似度

- 原文: “使用 RatcliffObershelp 算法(也称为格式塔模式匹配)计算每对公司名称之间的相似性度量。”

- 解释: 对于那些经过标准化后仍然不完全相同的名称,就需要动用“模糊匹配”算法了。

- Ratcliff/Obershelp 算法: 这是一种经典的用于计算两个字符串相似度的算法。它的核心思想是寻找两个字符串中最长的公共子串,然后对剩余的部分进行递归处理。

- 相似性度量: 算法的输出是一个介于0和1之间的数值。0表示两个字符串毫无关系,1表示两个字符串完全相同。数值越高,相似度越高。

- 格式塔模式匹配 (Gestalt Pattern Matching): 这是该算法的别称。“格式塔”是心理学流派,强调“整体大于部分之和”。这个名字暗示了该算法试图从整体上把握两个字符串的相似性,而不仅仅是看个别字符的差异。

- 操作: 对每一个来自Ravenpack的新闻中的公司名(标准化后),去和WRDS/Wind数据库里的每一个股票的官方公司名(标准化后)进行成对比较,计算出一个相似度分数。

第五步:基于阈值进行匹配

- 原文: “如果新闻文章与股票的公司名称之间的相似性度量大于 0.8,则将它们进行匹配。”

- 解释: 这是最终的决策步骤。

- 0.8: 这是一个“阈值”(threshold)。它的选择是主观的,但0.8是一个在实践中比较常用且相对严格的阈值。

- 决策规则: 如果两个标准化后名称的Ratcliff/Obershelp相似度分数超过了0.8,系统就判定它们指向同一个公司,并将这篇新闻与对应的股票代码关联起来。

- 举例:

- normalize("Alphabet Inc") -> ALPHABETINC

- normalize("Google Inc") -> GOOGLEINC

- similarity("ALPHABETINC", "GOOGLEINC") 可能得到一个较低的分数,比如0.4,小于0.8,匹配失败。(这暴露了该流程的一个弱点,后续会讨论)

- normalize("Microsoft") -> MICROSOFT

- normalize("Microsoft Corp") -> MICROSOFTCORP

- similarity("MICROSOFT", "MICROSOFTCORP") 可能会得到一个很高的分数,比如0.95,大于0.8,匹配成功。

- 示例1: Ratcliff/Obershelp算法如何工作(简化)

- 字符串A: MICROSOFT

- 字符串B: MICROSOFTCORP

- 找到最长公共子串: MICROSOFT (长度9)。

- 相似度分数 = 2 匹配长度 / (总长度) = 2 9 / (9 + 13) = 18 / 22 = 0.818。

- 因为 0.818 > 0.8,所以匹配成功。

- 示例2: 阈值选择的影响

- 阈值设为0.95 (过高):

- similarity("MICROSOFT", "MICROSOFTCORP") = 0.818,小于0.95,会导致匹配失败。这被称为“假阴性”(False Negative),即本应匹配的没匹配上。

- 阈值设为0.6 (过低):

- 假设 similarity("AMERICA ONLINE", "AMERICAN AIRLINES") 计算出的分数是0.65。

- 因为 0.65 > 0.6,会导致系统错误地将关于“美国在线”的新闻匹配给“美国航空”。这被称为“假阳性”(False Positive),即不该匹配的匹配上了。

- 选择0.8: 是在“宁可错放,不可错杀”和“宁可错杀,不可错放”之间做的一个权衡。

- 简称和缩写问题: 这个流程对于处理 Microsoft vs Microsoft Corp 这类情况很有效,但对于处理 International Business Machines vs IBM,或者 宁德时代 vs CATL 这类“缩写”或“中英文”问题,效果非常差。因为 IBM 和 INTERNATIONALBUSINESSMACHINES 的字符串相似度几乎为零。这暗示作者可能还做了其他未言明的处理(比如一个手动的简称-全称对应表),或者接受了这部分信息的丢失。

- 计算成本: “计算每对公司名称之间的相似性度量”是一个计算量巨大的操作。如果有10000篇新闻,每篇新闻提到1个公司,而股票列表有5000只,那么就需要进行 10000 * 5000 = 5000万 次字符串相似度计算。这需要高效的编程和强大的计算资源。

- 一对多匹配: 如果一篇新闻里的公司名,与数据库里两只股票的公司名相似度都超过0.8怎么办?作者没有说明如何处理这种“冲突”。可能的做法是选择相似度最高的那个,或者如果相似度非常接近,就放弃这个匹配。

本节详细描述了一个五步法的数据处理流程,用于将包含非标准公司名称的Ravenpack新闻数据,准确地匹配到由股票代码标识的股票上。该流程包括:1. 按交易时间过滤新闻;2.和3. 对公司名称进行标准化处理;4. 使用Ratcliff/Obershelp模糊匹配算法计算名称相似度;5. 使用0.8的阈值做出最终匹配决策。这是一个严谨且在实践中常见的数据清洗与融合流程。

- 保证研究的可复现性: 这是附录存在的最主要原因。通过详细列出每一步操作和参数(如算法名称、阈值0.8),其他研究者可以精确地重复作者的数据处理过程,这是科学研究的基本要求。

- 展示工作的严谨性: 详细描述如何处理棘手的数据问题(如名称不匹配),能向读者和审稿人展示作者对待数据的认真态度和专业能力,增加了研究结论的可信度。

- 为结果提供背景: 正文中任何基于“新闻数量”的分析,其数据的来源和质量都取决于这个处理流程。理解了这个流程,才能更好地评估那些分析结果的可靠性。

继续用发快递的例子:

你的“发快递流程”被细化为:

- 时间筛选: 只处理今天工作时间(9点到下午5点)内到达的包裹。隔夜的包裹等明天再说。

- 名称标准化:

- 把包裹上所有收件人名字里的空格、点、括号都去掉。(Dr. Li, Xiao-Ming -> DrLiXiaoMing)

- 把所有字母都变成大写。(DrLiXiaoMing -> DRLIXIAOMING)

- 对教务处的官方学生名单也做同样处理。

- 计算相似度: 你拿出手机App(Ratcliff/Obershelp算法),对着包裹上的名字和学生名单里的名字,两两拍照比对,App会给出一个相似度分数。

- 匹配决策: 如果App显示相似度超过80%(阈值0.8),你就认为这个包裹是这位学生的,把包裹贴上他的学号。

想象你在玩一个“连连看”游戏。

- 左边区域: 是上千个写着不同公司名称的卡片(来自Ravenpack新闻)。

- 右边区域: 是几千个写着标准公司名称的卡片(来自WRDS/Wind),每张卡片上还有一个股票代码。

- 你的任务: 将左边的卡片和右边正确的卡片连接起来。

- 你的策略 (处理流程):

- 筛选: 你先把所有不是今天需要处理的卡片都收起来。

- 标准化: 你把所有卡片上的名字都用砂纸磨掉特殊符号,并用大写字母重新描一遍。现在 Microsoft. 和 Microsoft 都变成了 MICROSOFT。

- 模糊匹配: 对于那些长得还是很像但又不完全一样的卡片,你拿出一个“相似度测量尺”(Ratcliff/Obershelp算法)来量一下它们的相似程度。

- 决策: 如果两张卡片的相似度读数超过了尺子上的“80”刻度线,你就用一根红线把它们连起来。

📜 [原文17]

基于此流程,我们为每只股票构建了已发布新闻文章数量的日内时间序列。表 A. 2 提供了每只股票文章总数的汇总统计信息。

[^23]表 A.2:每只股票文章总数的汇总统计。我们提供了全市场平均值以及文章数量最多的部分选定股票的统计数据。

| 均值 | 标准差 | 最小值 | 中位数 | 75% 分位数 | 最大值 | |

|---|---|---|---|---|---|---|

| 市场所有股票的平均值 | ||||||

| 美国市场 | 6657.52 | 17784.16 | 0 | 2452 | 5004 | 171863 |

| 中国市场 | 68.79 | 370.35 | 0 | 3 | 18 | 9309 |

| 美国市场文章数量最多的五只股票 | ||||||

| 股票代码 | 文章数量 | 公司名称 | ||||

| JPM | 171863 | 摩根大通公司 | ||||

| FB | 161156 | Facebook 公司 | ||||

| MSFT | 132853 | 微软公司 | ||||

| CMCSK | 124570 | 康卡斯特公司 | ||||

| TWTR | 121661 | 推特公司 | ||||

| 中国市场文章数量最多的五只股票 | ||||||

| 股票代码 | 文章数量 | 公司名称 | ||||

| 002415.SZSE | 9309 | 杭州海康威视数字技术股份有限公司 | ||||

| 000333.SZSE | 5017 | 美的集团股份有限公司 | ||||

| 300750.SZSE | 4489 | 宁德时代新能源科技股份有限公司 | ||||

| 000002.SZSE | 4029 | 万科企业股份有限公司 | ||||

| 000725.SZSE | 2826 | 京东方科技集团股份有限公司 |

这部分内容总结了前述数据处理流程的结果,并用一个汇总统计表(表A.2)来展示最终生成的新闻数据的基本特征和分布情况。

第一部分:总结陈述

- “基于此流程,我们为每只股票构建了已发布新闻文章数量的日内时间序列。”:

- 这是一个承上启下的句子,说明之前复杂的匹配流程已经完成。

- 产出是为“每只股票”(如AAPL, MSFT)都生成了一个或多个“时间序列”。

- 这个时间序列的构成是:在每个时间单位(如每分钟),记录下匹配到该股票的新闻文章数量。例如:AAPL_news_series = [t_1: 0, t_2: 1, t_3: 0, ...]

- 这个时间序列是后续所有可能进行的“新闻周期性分析”的数据基础。

- “表 A. 2 提供了每只股票文章总数的汇总统计信息。”:

- 引出了表格A.2。

- 表格的内容是“每只股票文章总数”的统计。这意味着,表格里的数字不是描述日内动态的,而是对整个研究期间(2019-2021年)每只股票关联到的新闻总量的概括性描述。

第二部分:表A.2的详细解读

- 表格标题: “每只股票文章总数的汇总统计”。

- 表格结构: 表格分为三个主要部分:

- 全市场平均情况: 对比美国和中国两个市场。

- 美国市场个股明星: 列出了新闻量最大的五只美国股票。

- 中国市场个股明星: 列出了新闻量最大的五只中国股票。

- 列的含义:

- 均值 (Mean): 平均每只股票的新闻总量。

- 标准差 (Standard Deviation): 新闻总量在不同股票间的离散程度。标准差远大于均值,暗示数据是右偏的(少数股票有海量新闻,大多数股票新闻很少)。

- 最小值 (Minimum): 至少有一只股票在整个研究期间没有匹配到任何新闻。

- 中位数 (Median): 将所有股票按新闻量排序,位于中间位置的数值。它比均值更能代表“普通”股票的情况,因为它不受极端值影响。

- 75%分位数 (75th Percentile): 75%的股票新闻总量低于此数值。

- 最大值 (Maximum): 新闻量最多的那只股票的总新闻数。

- 数据解读与洞察:

- 中美市场巨大差异:

- 美国市场: 平均每只股票有6657篇新闻,中位数是2452篇。

- 中国市场: 平均每只股票只有69篇新闻,中位数更是低至3篇!

- 洞察: 这反映了两个市场在媒体覆盖度、信息披露环境以及Ravenpack数据源自身对中英文信息处理能力上的巨大差异。英文世界的金融新闻生态系统远比中文世界发达和密集,或者说Ravenpack对英文新闻的解析能力远强于中文。这个差异是进行任何中美对比研究时必须考虑的关键因素。

- 标准差 vs 均值: 在两个市场,标准差都远大于均值(美国: 17784 vs 6657; 中国: 370 vs 69),这证实了新闻分布的极端不均衡性(高度右偏)。

- 美国新闻最多的股票:

- 上榜的都是家喻户晓的巨头:摩根大通(JPM, 金融)、Facebook(FB, 科技)、微软(MSFT, 科技)、康卡斯特(CMCSK, 媒体电信)、推特(TWTR, 科技)。

- JPM以17万篇新闻高居榜首,这可能反映了金融机构在经济新闻中的核心地位。

- 这些公司的共同特点是:市值巨大、业务与宏观经济和日常生活紧密相关、本身就是媒体关注的焦点。

- 中国新闻最多的股票:

- 上榜的也都是各自行业的龙头企业:海康威视(安防)、美的集团(家电)、宁德时代(新能源电池)、万科(房地产)、京东方(面板)。

- 海康威视以近万篇新闻位居第一,这可能与其在一段时间内受到地缘政治和国际贸易争端的高度关注有关。

- 与美国相比,即使是中国新闻量最大的股票(9309篇),也仅仅比美国市场的平均水平(6657篇)略高,远低于美国头部股票的水平。

- 示例1: 中位数 vs 均值

- 在美国市场,均值(6657)远大于中位数(2452)。这说明什么?假设有三只股票,新闻数分别是 [100, 200, 30000]。

- 均值 = (100+200+30000)/3 = 10100。

- 中位数 = 200。

- 均值被那个极端值30000严重拉高了,而中位数200更能反映“典型”股票的情况。表A.2的数据告诉我们,美国市场充斥着少数像JPM, FB这样的“新闻富矿”,而大部分普通股票的新闻量其实更接近2000-5000的水平。中国市场同理。

- 示例2: 理解75%分位数

- 在中国市场,75%分位数是18。这意味着,如果你随机抽取一只中国A股,它在整个研究期间(大约3年)内的相关新闻总数有75%的概率是少于18篇的。这是一个非常低的水平,再次凸显了数据的稀疏性。

- 数据来源偏差: 必须认识到,这个统计结果不仅反映了真实世界的新闻分布,也反映了Ravenpack这个特定数据源的覆盖范围和算法偏好。例如,如果Ravenpack对金融行业的词汇库更丰富,就可能导致金融类公司(如JPM)的新闻被识别得更多。

- 相关性不等于重要性: 新闻数量多,不一定等于这些新闻对股价的影响就大。一篇关于公司CEO花边新闻的数量,可能远多于一篇关于公司核心技术突破的新闻,但后者的影响可能大得多。

- 表格中的空缺: 在“公司名称”列,JPM和海康威视等股票后面是空的,而FB等有中文名。这可能只是排版问题,或者作者认为某些公司的中文名是常识而无需填写。例如,JPM的中文名“摩根大通公司”被放在了下一列,这看起来是一个格式错位。

本节内容在总结了新闻数据处理流程的产出后,通过表A.2详细展示了最终获得的新闻数据集的汇总统计特征。表格揭示了两个关键信息:1) 新闻在美国和中国市场的分布极不均衡,美国的媒体覆盖密度远高于中国;2) 无论在哪个市场,新闻都高度集中在少数几家龙头公司上,呈现严重的右偏分布。这些信息为后续使用该数据进行研究提供了重要的背景认知。

- 展示数据处理结果: 向读者展示经过复杂流程后,最终得到的数据长什么样,其基本的数据画像是什么。

- 提供描述性统计: 描述性统计是任何实证研究论文的标配。它帮助读者了解数据的尺度、分布和潜在的偏差,是评估研究可靠性的基础。

- 支撑后续分析: 如果正文中有涉及到中美对比或者不同新闻量股票对比的分析,那么表A.2中揭示的巨大差异,就是那些分析的出发点和需要考虑的关键控制因素。

- 管理读者预期: 通过展示中国市场新闻数据的稀疏性(中位数仅为3),作者也含蓄地提醒读者,任何基于中国市场新闻数据的分析结果,其统计功效(statistical power)都可能有限,结论需要更谨慎地解读。

想象你为全校学生建立了一个“社交媒体提及度”档案。

- 流程产出: 你为每个学生都建立了一个档案,记录了过去三年里,校园BBS上有多少帖子提到了他/她。

- 表A.2: 就是你做的全校“社交媒体提及度”的总结报告。

- 中美对比: 相当于对比“本科生”和“研究生”的平均提及度。你发现本科生平均被提及100次,而研究生只有5次。你得出结论:BBS的主要用户是本科生,或者说大家更关心本科生的动态。

- 头部明星: 你列出了被提及次数最多的几个“风云人物”:学生会主席、校篮球队队长等。他们的被提及次数是普通学生的几百倍。

- 数据分布: 你发现,大部分学生都是“小透明”,几年下来被提及次数寥寥无几(中位数很低),而平均值则被少数风云人物严重拉高。

想象你是一位生物学家,在研究一片森林里不同种类的树木吸引鸟类筑巢的情况。

- 数据: 你对森林里每棵树,都统计了过去三年有多少鸟在上面筑过巢。

- 表A.2: 这是你的研究报告中的一个统计表。

- 中美对比: 相当于对比森林南坡(阳光充足)和北坡(阴暗潮湿)的树木。你发现南坡的树平均有50个鸟巢,而北坡只有2个。

- 头部明星: 你列出了最受欢迎的几棵“鸟巢公寓树”,它们都是些高大、枝繁叶茂的橡树或梧桐树,上面有成百上千个鸟巢。

- 数据分布: 你发现,森林里大部分的树(比如小灌木)一个鸟巢都没有(最小值为0),或者只有一两个(中位数低)。平均值则被那几棵“公寓树”拉得很高。这说明鸟类筑巢的选择是非常挑剔和集中的。

44 I 关于超额回报的附加结果

📜 [原文18]

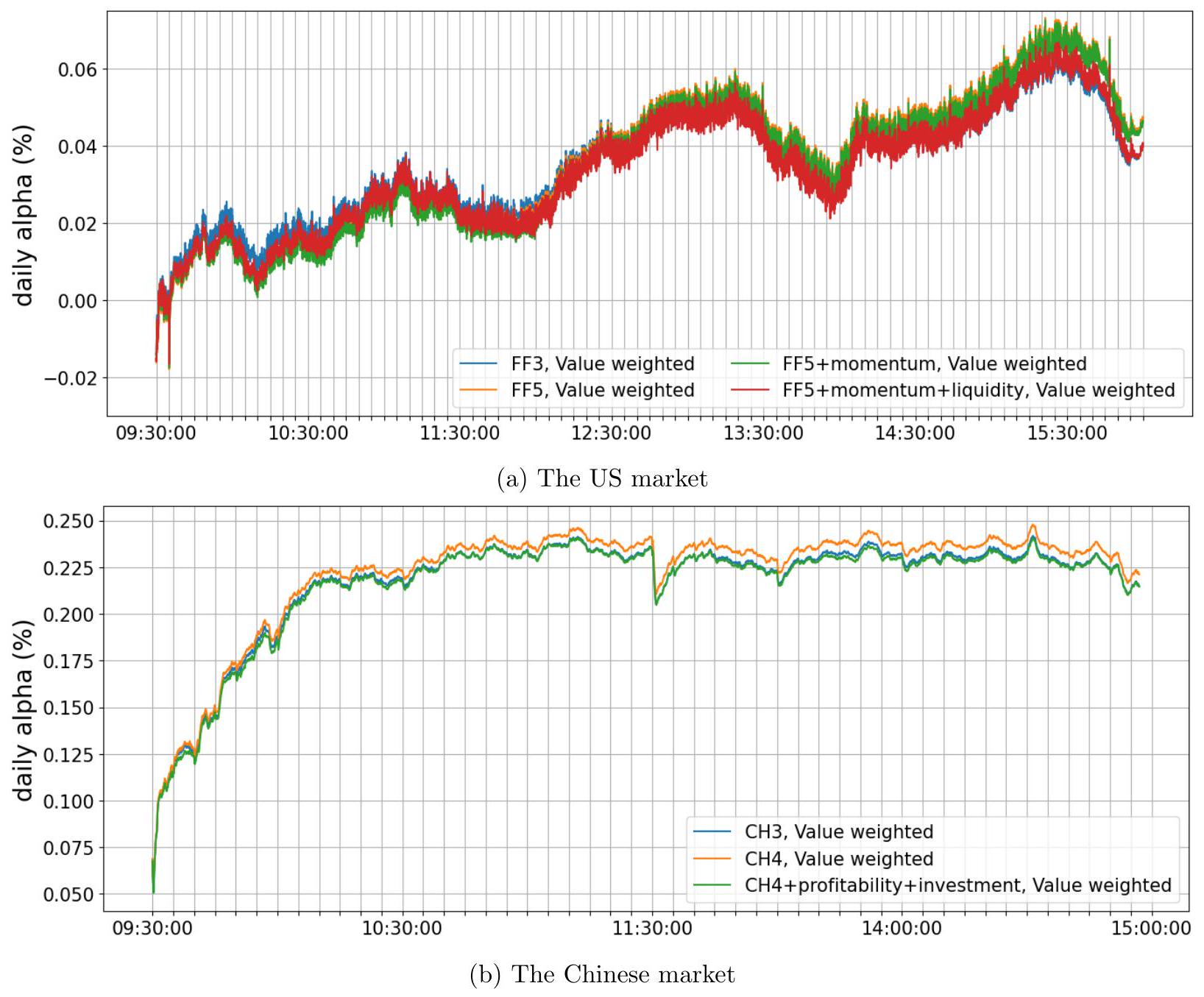

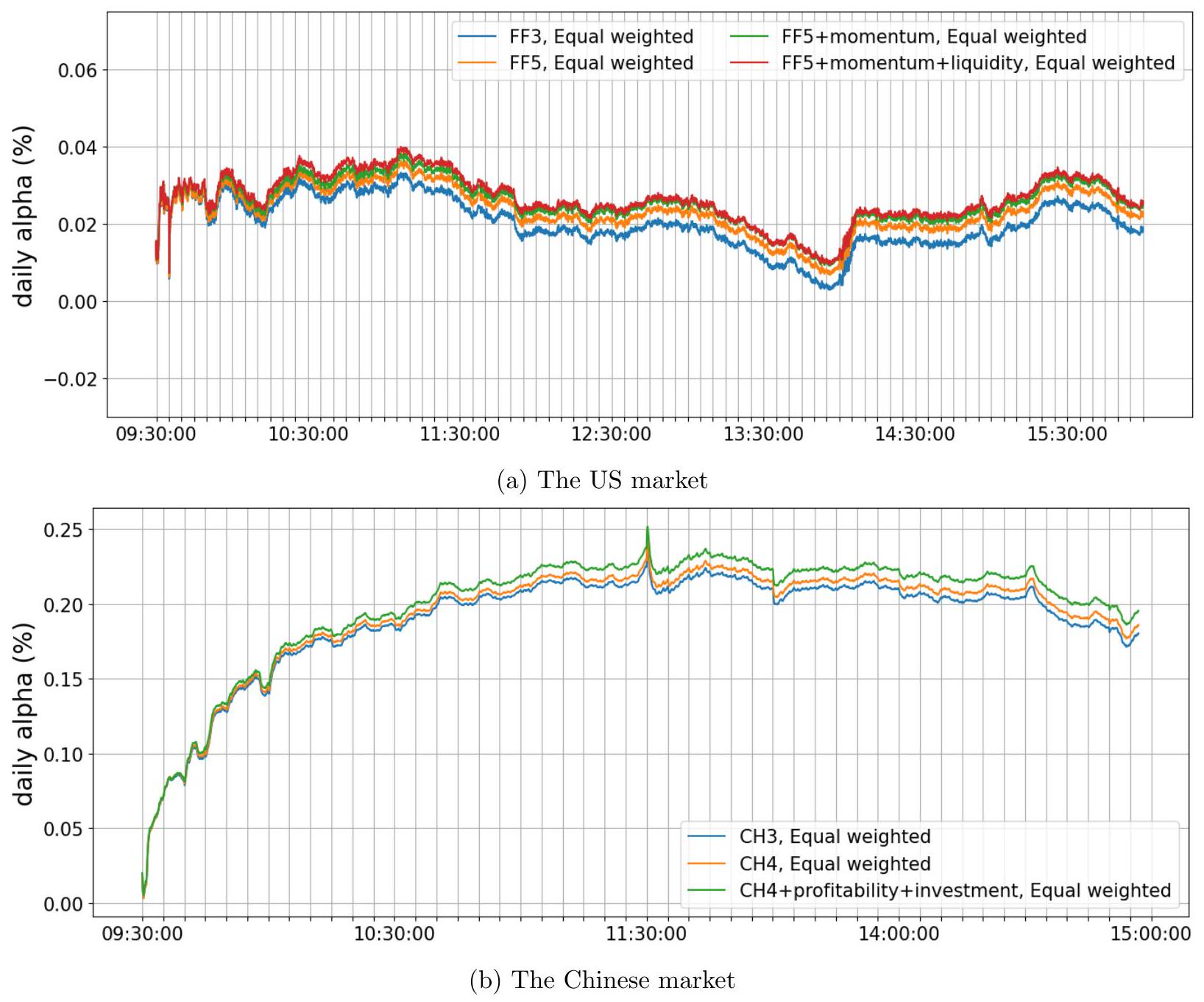

稳健性检验。我们通过每日或每周构建 PmS 投资组合,以及基于几个股票层面特征构建双重排序投资组合,来检验 PmS 超额回报的稳健性。

对于每日 PmS 投资组合,我们首先使用 (9) 式评估每只股票 $s$ 在每日 $d$ 的周期性强度,然后根据它们每日的 peri ${ }_{s, d}$ 值将股票分为五个五分位数。PmS 投资组合买入 peri ${ }_{s, d}$ 值最高的顶层五分位数组的股票,并卖出 peri $i_{s, d}$ 值最低的底层五分位数组的股票。每周的 $\operatorname{PmS}$ 投资组合也以类似方式构建。为了与表 8 的结果保持一致,我们在表 A.3 中展示了每日和每周 PmS 投资组合的月度 alphas。正如预期的那样,如果我们更频繁地再平衡投资组合,我们会获得一致甚至更高的超额回报。然而,我们也强调,这些结果没有考虑交易成本,当投资组合更频繁地再平衡时,这一点尤其重要。由于卖空限制和 $T+1$ 规则,中国市场每日再平衡的高 alphas 在实践中也是不现实的。

这部分是附录I的开篇,旨在对论文正文中关于PmS投资组合能够产生超额回报的核心发现,进行一系列严格的稳健性检验。

第一部分:引言与检验方法概述

- “稳健性检验”: 明确本节目的。

- “PmS 投资组合”: 这是论文核心策略的名称,PmS是"Periodicity-minus-Smooth"的缩写,意为“周期性强的”减去“周期性平滑(弱)的”。这是一个多空投资组合(long-short portfolio)。

- 核心发现回顾: 正文中(可能在表8)的发现是,买入交易量周期性最强的股票、同时卖空周期性最弱的股票,能够获得显著为正的超额回报(alpha)。

- 两种检验方法:

- 改变再平衡频率: “通过每日或每周构建 PmS 投资组合”。正文中的表8很可能是基于“每月”再平衡的。这里要检验,如果更频繁地调整投资组合,结论是否依然成立。

- 控制其他特征: “基于几个股票层面特征构建双重排序投资组合”。这是为了排除“PmS策略的超额回报其实是由其他已知因素(如波动率、流动性)驱动”的可能性。

第二部分:关于改变再平衡频率的详细说明

- “对于每日 PmS 投资组合”:

- 评估周期性强度: “使用 (9) 式评估每只股票 $s$ 在每日 $d$ 的周期性强度”。这意味着周期性强度指标 $peri_{s,d}$ 是每天都重新计算的,而不是像月度再平衡那样一个月才算一次。这使得排序的基础更加“新鲜”。

- 分组: “根据它们每日的 $peri_{s,d}$ 值将股票分为五个五分位数”。每天收盘后,将所有股票按照当天的周期性强度从高到低排序,切成5份。

- 构建投资组合: “买入...顶层五分位数...并卖出...底层五分位数组”。这就是PmS策略:做多前20%周期性最强的股票,做空后20%周期性最弱的股票。这个投资组合每天都调整一次。

- “每周的 PmS 投资组合也以类似方式构建”: 同理,只是计算和排序的频率是一周一次。

- 结果呈现: “在表 A.3 中展示了每日和每周 PmS 投资组合的月度 alphas”。

- 即使投资组合每天或每周都调仓,但为了与表8的月度alpha进行比较,作者仍然将这些更高频率的投资组合回报,汇总成月度数据,然后再对这些月度回报序列进行因子模型回归,得到“月度alpha”。

- 核心发现: “正如预期的那样,如果我们更频繁地再平衡投资组合,我们会获得一致甚至更高的超额回报。”

- 这是一个非常强的结论。它说明周期性这个信号可能是一个相对短期的alpha来源,更频繁地捕捉它,收益更高。

- “一致”:符号和显著性不变。“更高”:alpha的绝对值变大。

第三部分:对高频再平衡结果的审慎讨论

- “然而,我们也强调...”: 作者在这里展现了严谨的学术态度,主动指出了上述发现的现实局限性。

- 局限1:交易成本: “这些结果没有考虑交易成本”。

- 每天都对投资组合进行完全的调仓,会产生巨大的交易成本(佣金、买卖价差、市场冲击成本等)。这些成本在学术研究中经常被忽略,但在真实投资中,它们很可能会完全侵蚀掉甚至超过理论上的超额回报。

- 局限2:中国市场的实际操作限制:

- 卖空限制 (short-selling constraints): 在中国A股市场,融券卖空不仅券源稀少、成本高昂,而且对可卖空的标的和投资者都有诸多限制。这使得构建一个大规模的、系统的多空投资组合非常困难。

- T+1 规则: 中国A股实行T+1交易制度,即当天买入的股票,下一个交易日才能卖出。这使得“每日再平衡”——即在一天内卖出旧组合、买入新组合——在技术上几乎不可能完美实现。例如,如果一个股票今天仍在投资组合中,但根据今天的peri值计算,明天应该被剔除,你最早也只能在明天才能卖掉它。

- 结论: “中国市场每日再平衡的高 alphas 在实践中也是不现实的”。作者非常坦诚地承认,在中国市场背景下,每日再平衡策略的惊人alpha值,更像是一个理论上的数字游戏,缺乏实际可操作性。

- 示例1: 每日再平衡流程

- 周一收盘后: 计算所有股票在周一当天的 $peri$ 值。假设股票A的peri值排在前20%,股票B的排在后20%。

- 周二开盘: 买入1元钱的股票A,卖空1元钱的股票B。

- 周二收盘后: 重新计算所有股票在周二的 $peri$ 值。发现现在是股票C排在前20%,股票D排在后20%。

- 周三开盘: 卖出周二持有的股票A,买回股票B平仓。然后,买入1元钱的股票C,卖空1元钱的股票D。

- 这个过程每天重复。

- 示例2: Alpha的对比(假设)

- 表8 (月度再平衡): PmS策略的FF5+Momentum Alpha = 0.8% / 月。

- 表A.3 (每周再平衡): PmS策略的FF5+Momentum Alpha 可能上升到 1.0% / 月。

- 表A.3 (每日再平衡): PmS策略的FF5+Momentum Alpha 可能进一步上升到 1.5% / 月。

- 加入交易成本后 (现实): 假设每日再平衡的双边交易成本高达0.5%。那么每天的策略收益都需要减去0.5%。一个月大约20个交易日,总成本可能高达 20 * 0.5% = 10%。1.5%的月度alpha在10%的成本面前不堪一击。

- Alpha的计算: Alpha是在控制了多种风险因子(如FF3, FF5, 动量等)之后剩下的超额回报。高alpha意味着回报不能被传统风险因素解释。

- “不现实”的程度: 作者说中国市场每日再平衡“不现实”,这主要指其系统性、大规模的应用。对于资金量不大、策略灵活的个人或小型私募,利用T+0底仓等技巧,在小范围内进行高频交易仍然是可能的,但难以形成稳健、可扩展的PmS策略。

- 忽略了冲击成本: 除了交易佣金和价差,频繁交易大额资金还会对价格产生冲击(market impact),即你的买单会推高价格,卖单会压低价格,这是一种隐含的、更难测量的交易成本。

本段描述了对PmS策略的第一个稳健性检验:改变再平衡频率。研究发现,将调仓频率从月度提高到每周、每日,策略的理论超额回报(alpha)会进一步增加。然而,作者也严谨地指出,这个发现在现实中受到交易成本的严重制约,并且由于卖空和T+1规则的限制,在中国市场尤其不具备可操作性。这体现了理论研究与投资实践之间的差距。

- 检验alpha来源的期限结构: 通过测试不同频率的再平衡,探索这个alpha信号是长期的还是短期的。结果表明它偏短期,这为理解其背后驱动因素(例如,可能是对短期信息不对称的补偿)提供了线索。

- 展示结论的强度: “更频繁再平衡,alpha更高”本身是一个很强的结果,它说明周期性强度这个指标的有效性非常高,即使在很高频率上也能预测回报。

- 体现研究的客观与审慎: 主动讨论交易成本和市场制度限制,是学术严谨性的重要体现。它避免了过度夸大研究发现的实践价值,向读者传达了一个平衡、客观的观点,增加了论文的整体可信度。

想象你在玩一个“猜天气”赚钱的游戏。

- 正文策略(月度再平衡): 你每个月1号预测一次本月哪个城市晴天最多、哪个城市雨天最多,然后下注。你发现这样能稳定赚钱(正alpha)。

- 稳健性检验(每日再平衡): 你现在每天早上都根据最新的卫星云图,预测今天哪个城市晴天、哪个雨天,然后下注。

- 发现: 你发现每天预测、每天下注,赚的钱比一个月预测一次多得多(alpha更高)。因为天气预报越临近越准。

- 现实的限制(交易成本等): 但是,你每次下注都要交一笔手续费。每天都下注,一个月下来手续费惊人,可能把你赚的钱都亏进去了。而且,游戏规则可能不允许你卖空“雨天”的城市的股票(卖空限制),而且你今天下的注明天才能结算(T+1)。

- 结论: 理论上,每天根据新信息调整策略是最好的。但实践中,成本和规则让这个最优策略变得不可行。

想象你是一名F1赛车手。

- 赛车(投资组合): 你的赛车。

- 路况信息(peri值): 你的团队通过无线电给你的实时路况信息(比如前方哪个弯道有油渍,哪个弯道很干净)。

- 正文策略(月度再平衡): 相当于团队每跑10圈才给你一次路况更新。你根据这个过时的信息调整驾驶策略,也能取得不错的成绩。

- 稳健性检验(每日再平衡): 相当于团队每个弯道都给你实时更新路况。

- 发现: 显然,根据实时信息调整驾驶策略,你的圈速会快得多(alpha更高)。

- 现实的限制(交易成本等): 但是,每次你根据新信息调整驾驶(比如改变刹车点、走线),都会额外消耗轮胎和燃油(交易成本)。如果过于频繁地调整,可能导致你因为轮胎磨损过快或燃油耗尽而被迫提前进站,反而输掉比赛。在中国市场的限制,就好比规则禁止你在某些弯道使用DRS(卖空限制),并且你踩下刹车后,刹车片要延迟1秒才起作用(T+1)。

📜 [原文19]

此外,如 5.1.2 节所示,股票的 peri 值与算法交易水平和波动率正相关。知情的算法交易者导致了市场中的信息不对称,并影响股票回报 $\sqrt{ }$ 波动率也已知会影响预期股票回报。因此,PmS 投资组合的回报可能会与算法交易和波动率的回报效应相混淆 37 。

我们遵循 Fama and French (1993, 2015) 和 Amihud et al. (2015) 的方法,通过计算每个月每只股票在 5.1.2 节中定义的 mess、nvdmess、oddrat 和 vol 的值来构建双重排序投资组合。对于这些特征中的每一个,我们将股票预先分为三个投资组合,并在每个三分位数内,根据它们的 peri 值进一步将股票分为五个五分位数。因此,我们获得了 $3 \times 5=15$ 个投资组合,每个投资组合中的股票数量相等。因此,顶层(底层)peri 五分位数投资组合由选定特征的三个水平上的三个顶层(底层)投资组合组成。表 A. 4 展示了这些双重排序 PmS 投资组合的月度 alphas,在控制了这些预排序特征后,我们仍然获得了一致的超额回报。

这部分描述了对PmS策略的第二个,也是更重要的稳健性检验:双重排序 (double sort)。其目的是为了厘清PmS策略的超额回报究竟是来源于“周期性”这个新因子,还是仅仅因为它“搭便车”,混淆了其他已知因子的效果。

第一部分:提出问题——潜在的混淆效应

- 回顾已知关系: 作者首先提醒读者在“5.1.2节”已经证明过的事实:

- peri 值(周期性强度)与“算法交易水平”正相关。

- peri 值与“波动率”正相关。

- 建立逻辑链条:

- 高 peri -> 高算法交易水平。

- “知情的算法交易者”会利用信息优势,导致“信息不对称”。

- 信息不对称是金融学中一个已知的、会影响股票回报的因素(通常认为信息不对称程度高的股票,其风险更高,要求的回报也更高)。

- 高 peri -> 高波动率。

- “波动率”本身也是一个著名的、会影响预期股票回报的因子(高波动率股票通常有更高的预期回报,即所谓的“波动率异象”)。

- 提出核心质疑 (The Confounding Story):

- “因此,PmS 投资组合的回报可能会与算法交易和波动率的回报效应相混淆”: 这是本节检验要解决的核心问题。

- 质疑的逻辑是: PmS策略买入高peri股,卖出低peri股。但因为高peri股恰好也是高算法交易、高波动率的股票,所以PmS策略可能只是在无意中执行了一个“买入高算法交易股/高波动率股,卖出低算法交易股/低波动率股”的策略。如果“算法交易水平”或“波动率”本身就能带来超额回报,那么PmS策略的alpha就不是“周期性”的功劳,而只是对这些已知效应的“二次包装”。

第二部分:解决方法——双重排序投资组合

- 方法论来源: “遵循 Fama and French (1993, 2015) 和 Amihud et al. (2015) 的方法”。引用这些金融实证领域的奠基性文献,表明他们采用的是领域内公认的、最标准、最无可辩驳的方法来解决混淆因子问题。

- 控制变量的代理指标 (Proxies):

- 作者选择了四个在“5.1.2节”定义过的指标,作为“算法交易水平”和“波动率”的代理变量:mess, nvdmess, oddrat, 和 vol。

- 虽然这里没有定义,但可以猜测:vol显然是波动率;mess, nvdmess, oddrat可能是衡量算法交易或信息不对称的指标(比如与订单簿、交易规模相关的指标)。

- 双重排序的具体流程:

- 第一次排序 (Pre-sorting): 每个月初,对所有股票,先按照某一个控制变量(比如 vol)的值从低到高排序,然后平均分成三组(三个三分位数):低vol组,中vol组,高vol...

组。

- 第二次排序 (Second Sort): “并在每个三分位数内,根据它们的 peri 值进一步将股票分为五个五分位数”。

- 现在,我们有了三个“桶”的股票。我们独立地在每个桶内进行操作。

- 在“低vol组”内部,将这些股票按 peri 值从高到低排序,切成5份(五个五分位数)。

- 同样,在“中vol组”和“高vol组”内部,也分别按 peri 值排序并切成5份。

- 构建最终投资组合与结果:

- “因此,我们获得了 $3 \times 5=15$ 个投资组合”。这15个投资组合是双重特征的产物,例如,有一个投资组合是“低vol,最高peri”的股票,另一个是“高vol,最低peri”的股票。

- “因此,顶层(底层)peri 五分位数投资组合由选定特征的三个水平上的三个顶层(底层)投资组合组成。” 这句话定义了最终用来计算alpha的投资组合。最终的“顶层投资组合”是把三个桶里的“最高peri投资组合”合并起来(即“低vol-高peri” + “中vol-高peri” + “高vol-高peri”)。最终的“底层投资组合”同理。

- 通过这种方式构建的PmS策略(买入合并后的顶层投资组合,卖出合并后的底层投资组合),其 vol 特征在多头和空头两端是“平衡”的。因为多头和空头都包含了来自低、中、高vol组的股票。因此,这个策略的回报,理论上已经剔除了vol因子的影响。

第三部分:检验结果

- “表 A. 4 展示了这些双重排序 PmS 投资组合的月度 alphas”: 引用了结果所在的表格。

- “在控制了这些预排序特征后,我们仍然获得了一致的超额回报”: 这是本节稳健性检验的最终、也是最重要的结论。

- “一致的” (consistent): 意味着alpha仍然为正,并且统计上显著。

- 这意味着: 即使在剔除了vol(以及mess, nvdmess, oddrat)的影响后,“周期性强度”(peri)本身仍然能够预测股票回报。这强有力地证明了PmS策略的超额回报并非来自对波动率等已知因子的简单敞口,而是来源于一个新的、独立的alpha来源,即“周期性”。

- 示例1: 双重排序流程

假设市场总共有300只股票。我们想控制波动率(vol)因子。

- 第一次排序: 按vol排序,分为三组,每组100只股票。

- 低vol组: 100只

- 中vol组: 100只

- 高vol组: 100只

- 第二次排序:

- 在低vol组的100只股票内部,按peri值排序,分为5组,每组20只。我们得到“低vol-最高peri”的20只股票,...,“低vol-最低peri”的20只股票。

- 在中vol组和高vol组内部做同样操作。

- 构建PmS投资组合:

- 多头 (Long Portfolio): 由以下三组共60只股票组成:

- “低vol-最高peri”的20只

- “中vol-最高peri”的20只

- “高vol-最高peri”的20只

- 空头 (Short Portfolio): 由以下三组共60只股票组成:

- “低vol-最低peri”的20只

- “中vol-最低peri”的20只

- “高vol-最低peri”的20只

- 计算回报: 计算这个多空投资组合的月度回报序列,然后回归得到alpha。

- 示例2: Alpha结果的解读

- 简单PmS策略 (未控制vol): Alpha = 1.0% / 月。

- 质疑: 可能是因为这个策略买的高peri股恰好都是高vol股,而高vol本身就能带来1.0%的回报。

- 双重排序后的PmS策略: Alpha = 0.7% / 月。

- 结论: Alpha虽然有所下降(从1.0%到0.7%),但仍然是显著为正的。这说明,原始1.0%的alpha中,有0.3%确实是来自对vol因子的敞口,但剩下的0.7%是peri因子“纯粹”的贡献。因此,peri是一个独立的alpha来源。

- 排序的顺序: Fama-French标准方法中,先按哪个变量排序,后按哪个变量排序,可能会对结果有细微影响。这里是先按控制变量(vol等)排序,再按测试变量(peri)排序。

- 断点的选择: 这里使用了三分位数和五分位数。其他研究可能使用十分位数等。断点的选择会影响每个投资组合的股票数量和纯度。

- 控制变量的选择: 双重排序的有效性,取决于是否选择了正确的、真正与peri相关的控制变量。如果peri的回报还与其他某个未被测试的因子X相关,那么即使在控制了vol之后,得到的alpha也可能混淆了X因子的效应。

本段详细阐述了如何通过构建“双重排序投资组合”这一经典方法,来检验PmS策略的超额回报是否仅仅是对波动率或算法交易水平等已知效应的模仿。流程是先按控制变量(如波动率)将股票分组,再在各组内按周期性强度(peri)排序并构建多空投资组合。结果(将在表A.4中展示)表明,即使在控制了这些已知特征后,PmS策略依然能获得显著的超额回报。这强有力地证明了“周期性”是一个独立于已知因子的、新的alpha来源。

- 解决混淆因子问题 (Address Confounding Factors): 这是本段最核心的学术目的。在实证资产定价中,证明一个新因子是否独立、不被已知因子解释,是其是否具有学术价值和实践意义的关键一步。双重排序是完成这一步的黄金标准。

- 增强结论的可靠性: 通过这一最严格的检验,论文的核心发现——周期性可以预测回报——变得极为可信和稳健。它排除了最可能的一种“另类解释”。

- 展示研究的深度与专业性: 能够娴熟地运用Fama-French的双重排序方法,表明作者具备进行高水平实证金融研究的专业素养,极大地提升了论文的学术分量。

想象你要证明“爱运动的学生成绩更好”这个论点。

- 原始发现: 你发现,校运动队的学生(高peri),平均成绩确实比不做运动的学生(低peri)要高(正alpha)。

- 质疑 (混淆因子): 一个老师质疑你:“这可能不是因为运动本身,而是因为能进校队的,都是些精力充沛、聪明自律的学生(高vol/高算法交易水平)。是‘精力充沛’这个特质,同时导致了他们运动好和成绩好。你只是发现了‘精力充沛’能带来好成绩而已。”

- 解决方法 (双重排序):

- 你先把全校学生按“精力充沛”程度分为三组:低、中、高精力组。

- 在“低精力”组内部,你再按运动水平分为5档。同样,在中、高精力组内部也这么做。

- 你构建一个“新运动组”:从低、中、高三个精力组里,都选出运动水平最高的那一拨人。构建一个“新非运动组”同理。

- 结果: 你发现,这个新的、在“精力”上平衡的“新运动组”,其平均成绩依然显著高于“新非运动组”。

- 结论: 这就证明了,即使在控制了“精力充沛”这个因素之后,运动本身对成绩也确实有独立的积极影响。

想象你要证明一种新的化肥(peri因子)能显著提高水稻产量(超额回报)。

- 初步实验: 你发现,用了新化肥的稻田,产量确实比没用的高。

- 质疑 (混淆因子): 邻居老王说:“你那几块用了新化肥的田,恰好都是阳光最好、水分最足的向阳坡地(高vol地块)。是地好,不是化肥好。”

- 解决方法 (双重排序):

- 你把所有土地按“好坏”(阳光、水分)分为三类:差、中、好。

- 在“差地”里,你选一半用新化肥,一半不用。

- 在“中地”和“好地”里,也做同样操作。

- 结果: 你发现,即使是在同一类“差地”里,用了新化肥的产量也比没用的高。在“好地”里也是如此。

- 结论: 你现在可以非常有信心地说,这种新化肥本身确实有效,其效果独立于土地质量的好坏。你成功地将“化肥效应”和“土地效应”分离开来。

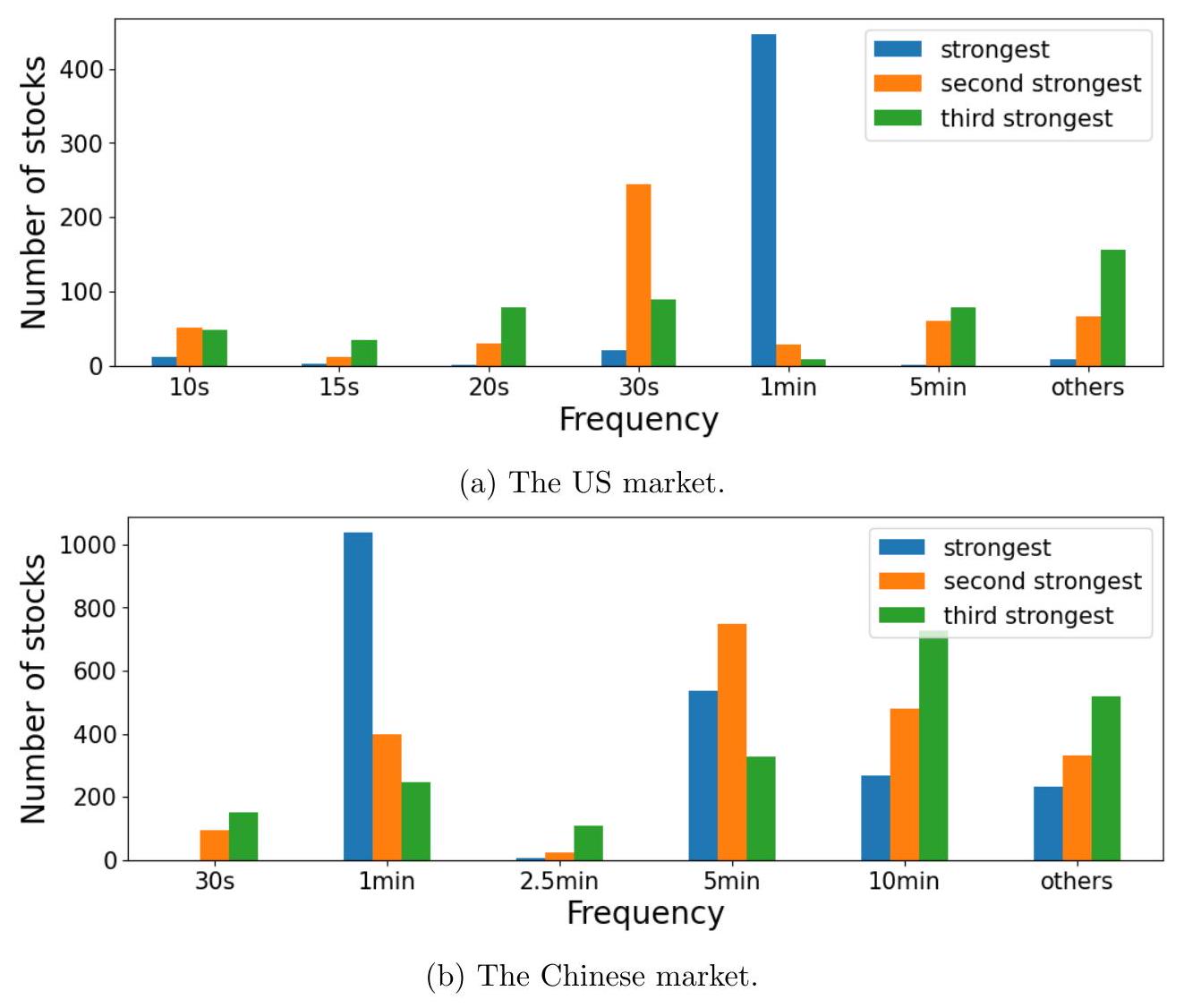

[^24]表 A.3:按周期性强度 peri 排序的投资组合的月度 alphas,在不同再平衡频率下,并基于日回报回归控制不同资产定价因子。最后一列展示了周期性减平滑(PmS)投资组合,该投资组合买入/卖出顶层/底层五分位数组的股票。在美国市场(A、B、C 和 D 组),我们控制了 Fama-French 三因子(FF3)和五因子(FF5)、Carhart(1997)的动量因子,以及 Amihud et al. (2015) 的流动性风险因子(ImL)。在中国市场(E、F、G 和 H 组),我们控制了 Liu, Stambaugh, and Yuan (2019) 的市场、规模和价值因子(CH3),Liu, Stambaugh, and Yuan (2019) 的流动性风险因子(PmO),以及 Fama-French 的盈利能力(RmW)和投资(CmA)因子。估计的 alphas 在 1% ()、5% () 或 10% () 的水平上显著。

| 资产定价模型 | 顶层 | 第二层 | 中间层 | 第四层 | 底层 | PmS |

| :------------------------------------------- | :--------- | :-------- | :--------- | :--------- | :--------- | :--------- |

| A 组:美国市场;等权重投资组合;每日再平衡 | | | | | | |

| FF3 | 0.93\% | 0.20\% | -0.06\% | 0.13\% | -0.05\% | 0.97\% |

| FF5 | 0.93\% | 0.15\% | -0.14\% | 0.09\% | -0.14\% | 1.07\% |

| FF5 + momentum | 0.88\% | 0.11\% | -0.19\% | 0.03\% | -0.20\% | 1.08\% |

| FF5 + momentum + liquidity | 0.85\% | 0.07\% | -0.19\% | 0.05\% | -0.20\% | 1.05\% |

| B 组:美国市场;价值加权投资组合;每日再平衡 | | | | | | |

| FF3 | 1.80\% | 0.20\% | 0.29\% | 0.16\% | -0.50\% | 2.31\%* |

| FF5 | 1.70\% | 0.13\% | 0.15\% | 0.11\% | -0.54\% | 2.26\%* |

| FF5 + momentum | 1.70\%* | 0.14\% | 0.12\% | 0.09\% | -0.58\% | 2.29\%*** |

| FF5 + momentum + liquidity | 1.74\%* | 0.08\% | 0.18\% | 0.14\% | -0.56\% | 2.31\%*** |

| C 组:美国市场;等权重投资组合;每周再平衡 | | | | | | |

| FF3 | 0.60\%*** | 0.11\% | 0.36\% | 0.11\% | -0.02\% | 0.62\%* |

| FF5 | 0.59\%*** | 0.08\% | 0.28\% | 0.04\% | -0.08\% | 0.68\%* |

| FF5 + momentum | 0.57\%* | 0.05\% | 0.21\% | -0.02\% | -0.17\% | 0.74\% |

| FF5 + momentum + liquidity | 0.55\%* | 0.03\% | 0.19\% | -0.04\% | -0.14\% | 0.70\% |

| D 组:美国市场;价值加权投资组合;每周再平衡 | | | | | | |

| FF3 | 1.35\% | 0.43\% | 0.25\% | 0.23\% | -0.19\% | 1.54\%* |

| FF5 | 1.24\% | 0.37\% | 0.18\% | 0.13\% | -0.21\% | 1.45\% |

| FF5 + momentum | 1.23\% | 0.33\% | 0.17\% | 0.11\% | -0.20\% | 1.43\% |

| FF5 + momentum + liquidity | 1.24\% | 0.37\% | 0.14\% | 0.13\% | -0.13\% | 1.38\% |

| E 组:中国市场;等权重投资组合;每日再平衡 | | | | | | |

| CH3 | 18.30\% | 1.29\% | -3.89\% | -6.82\% | -8.24\% | 28.80\% |

| CH3 + liquidity (CH4) | 18.39\% | 1.28\% | -3.93\% | -6.86\% | -8.29\% | 28.96\% |

| CH4 + profitability + investment | 18.65\% | 1.41\% | -3.83\% | -6.79\% | -8.26\% | 29.20\% |

| F 组:中国市场;价值加权投资组合;每日再平衡 | | | | | | |

| CH3 | 12.45\% | 1.33\% | -2.96\% | -5.72\% | -7.46\% | 21.43\% |

| CH3 + liquidity (CH4) | 12.51\% | 1.34\% | -2.97\% | -5.76\% | -7.52\% | 21.56\% |

| CH4 + profitability + investment | 12.45\% | 1.20\% | -3.13\% | -5.84\% | -7.57\% | 21.57\% |

| G 组:中国市场;等权重投资组合;每周再平衡 | | | | | | |

| CH3 | 4.73\% | 1.67\% | -0.55\% | -2.48\% | -4.59\% | 9.74\% |

| CH3 + liquidity (CH4) | 4.81\% | 1.67\% | -0.58\% | -2.54\% | -4.65\% | 9.89\% |

| CH4 + profitability + investment | 5.03\% | 1.83\% | -0.50\% | -2.47\% | -4.63\% | 10.11\%* |

| H 组:中国市场;价值加权投资组合;每周再平衡 | | | | | | |

| CH3 | 4.44\% | 2.12\% | -0.06\% | -1.91\% | -4.09\% | 8.88\%*** |

| CH3 + liquidity (CH4) | 4.50\% | 2.12\% | -0.08\% | -1.96\% | -4.15\% | 9.00\%*** |

| CH4 + profitability + investment | 4.43\% | 2.03\% | -0.26\% | -2.06\% | -4.20\% | 8.99\%*** |

这部分是对表A.3的详细解读。这张表格是上一段文字描述的“改变再平衡频率”这一稳健性检验的核心结果展示。

第一部分:表格标题和说明解读

- 核心内容: 表格展示的是“按周期性强度 peri 排序的投资组合的月度 alphas”。Alpha是在控制了多种资产定价因子后的超额回报,是衡量策略有效性的黄金标准。

- 排序方式: 股票根据peri值被分为五个五分位数(顶层、二、三、四、底层)。

- 再平衡频率: 表格包含了不同再平衡频率下的结果(每日、每周),这是与正文表8(可能是每月)的核心区别。

- PmS投资组合: “最后一列展示了...PmS投资组合,该投资组合买入/卖出顶层/底层五分位数组的股票”。这是多空对冲策略的结果,即 顶层回报 - 底层回报 的alpha。

- 控制因子 (Control Factors):

- 美国市场: 使用了全球标准的因子模型。

- FF3: Fama-French三因子模型(市场、规模、价值)。

- FF5: Fama-French五因子模型(在FF3基础上增加盈利能力和投资风格因子)。

- Momentum: Carhart四因子模型,增加了动量因子。

- Liquidity (ImL): Amihud的非流动性因子,控制了流动性风险。

- 中国市场: 使用了针对中国A股市场特点调整的因子模型。

- CH3: Liu, Stambaugh, and Yuan (2019)提出的中国版三因子模型。

- Liquidity (PmO): 同样来自LSY(2019)的中国市场流动性因子。

- Profitability (RmW) 和 Investment (CmA): Fama-French的盈利和投资因子,也应用于中国市场。

- 显著性水平: 代表在1%水平上显著(极强证据),代表5%(强证据),代表10%(较弱证据)。

第二部分:表格数据解读与核心洞察

总体趋势:

- 单调性: 在几乎所有组别中,alpha值从“顶层”到“底层”呈现出大致单调递减的趋势。即peri值越高的投资组合,其alpha越高;peri值越低的,alpha越低(甚至是显著为负)。这清晰地证明了peri值对股票回报的预测能力。

- PmS策略的有效性: 最后一列“PmS”的alpha值几乎全部是显著为正的,并且数值上远大于任何单个五分位数组的alpha。这表明多空策略能够有效地放大信号、对冲市场风险,并获得稳健的超额回报。

具体组别分析:

- A组 vs C组 (美国,等权重):

- A组 (每日再平衡) 的PmS alpha在1%左右 (如FF5+mom下为1.08%)。

- C组 (每周再平衡) 的PmS alpha在0.7%左右 (如FF5+mom下为0.74%)。

- 洞察: 每日再平衡的alpha显著高于每周再平衡,印证了“更频繁再平衡,alpha更高”的结论。

- B组 vs D组 (美国,价值加权):

- B组 (每日) 的PmS alpha高达2.3%左右。

- D组 (每周) 的PmS alpha也高达1.4%左右。

- 洞察1: 价值加权的alpha显著高于等权重的alpha。这在美国市场是一个非常有趣的现象,通常很多因子在价值加权下会减弱。这可能意味着peri这个因子在大市值股票上表现得尤其好。

- 洞察2: 同样,每日再平衡的alpha远高于每周。

- E, F, G, H组 (中国市场):

- 惊人的Alpha: 中国市场的alpha数值极其巨大。例如E组(等权重,每日),PmS alpha高达令人难以置信的 28.80%每月!F组(价值加权,每日)也高达 21.43%。

- 频率效应: 每周再平衡的alpha(G组9.74%,H组8.88%)虽然仍然极高,但远低于每日再平衡。这再次强力证明了信号的短期有效性。

- 现实性警示: 正如原文所说,这些惊人的数字主要是理论上的。由于卖空限制和T+1规则,这个策略在中国无法按日执行。但它揭示了peri这个因子在中国市场具有极强的预测能力,即使是每周再平衡的9%月度alpha,在理论上也极具吸引力。

- 不同因子模型下的稳定性:

- 在美国市场,从最简单的FF3到最复杂的FF5+mom+liq模型,PmS的alpha始终保持显著为正,且数值稳定。这表明peri策略的回报不能被这些主流的风险因子所解释。

- 在中国市场,加入流动性、盈利、投资因子后,alpha也基本保持不变。

- 示例1: 读懂A组第一行

- FF3 | 0.93% | ... | -0.05% | 0.97%

- 解读:

- 构建一个等权重的、每日根据peri值最高20%股票池调仓的投资组合(顶层)。这个投资组合的月度回报,在用Fama-French三因子模型进行风险调整后,仍然有0.93%的无法解释的超额回报,且在1%的水平上统计显著。

- 构建一个做多“顶层”投资组合、做空“底层”投资组合的PmS策略。该策略的月度alpha为0.97%,同样在1%水平上显著。理论上 0.97% ≈ 0.93% - (-0.05%) (由于回归的性质,不完全精确相等)。

- 示例2: 理解中国市场E组的巨大alpha

- CH3 | 18.30% | ... | -8.24% | 28.80%***

- 解读:

- 如果一个投资组合每天都买入当天周期性最强的前20%的A股股票(等权重),一个月下来,其理论超额回报(CH3 alpha)高达18.30%。

- 同时做空周期性最弱的20%股票(其alpha为-8.24%,即本身就在亏钱),那么多空对冲后的理论alpha将是惊人的28.80%每月。这个数字虽然不现实,但它衡量了信号的“纯粹强度”。

- Alpha不等于总回报: Alpha是风险调整后的回报。一个投资组合的总回报可能是负的,但如果它在市场大跌时跌得比模型预期的少,它仍然可以有正的alpha。

- 等权重 vs 价值加权: 等权重给每只股票相同的权重,更能反映“平均股票”的表现。价值加权则给市值大的股票更高权重,更能反映“投资组合总资金”的表现。两者结果的差异揭示了因子在不同市值股票上的表现。

- 忽略星号: 必须关注alpha值旁边的星号。没有星号的alpha值(如A组第二层的0.20%),意味着它在统计上与0没有区别,很可能是由随机性造成的。

表A.3是关于PmS策略的第一个稳健性检验——改变再平衡频率——的详细结果。表格通过展示不同市场、不同加权方式、不同再平衡频率下的多空投资组合alpha,强有力地证明了:1) peri因子对股票回报具有显著的、单调的预测能力;2) PmS策略能获得无法被主流资产定价模型解释的稳健超额回报;3) 这种超额回报在更高频的再平衡下会更高,尤其是在中国市场,尽管其可操作性存疑。

- 提供详细的实证证据: 作为上一段文字论述的直接数据支撑。文字部分说“alpha更高”,表格则精确地展示了高多少,以及在何种条件下。

- 展示研究的全面性: 通过展示跨越两个市场、两种加权方式、多种因子模型的结果,表明作者进行了全面、细致的实证分析,增强了研究的说服力。

- 为理论与实践的讨论提供素材: 表格中理论alpha之高,与上一段对交易成本和制度限制的讨论,共同构成了一个关于理论模型与现实投资之间鸿沟的深刻案例。

想象一个“识马比赛”。peri是你的“相马术”。

- 表格: 就是你的战绩报告。

- 顶层/底层: 你相中的“千里马”/“驽马”组。

- PmS: 你下注“千里马”赢、同时下注“驽马”输的对冲策略。

- Alpha: 在排除了所有已知的马匹血统、过往战绩、骑师水平(FF3, FF5等)的影响后,你的“相马术”本身能带来的稳定收益。

- 每日/每周再平衡: 你每天/每周都去马场重新相一次马,调整你的赌注。

- 表格A.3告诉你:

- 你的相马术非常准,你选的马确实跑得快,选的驽马确实跑得慢(alpha单调性)。

- 你的对冲策略稳定赚钱(PmS alpha显著为正)。

- 你越是频繁地去马场相马,赚得越多(每日alpha > 每周alpha > 每月alpha)。

- 在中国赛马场,你的相马术简直是“神技”,理论上能赚大钱(中国市场alpha极高)。但报告附注说,中国赛马场规则特殊,不允许你这么下注(不现实)。

表 A.4:基于周期性强度 peri 的双重排序 PmS 投资组合的月度 alphas,基于日回报回归控制了不同的预排序特征和不同的资产定价因子。在美国市场(A 和 B 组),我们控制了 Fama-French 三因子(FF3)和五因子(FF5)、Carhart(1997)的动量因子,以及 Amihud et al. (2015) 的流动性风险因子(ImL)。在中国市场(C 和 D 组),我们控制了 Liu, Stambaugh, and Yuan (2019) 的市场、规模和价值因子(CH3),Liu, Stambaugh, and Yuan (2019) 的流动性风险因子(PmO),以及 Fama-French 的盈利能力(RmW)和投资(CmA)因子。估计的 alphas 在 1% ()、5% () 或 10% () 的水平上显著。

| 资产定价模型 | 预排序特征 | | | |

| :------------------------------- | :--------- | :-------- | :-------- | :-------- |

| | mess | nvdmess | oddrat | vol |

| A 组:美国市场;等权重投资组合 | | | | |

| FF3 | 0.33\% | 0.47\% | 0.72\%* | 0.33\% |